На днях инженеры Facebook подробно рассказали об энергоэффективных технологиях, которые применялись при строительстве «первого» центра обработки данных компании в городе Прайнвилл, штат Орегон (США). Вся полезная информация содержится в видеоролике (на английском), размещенном на официальной странице компании.

На днях инженеры Facebook подробно рассказали об энергоэффективных технологиях, которые применялись при строительстве «первого» центра обработки данных компании в городе Прайнвилл, штат Орегон (США). Вся полезная информация содержится в видеоролике (на английском), размещенном на официальной странице компании.

Специалисты компании рассказали о работе по внедрению системы естественного воздушного охлаждения, а также о том, как усилия по развитию стандарта Open Compute способствовали повышению эффективности серверного оборудования. Инженеры крупнейшей соцсети планеты рассказывают о механизмах повторного использования воды, а также о находящейся рядом с дата-центром солнечной ферме.

Экологичный дата-центр соцсети

Операторы дата-центра Facebook очищают практически всю отработанную воду из системы охлаждения объекта и используют ее в местных уборных, а также для полива газонов. Причем изначально жидкость собирается с помощью дождевых стоков и механизмов конденсации. «Мы используем на 70% меньше воды, чем традиционные дата-центры», сказал Кен Пратчетт, который трудится в прайнвиллском ЦОД Facebook. Но наибольшее повешение энергоэффективности и нивелирование негативного влияния объекта на окружающую среду достигается за счет использования естественного воздушного охлаждения.

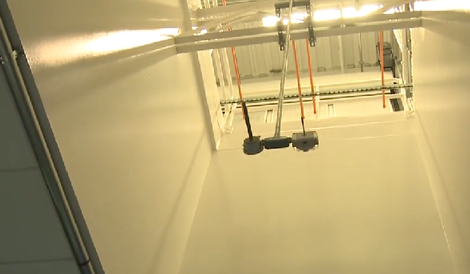

Воздуховод дата-центра Facebook в Прайнвилле

Холодный наружный воздух поступает внутрь объекта через решетку в «пентхаусе» (на втором этаже), а жалюзи регулируют объем его подачи. Затем воздушные массы проходят через «комнату смешивания», где наружный воздух, если необходимо поднять его температуру, смешивается с теплым потоком из “горячего” коридора. Затем холодный воздух проходит через серию воздушных фильтров и испарительных панелей, после чего он пропускается через еще один фильтр для поглощения влаги.

В ЦОД Facebook используется структура с двумя уровнями надежности, согласно которой серверы отделены от инфраструктуры охлаждения, что позволяет максимально эффективно использовать площадь машзала. Верхнюю часть объекта инженеры Facebook используют для управления подачей охлаждающего агента: холодный воздух поступает в серверную комнату сверху, что позволяет использовать эффект самотяги (естественная тенденция горячего воздуха подниматься вверх, холодного – опускаться вниз). Данная находка позволила избежать использования элементов для нагнетания холодного воздуха вверх через фальшпол.

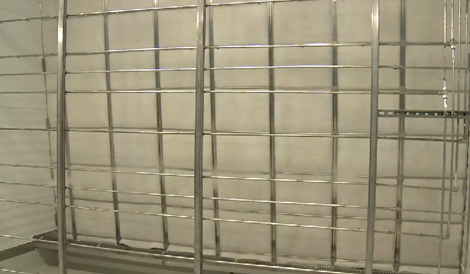

Жалюзи, которые контролируют приток воздуха внутрь объекта Facebook в Прайнвилле

Как уже упоминалось, в дата-центре установлены охлаждающие панели, с помощью которых снижется температура воздуха. Панели взаимодействуют с потоком воды, в результате чего проходит процесс испарительного охлаждения. В стенки воздуховода вмонтированы датчики влажности и температуры, которые снимают показания при поступлении воздуха в дата-центр. Система может в автоматическом режиме увеличивать или уменьшать уровень влажности и температурный режим.

«Вокруг меня сейчас воздух с температурой около 70 градусов по Фаренгейту (21.1 градус Цельсия), а его относительная влажность составляет около 30%», говорит Пратчетт, стоя в машзале дата-центра.

Доведенный до нужной кондиции воздух распространяется по “холодным” коридорам на этаже с машзалами и подается непосредственно к серверам. Регулирование параметров воздушного потока происходит с помощью системы Facebook Megafog.

Система Facebook Megafog: вода здесь используется для увеличения уровня влажности и изменения температуры воздуха

В дата-центре Facebook используются изолированные “горячие” и ”холодные” коридоры, расстояние между которыми составляет 14 футов (4.2 метра). Пратчетт заявил, что разница температур между этими двумя коридорами может доходить до 30 — 35 градусов.

«В достаточно холодный день воздух многократно проходит через систему, чтобы мы могли добиться оптимального температурного режима и сэкономить на фильтрации. Но зимой мы ничего не охлаждаем — мы подогреваем воздух», сказал Пратчетт.

Собственный массив солнечных батарей

Facebook запустила массив солнечных батарей рядом с этим дата-центром примерно два года назад. Решение о строительстве солнечной фермы были принято отчасти под давлением со стороны экологической группа Гринпис, активисты которой обвиняли соцсеть в использовании «грязного» электричества с угольных электростанций.На тот момент Facebook стала одной из первых компаний, решившихся на использование солнечных батарей для энергоснабжения ЦОД.

Солнечные батареи рядом с дата-центром

Мощность рассматриваемой гелиоэлектростанции составляет 0.1 МВт, при этом за год она может вырабатывать более 200 тысяч киловатт-часов электричества. Как отмечает Пратчетт, сгенерированная на солнечной ферме электроэнергия используется лишь для запитки офисных помещений. Нужно отметить, что в масштабах дата-центра 100 киловатт — очень незначительная величина.

Солнечные батареи оборудованы двухосными устройствами слежения за Солнцем, что позволяет ориентировать их оптимальным образом в течение всего дня. В создании гелиоэлектростанции приняли участие три компании из штата Орегон: PV Trackers (системы ориентации), SolarWorld (фотоэлектрические панели) и Sunlight Solar Energy (монтаж).

Facebook и Open Compute

Ближе к концу ролика Пратчетт рассказывает о преимуществах серверных стоек и серверов, созданных по стандарту Open Compute. Именно такое оборудование используется в машзалах дата-центра Facebook в Прайнвилле. «Наша инициатива помогает создавать наиболее энергоэффективные системы для дата-центров», подчеркивает Пратчетт.

Пратчетт рядом с серверной стойкой, созданной по стандарту Open Compute, и аккумуляторным блоком (синий шкаф слева)

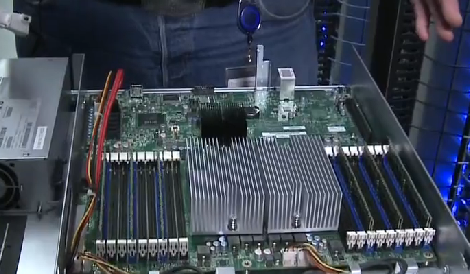

Инженер сказал, что в ЦОД Facebook используется источники бесперебойного питания (ИБП) на базе постоянного тока. Он также достал из стойки один сервера на базе стандарта Open Compute, чтобы продемонстрировать его простоту. Пратчетт говорит, что сервер на 38% эффективнее любой другой машины доступной на рынке, при этом стоит он на 24% меньше.

Напомним, что ин6ициатива Open Compute Project (OCP) стартовала в апреле 2011 года. С помощью OCP соцсеть собиралась поделиться со всеми заинтересованными сторонами особенностями дизайна своих серверов, систем электроснабжения, охлаждения и ИБП. Этот шаг рассматривается как долгожданный отход от секретности, которая на протяжении многих лет окружала этап проектирования центров обработки данных и их функционирование.

Разработчики Facebook используют крайне простые шасси, в которых нет деталей из пластика. Это способствует повешению равномерности движения воздуха внутри сервера, а также снижению его веса (за счет уменьшения количества деталей в корпусе). Примечательно, что нижняя стенка одного сервера служит верхней для находящегося под ним устройства. Специалисты Facebook используют материнские платы под процессоры AMD и Intel, которые производятся на заводах компании Quanta. Разработчики постарались убрать все элементы платы, без которых можно обойтись.

Сервер в дата-центре Facebook, созданный по стандарту Open Compute

Напомним также, что в начале года Facebook анонсировала новые спецификации Open Compute, потенциально расширяющие диапазон доступных в рамках проекта систем. В частности, разрабатывается универсальный процессорный слот, позволяющий устанавливать микропроцессоры разных чипмейкеров в одну и ту же материнскую плату. Специалисты Facebook убеждены, что нынешние конструкции серверов крайне негибкие. У партнеров вендоров первого эшелона (Dell или HP) ограниченный выбор комплектующих и часто отсутствует возможность замены компонентов.

Негаватт и ЦОД Facebook

В начале ролика Пратчетт отмечает, что во время работы в области повышения энергетической эффективности дата-центра при измерении мощности вместо привычных мегаватт использовалось понятие «негаватт» (это негативный, то есть сэкономленный ватт; термин обозначает неизрасходованную виртуальную единицу энергии, сэкономленную благодаря более разумному и эффективному потреблению). Чем выше мощность ЦОД в негаваттах, тем ниже углеродный след объекта.

Этот термин был введен в обиход в 1989 году. Его создал главный научный сотрудник Института Скалистых гор и авторитетный эксперт в области защиты окружающей среды Амори Ловинс. В настоящее время мощность того или иного объекта в негаваттах нельзя измерить с высокой точностью – этот показатель оценить можно лишь только теоретически. Тем не менее, уже идет работа над созданием рынка, на котором компании смогут торговать негаваттам (по аналогии с рынком квот на выбросы углекислого газа).

Два года назад Комиссия по регулированию энергетического рынка США (Federal Energy Regulatory Commission; FERC) утвердила правила расчета и выплаты компенсаций крупным клиентам поставщиков электроэнергии за внедрение механизмов реагирования на спрос, повышение энергоэффективности своего оборудования и другие шаги, позволяющие улучшить функционирование и конкурентоспособность организованного оптового рынка энергетических ресурсов. Иными словам, американские чиновники готовы платить за негаватты.

По словам экспертов, дальнейшее развитие нормативной базы в данной области вскоре приведет к тому, что негаватты, вырабатываемые за счет снижения использования электроэнергии, будут продаваться на вторичном рынке аналогично реальным мегаваттам, генерируемым с помощью традиционных электростанций.

Те не менее, на данном этапе концепция рынка, на котором будет осуществляться купля-продажа неиспользованных негаватт, имеет много недостатков. Речь идет среди прочего о сложностях, с которым сопряжена оценка энергоэффективности того или оного объекта. При этом подобные процедуры могут обернуться негативными последствиями для поставщиков электроэнергии и конечных потребителей товаров или услуг той или иной компании, так как периодическая оценка энергоэффективности может повлечь за собой удорожание продукции и т.д.

Видеоролик можно посмотреть здесь http://www.facebook.com/photo.php?v=10150385588936731