Постоянная шумиха вокруг коэффициента эффективности использования энергии в ЦОД (Power Usage Efficiency; PUE) сама по себе зачастую становится объектом критики, поскольку происходящее отвлекает внимание специалистов от сути данного показателя. Несколько лет назад, когда консорциум The Green Grid впервые представил показатель PUE, он был призван служить в качестве механизма для сравнения одного и того же центра обработки данных в разрезе достаточно длительного промежутка времени, а не применяться для проведения сравнений между различными ЦОД, как это происходит сейчас.

Постоянная шумиха вокруг коэффициента эффективности использования энергии в ЦОД (Power Usage Efficiency; PUE) сама по себе зачастую становится объектом критики, поскольку происходящее отвлекает внимание специалистов от сути данного показателя. Несколько лет назад, когда консорциум The Green Grid впервые представил показатель PUE, он был призван служить в качестве механизма для сравнения одного и того же центра обработки данных в разрезе достаточно длительного промежутка времени, а не применяться для проведения сравнений между различными ЦОД, как это происходит сейчас.

Недавно Google опубликовала результаты комплексного исследования своих ЦОД, в котором метрика PUE используется надлежащим образом. В частности, специалисты интернет-гиганта проводили измерения, запускали модели и оптимизировали механизмы охлаждения в разрезе нескольких своих «точек присутствия» (Point of Presence; POP). Эти POP представляют собой малые и средние дата-центры.

Для определения PUE нужно взять общее энергопотребление объекта и разделить его на энергопотребление IT-оборудования. Показатель превышает единицу, как правило, из-за жадных до электроэнергии систем охлаждения серверного оборудования. Освещение и другие подсистемы ЦОД также нельзя сбрасывать со счетов, если объект достаточно крупный, но значительная часть тематического исследования Google сосредоточена именно на максимизации эффективности охлаждения.

Инженеры Google в точности придерживались рекомендаций The Green Grid при измерении PUE, поэтому они разместили датчики буквально повсюду (работа по повышению энергоэффективности дата-центра не будет продвигаться вперед должным образом без интенсивного сбора данных). Помимо комплексного измерения температуры в машзалах специалисты Google хотели изучить, как потоки воздуха влияют на температуру в «холодных» и «горячих» коридорах.

После того как усовершенствованные измерительные системы заняли свои места, инженеры решили оценить работоспособность IT-оборудования при различных температурных режимах. Здравый смысл подсказывает, что машины должны работать при температуре от 15 до 21 градусов по Цельсию. Тем не менее, по данным Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigerating and Air Conditioning Engineers; ASHRAE), в «холодных» коридорах (воздуховоды, по которым воздух из системы кондиционирования попадает к серверным стойкам) должна поддерживаться температура около 27 градусов по Цельсию.

Кроме того, исследователи добавляют, что «большинство производителей IT-оборудования указывают в технических характеристиках своих машин, что те могут работать при температуре 32 ° C/90 ° F или даже выше, так что запас приличный».

Специалисты Google отметили, что применяемые в ЦОД кондиционеры (CRAC) также выступают в качестве осушителей воздуха, снижения относительной уровень влажности до 40 процентов, и способны подогревать воздух, если тот слишком холодный. Отказавшись от этих, казалось бы, ненужных (или по крайней мере неэффективных) процессов, можно сэкономить энергию. Так, при повышении температуры с 22 °C / 72 °F до 27 °С / 81 °F в одном помещении с сетевым оборудованием мощностью в 200 кВт компания смогла сэкономить десятки тысяч долларов в год на счетах за электроэнергию.

Когда Google начала этот проект, средний уровень PUE в «точках присутствия» компании был равен 2.4. Это было обусловлено главным образом тем, что системы охлаждения, применяемые в рассматриваемых ЦОД были, слишком избыточными. Они были разработаны для поддержания гораздо более интенсивных IT-нагрузок, чем те, что фактически наблюдались в дата-центрах.

«Несколько лет назад IT-нагрузка в машзале одного из наших ЦОД составляла всего лишь 85 кВт, при том что система охлаждения была разработана, чтобы поддерживать работоспособность компьютерного и сетевого оборудования мощностью в 250 кВт. После ввода объекта в эксплуатацию оптимизация воздушного потока не была проведена. При такой конфигурации в машзалах наблюдалось переохлаждение и недостаточное использование ресурсов», отмечают авторы исследования.

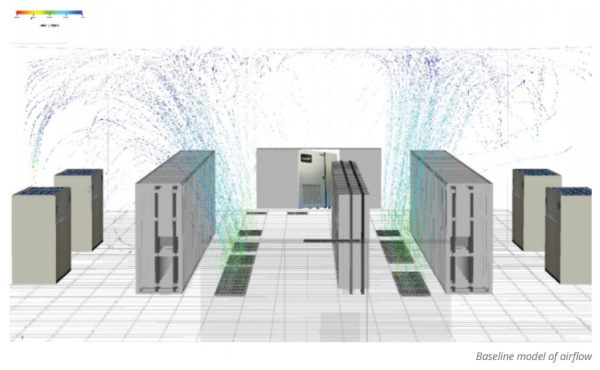

На приведенной ниже схеме демонстрируется изначальная неэффективность системы: холодный воздух перемещается через серверы прямо к отводным воздуховодам. При этом холодных воздух чрезмерно взаимодействует с окружающими серверные стойки воздушными массами. Специалисты отмечают, что в такой конфигурации серверы исправно охлаждаются, но не так быстро, как могли бы.

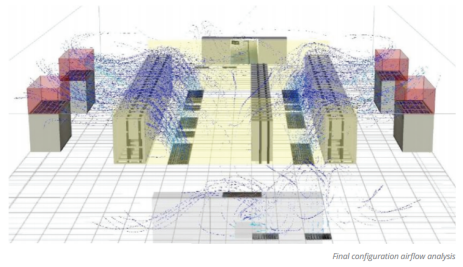

После того как с помощью датчиков было собрано значительное количество информации по температуре и воздушным потокам, инженеры интернет-гиганта применили численное моделирование (в частности, методы вычислительной гидродинамики), чтобы определить, как лучше всего направлять охлажденный воздух к серверам. Они решили использовать пластиковые барьеры, чтобы изолировать «холодные» коридоры. Вход в холодный коридор они закрыли специальными жалюзи из прозрачного пластика. Так холодный воздух из-под фальшпола может проходить исключительно через стойки с оборудованием, вместо того чтобы уходить через верх или через вход в коридор. Теперь инженеры могли регулировать и направлять поток воздуха. Результат можно увидеть ниже.

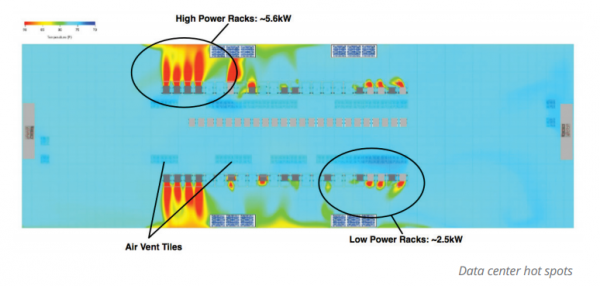

Эти изменения сопровождались вышеупомянутыми настройками терморегулирования, что позволило снизить средний коэффициент PUE с 2.4 до 2.0. Затем специалисты интернет-гиганта занялись поиском горячих точек, где следует оптимизировать температурный режим, чтобы повысить общую эффективность системы. После сбора информации, но перед внесением корректив, специалисты Google изучили приведенную ниже карту температур, которая показала аномальные уровни температуры вблизи отводных воздуховодов, что неудивительно.

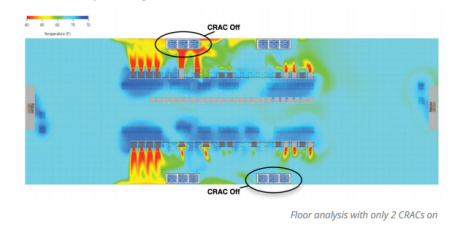

Решение, по словам представителей интернет-гиганта, оказалось довольно простым. Они установили 48-дюймовые рамки из листового металла вокруг отводных воздуховодов системы кондиционирования, что позволило добиться оптимизации воздушных потоков. Эта доработка также позволила специалистам Google выключить сразу два мощных и энергоемких кондиционера, как показано на рисунке ниже.

После внесения корректировок, а также внедрения механизма автоматического выключения освещения, когда в здание никого нет, коэффициент PUE упал до 1.7.

«Оптимизация помогла нам сократить количество кондиционеров с 4 до 2 при сохранении желаемого температурного режима в машзале. Если сравнить результаты анализа нашего машзала после оптимизации с данными на момент первоначального исследования объекта, можно заметить, что температура в «холодном» коридоре стала ниже, а в «горячем» – осталась примерно на том же уровне. И это при использовании всего лишь половины кондиционеров», отмечают исследователи.

Коэффициент PUE на уровне 1.7 не особенно впечатляет. Особенно учитывая, что многие операторы новых дата-центров хвастают уровнем в 1.1, а иногда и ниже. Однако, вспомнив, что показатель PUE изначально был призван служить в качестве механизма для сравнения одного и того же ЦОД в разрезе достаточно длительного промежутка времени, нужно отметить, что специалисты Google превосходно справились со своей задачей. Объем инвестиций в эти доработки в среднем на один машзал составил $ 25 000. Затраты на электроэнергию снизились на $ 67 000 в год.