ЦОД в Ярославле: воплощение мечты последних пяти лет

«Билайну» нужно очень много вычислительной мощности для работы. Идея построить большой ЦОД и решить проблемы роста на 10 лет вперед витала с 2005 года. Я вкратце расскажу о том, с какими сложностями мы столкнулись, когда раздумывали о новом крупном объекте.

Сильнее, выше, быстрее, дешевле

Первая проблема была в соотношении результатов и цен. Понятно, что строить ЦОД в Москве около уже имеющегося хочется, но не настолько сильно, чтобы тратить реально крупные суммы на строительство, и энергообеспечение. Поначалу мы отсмотрели около 30 объектов в Москве и области, но потом пришли к выводу, что экономически более обосновано строить где-то поблизости от столичного региона, но не непосредственно в нём. Тут есть ещё сложность: между ЦОД в Москве и новым ЦОД не должно быть больше 200 километров оптоволокна, иначе скорость света уже существенно скажется на лагах при синхронной репликации. Параллельно мы купили новые модели дисковых массивов и получили возможность протестировать асинхронную репликацию. Так стало понятно, что географически разносить центры можно.

Выбираем место

Основной показатель любого ЦОД – это количество электроэнергии, которое он потребляет. Мы посчитали темпы роста за последние 10 лет, аппроксимировали этот рост, скорректировали его после кризиса 2008-го и выяснили, что нужно 10Мвт для решения вопроса на ближайшее будущее. Учитывая, что подключать мощность кусками не выгодно, требовалось сразу подвести именно такую линию к центру.

Следующий фактор выбора – температура региона и его влажность. Чем холоднее место в среднем – тем меньше нужно энергии на принудительное охлаждение, и тем экологичнее и экономичнее работа ЦОД. С влажностью ситуация такая: если воздух сухой, на платах начинают скапливаться статические разряды, а если слишком влажный, «выпадает роса». Оптимальным местом по результатам оценки стал Ярославль, который близок к Москве, технически-обеспечен, где можно взять много электроэнергии, есть дешевая земля и где подходящий температурный режим (90-95% времени мы не используем активное охлаждение, то есть работаем с внешним воздухом).

Оцениваем стоимость конструкции

ЦОД сразу решили делать модульным. После конкурса среди 15 крупных компаний было выбрано решение на базе AST (Smart Shelter). Основной элемент конструкции – огнестойкие самонесущие панели, которые соединяются «ласточкиным хвостом» и закрываются профилями, защищающими как от температурных воздействий, так и от попыток несанкционированного проникновения. Конструкция модульного ЦОД представляет собой шесть автономных модулей, полезной площадью каждого 500 квадратных метров.

Модуль. Снаружи в реальности выглядит как большая серая коробка.

В самом ЦОД используется множество разных систем, которые позволят пережить любые бедствия: защита от повреждения водой и огнём, температурная защита, физическая защита, защита от самой жестокой непогоды, внутренних пожаров, проникновения, дурака, ЭМ-полей и так далее. Каждый модуль имеет свою децентрализованную инженерную инфраструктуру. При необходимости отдельные модули могут быть демонтированы и оперативно перевезены на новое место. Если в один из модулей попадает метеорит, это не сказывается на работе других модулей.

Модуль внутри, снято не в новом дата-центре.

Подбираем начинку

Учитывая, что для самого центра можно было использовать любые решения, благо ограничений не было, мы сосредоточились на том, что позволит обеспечить минимальное потребление ресурсов, то есть будет выгодным и экологичным. Вообще, быть экологичным современному дата-центру выгодно: это совпадает с основной парадигмой сокращения потребляемого питания и оптимального расходования ресурсов. По отчётам консалтинговых компаний, получалось около 40 различных решений для построения систем охлаждения и поддержания бесперебойного питания. Мы сразу отмели технологи не относящиеся к инженерным системам ЦОДа связанные с водяным охлаждением серверов, управлением питанием и охлаждением серверов на уровне ПО или BIOS, поскольку этим можно заниматься параллельно с принятием решений по выбору технологий. Экзотические системы охлаждения — такие как охлажденные балки, глубоководное охлаждение и другие, а также экзотические системы первичной или вторичной систем электропитания – ультраконденсаторы, геотермальные источники, солнечные батареи, приливно-отливные системы питания, ветряные мельницы тоже быстро «отвалились». Остальные системы при прямом анализе не вызвали отторжения и были подвергнуты дополнительному исследованию.

Первичный отбор

Сначала думали про колесо Киота. Однако учитывая требования Tier-3, нужно было делать ещё два таких же резервных узла, что потребовало бы очень много пространства. С интересом смотрели на интегрированные в сервера ИБП – данная технология выглядела многообещающей, поскольку не требовала централизованного ИБП. С другой стороны, разного железа много (дисковые массивы, ленточные библиотеки, сервера типа high-end), а унифицировать его быстро не выйдет, поэтому пришлось отказаться. Данная технология может применяться только в гомогенной среде с точки зрения серверов и накладывает большие ограничения на архитектуру ЦОДа в целом. Нашей задачей было строительство универсального дата-центра, где будет уживаться разношерстное оборудование, которое производилось 10 лет назад, производится сейчас и будет в следующие 10 лет. Потом мы стали смотреть на термальное хранилище – но тут был необходим большой объем, для 10 Мвт просто астрономический. Тригенерация на турбинах или топливных ячейках с использованием адсорбционных или абсорбционных систем хорошо смотрелась, пока мы не посчитали кейс на сравнении стоимости владения систем тригенерации и ДДИБП с модулями ЦОД и freecoling. У нас получилось что бизнес кейс становится положительным после 30 лет использования. Высокоэффективные статические UPS – такие системы уже используем, хорошо представляем себе сколько стоит внедрение подобного решения, а значит можем сравнить с новыми решениями.

Питание

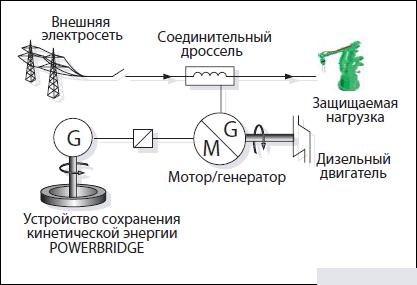

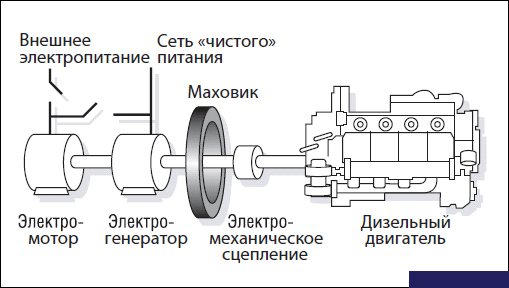

Самой интересной технологией с точки зрения экономической обоснованности оказалось ДДИБП — дизель-динамический источник бесперебойного питания. Его основной принцип в том, что он накапливает кинетическую, а не химическую энергию, как обычные системы ИБП на батареях.

Он работает по тому же примерно принципу, что и классические системы бесперебойного питания – при кратковременных сбоях или некачественном питании (неправильная синусоида переменного напряжения, колебания частоты, амплитуды и т.д.) используется накопленная кинетическая энергия, при долговременных пропаданиях электроэнергии включается дизель-генератор. Благодаря «волчку» переключение питания происходит очень быстро и незаметно для потребителей, то есть без прыжков напряжения, например.

Охлаждение

Для охлаждения была выбрана система естественного охлаждения окружающим воздухом “Natural Free Cooling” — это кондиционирование воздуха внутреннего пространства МЦОД основанная на принципе теплообмена между наружным воздухом и воздухом, циркулирующим в МЦОД, при этом обеспечивающая чистоту воздуха и контроль влажности. Система представляет собой два разомкнутых отдельных контура. Во внутреннем контуре циркулирует воздух ЦОД, в наружный контур подается внешний воздух. Основным элементом системы является рекуперативный теплообменник, в котором происходит теплообмен между наружным воздухом окружающей среды и воздухом в помещении МЦОД. Нагретый воздух удаляется из горячих зон вытяжными воздуховодами, охлажденный воздух подается в холодные коридоры. Использование адиабатического охлаждения (впыск воды в поток воздуха внешнего контура) позволяет увеличить диапазон температур работы системы охлаждения без подключения компрессорного контура холодоснабжения от +19 до +24 градусов Цельсия.

Территория. Деревья посажены так, чтобы не мешать ветру и охране.

Интересно, что при расчёте используемых технологий оказалось, что итоговая стоимость владения bleeding edge-технологическими решениями оказалась ниже при меньших сроках внедрения.

Основной параметр оценки эффективности ЦОД в этом плане — Power Usage Effectiveness, его физический смысл – это соотношение всей энергии потребляемой ЦОД к количеству энергии, потребляемой полезной нагрузкой. По нашим расчетам среднегодичный показатель PUE не будет превышать 1,3.

Если темы интересны, можно сделать отдельный топик о системах охлаждения и бесперебойного питания ЦОД, плюс отдельно рассказать о том, как мы синхронизируем данные и защищаемся от различных сбоев. В комментариях можно задавать вопросы вообще на любую тему: либо отвечу сразу, либо пообещаю ещё топик.

Источник: habrahabr.ru

так это пока только проект ?

к 2013 планируют запуститься

Давайте топик.

Интересно!

Расскажите по подробнее про ситему охлаждения, которую вы выбрали — очень интересно.

Переключение происходит быстро не благодаря «волчку», кхм.., а благодаря тому, что дизель включается без нагрузки, которая передается на дизель постепенно, пока induction coupling передает накопленную энергию на генератор.

Как только не обзывают free cooling, теперь natural… Должен предупредить, что согласно натурным (!) исследованиям, как бы хорошо не фильтровался наружный воздух, вплоть до EU9 (выше HEPA — но это неэффективно из-за больших потерь давления), но подобное решение сокращает срок службы серверов до 2 лет. Это маловато, как бы быстро не устаревали морально серверы. Не всегда, конечно, срок службы составит 2 года, зависит от того, насколько изначально чист воздух, но ясно одно — с экологией в городах РФ крайне плохо. Из Европы приезжаешь — так просто задыхаешься.

а мне интересно ,из каких соображений была выбрана именно такая форма здания для ДЦ ?

АК, бывает, что архитектор превалирует над главным инженером, или инвестора интересует, по большей части, только внешний вид здания. Есть и такое, и не дай бог Вам участвовать в проекте с таким подходом. Есть, в конце концов, и объективные причины, если дело касается городского skyline (прошу прощения, не знаю, как это по-русски сказать). Форма неоптимальна, но важно лишь то, каковы причины этого.

Да форма видимо продиктована видом сверху. Проект надо было тащить через инвесткомитет, значит нужна фишка. МТС будет строить форме яйца, ну и смотрим дальше логотипы )))

grey72, да я в курсе ,участвовал в паре проектов где дизайнеры побеждали инженерную мысль ) Мне интересно как раз в чем фишка этого конкретного проекта ..

АК, с фишками тяжеловато, на то есть объективные причины: кто будет обслуживать? Инженеры из страны бегут или на пенсии выходят. А с запада кто же поедет? Лично я не поеду, думаю, и многие тоже предпочтут оставаться в «загибающейся от кризиса» Европе.

Поэтому объективно — «фишки» — зло для подобных проектов. Это мы тут извращаемся с горными реками и кисельными берегами ради киловаттов 🙂 А у вас энергии много, и это — второй фактор, который обуславливает применение «простых» технологий.

К тому же, у России есть традиционная проблема — не перенимается опыт других стран. То ли это языковая проблема, то ли менталитет, но факт налицо. Сейчас появились проекты, правда, пока небольшие, с использованием Kyoto. Технология действительно экономичная, но есть «но». Настолько значимое, что, как видите, Kyoto не продвинулось у нас далее пилотных проектов, несмотря ни на какие экономические показатели. А фактор — значительное снижение времени жизни серверов, воздух грязен. Сколько копий сломано было, но теперь про это — молчок, осознали. А Россия продолжает внедрять эти проекты. Аналитику и исследования никто не читает, или не хочет принимать очевидных выводов, сделанных по результатам этих исследований. «Мы пойдем своим путем».

grey72,Киото,имхо ,хорошо применять при строительстве «с нуля».Когда оптимально все можно спроектировать.. А много таких проектов тут ? 😉

АК, лучше вовсе не применять. А, да, начать с чистого поля — это почему-то в России не практикуется. Любой сарай считается лучше, нежели чистое поле. Реконструкция сарая представляет собой дело дорогостоящее, для проекта неоптимальное, но это не берется в расчет. Правда, несколько проектов все же есть с нуля.

Возможно будет интересно: разработана новая система охлаждения центров базы данных (компьютерных залов, серверов).

Эту систему придумали и запатентовали англичане.

В кратце суть состоит в том, что в настоящее время сервера охлаждают воздухом помещения, в котором они стоят.

Предлагается охлаждать непосредственно сам сервер.

Причем если в настоящее время циркуляция воздуха происходит снизу вверх, а именно:

снизу заходит холодный воздух, поднимаясь вверх, он охлаждает внутренние платы снизу вверх, причем нижние платы охлаждаются лучше верхних и на верхних слоях часто происходит перегрев (так как воздух пока поднимется — нагреется).

Затем нагретый воздух выбрасывается в помещение, в котором стоит сервер — в серверной постоянно высокие темперетуры.

Кроме того, в настоящее время размещение плат в сервере требует между ними свободного пространства для возможности лучшей циркуляции этого воздуха.

В прелагаемой системе циркуляция воздуха происходит горизонтально:

в сервер через переднюю стенку входит поток воздуха, проходя через каждую плату одновременно (при этом все платы охлаждаются одинаково — что вверху, что внизу, что в середине), нагретый воздух проходя через специальную дверь, установленную на задней стенке, охлаждается и уже холодным выбрасывается в помещение.

Таким образом, в помещении всегда поддерживается заданная температура +18 С / +20 С, при этом отпадает необходимость в использовании прецизионных кондиционеров и фальш-пола.

Кроме того свободное пространство сервера можно заполнить дополнительными платами, что позволяет сэкономит до 45% пространства.

Но основной плюс данной системы — это значительная экономия электроэнергии, иногда до 95% в холодное время года.

Если будут вопросы — обращайтесь.

Да потому что к сараю уже подведены МВт ,как правило.Ну или не подведены,но числятся за сараем.Не надо откатывать монополистам за электричество ))

Откатывать, по моему опыту, нужно всё равно. Тем не менее, снести сарай и построить, что нужно, тоже не практикуется. Т.к. это не реконструкция, а новое строительство, т.е. опять откати. Вобщем, у вас там основной и единственный бизнес-процесс — откатить.

to grey. Слегка не понял как к Киото привязан грязный воздух? Два контура: один с внешним, другой с внутренним. и через рекуператор теплообмен. Или какая-то другая модель экономайзеров имеется ввиду?

Я имею ввиду решения без рекуператора, которые еще более эффективны. С рекуператором много работающих решений у KPN в Нидерландах. Но это не новость: фактически, лет 15 американцы используют приточки с рекуператором для ДЦ, ничего нового в этом решении нет, за исключением того, что вариант Kyoto базируется не на сборной приточке, а на отдельном колесе. А по сути — это старое решение. О нем речи не идет.

Тогда если соблюсти классификацию это что-то типа Roof-Top с подмешиванием внешнего воздуха?

Skip, Roof-top это всего лишь приточка в исполнении для установки на кровлю. По сути — именно приточка. Любая приточка может быть скомпонована из отдельных агрегатов (вентиляторов, рекуператоров разного типа, фильтров, и т.п.). И только приточки (AHU — air handling unit) небольшой производительности бывают packaged, т.е. с фиксированной начинкой. Но суть в том, что приточка работает с использованием внешнего воздуха, это верно всегда, за исключением тех моментов, когда имеющийся в ее составе рекуператор полностью возвращает отработанный воздух в сеть. Kyoto построен на именно таком принципе, как если бы в приточке рекуператор возвращал в сеть 100% воздуха. При этом особой эффективности не наблюдается, т.е. эффективность та же, что и у приточки в режиме полной рекуперации. Если рекуперация отсутствует, или частичная, то эффективность растет, вот только грязный воздух портит серверы. По сути, в идее Kyoto нет ничего нового, ВООБЩЕ. Это просто приточка. И эффективность, соответственно, приточки мы и получим на практике.

Да, и в континентальных климатах рекуператор в холодный период года практически всегда должен быть включен. Но вопрос: а как же охладить воздух в сети, если рекуперация составляет 100%? Подмешать внешний воздух, больше никак. Если подмешивать непосредственно, то получим грязный воздух. Если опосредованно — получим низкую эффективность. Так что при континентальном климате идея и вовсе теряет смысл. Мне возразят, что на практике это не так. Да, в том случае, если тепловая нагрузка невелика. А при номинальной нагрузке картина изменится именно, как я описал.

Кмк, с достаточно большой вероятностью указанная в статье технология охлаждения — это EcoBreeze от Schnerder Electric.

http://habrahabr.ru/company/apc/blog/131246/

http://www.apc.com/site/press_center/index.cfm/apc-by-schneider-electric-announces-ecobreezee284a2-the-first-air-economizer-cooling-solution-that-keeps-outside-air-out-of-the-data-center/