Фотоэкскурсия в ЦОД Нагорная, Электронная Москва

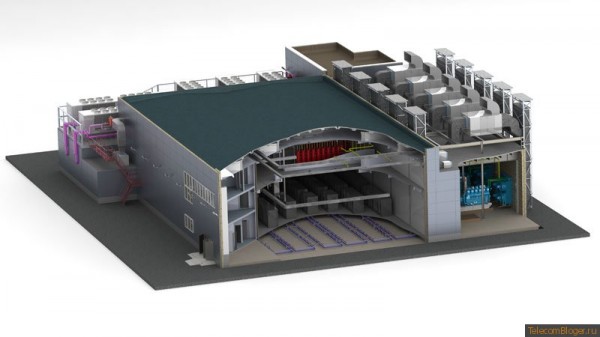

Предлагаем Вашему вниманию обзорную фотоэкскурсию по новому высоконадежному центру обработки данных компании «Электронная Москва» — ЦОД «Нагорная», стандарта надежности Tier III — основных систем и Tier IV — системы энергоснабжения.

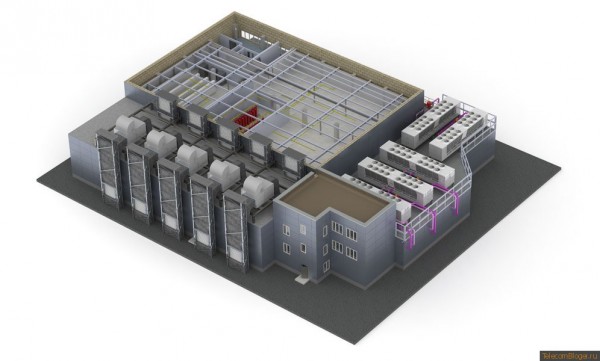

Площадь ЦОД «Нагорная» — 2200 кв. м, полезная мощность 6800 кВт, 244 стойки основного машзала мощностью 15 кВт, 40 стоек ядра ЦОД, 40 стоек зала нестандартного оборудования, 120 стоек резервного зала.

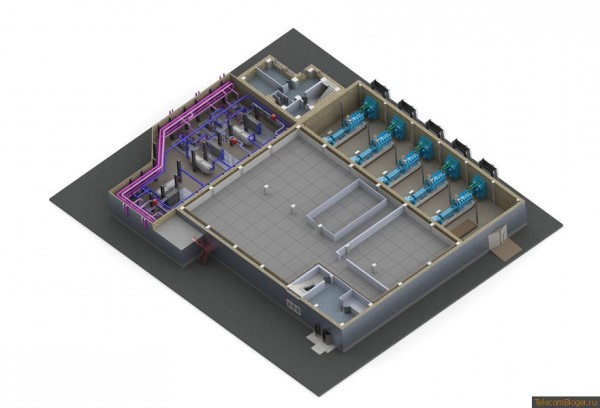

В ЦОД используется система бесперебойного, гарантированного электроснабжения на базе дизельных роторных источников бесперебойного питания производства Hitec Power Protection, имеющая уровень резервирования 2N +1.

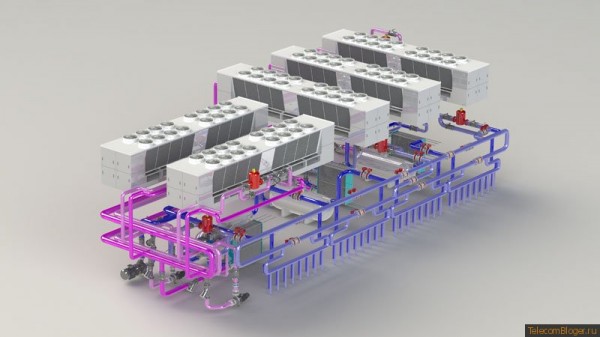

В ЦОД установлена современная и наиболее высокотехнологичная система кондиционирования машинных залов. Сердцем данной системы является хладоцентр, состоящий из 5-ти чиллерных машин Emerson хладопроизводительностью 1100 кВт каждая, объединенных в сложную систему промежуточных теплообменников, расширительных баков и мощных насосных станций.

Системы хладоцентра построены таким образом, что технология FreeCooling позволяет экономить значительное количество электроэнергии, за счет использования холодного наружного воздуха для охлаждения.

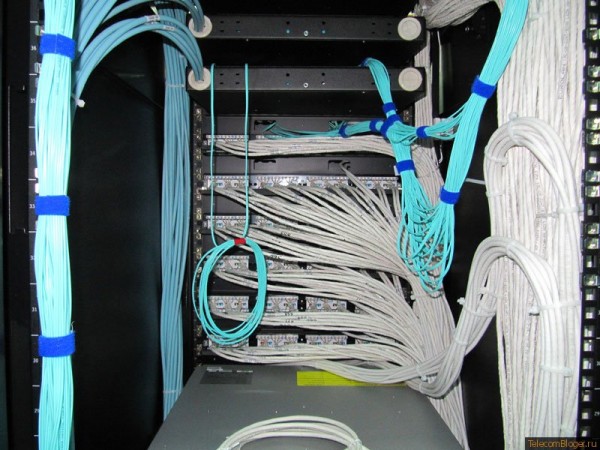

Структурированния кабельная система выполнена согласно всем международным стандартам и позволяет осуществлять коммутацию на скоростях до 40 Гб/с.

Собственные оптические кабельные линии до своих узлов связи на крупнейших точках обмена траффиком, таких как ММТС-9, что обеспечивает достаточную пропускную способность каналов связи и возможность оперативного межсетевого подключения, практически с любым оператором. Сетевое ядро ЦОД построено с учетом возрастающей нагрузки, имеет 100% резерв.

Система газового пожаротушения использует безопасный для людей, оборудования и окружающей среды газ Novec.

Мониторинг и диспетчеризация позволяют удаленно управлять всеми ключевыми узлами инженерных систем, что значительно сокращает время реагирования на аварийные ситуации и обеспечивает координирование всего ЦОД. Квалифицированный персонал круглосуточно осуществляет техническую поддержку, управление и мониторинг оборудования.

«и Tier IV — системы энергоснабжения.»

с друпсами в одном машзале и их нечетном количестве, намекающем на отсутствие 2N, сумнительно как-то.

Жаль что кроме черных-черных шкафов в белом-белом зале других фото нет. А 3D модельки приятные.

Насчет полезной мощности что-то не так. Имелась ввиду общая? Неясно, где стоит электрораспределительное оборудование. Сеператоры поставить за насосами — это надо быть весьма далеким от проектирования человеком. Сетчатый лоток в машзалах недопустим согласно TIA-942. Все генераторы в одном помещении — туда же. Выходит, очередная отсебятина с претензией на супернадежность. ДЦ убивается одной небольшой аварией.

to gh72: Вы под сепараторами коллекторы понимаете?

Skip, нет, я про air/dirt separators, те, что стоят на линии. Их нельзя ставить ПОСЛЕ насосов. Вернее, поставить-то можно, но толку от них не будет. Впрочем, если использовать станцию поддержания давления — а ее необходимо использовать, то проще взять такую, которая будет иметь сепаратор в своем составе. Тогда нужда в громоздких сепараторах на линии исчезнет. Да и большие не производит никто — именно по этой причине. Кроме того, сепараторы ограничивают скорость потока, ну, или теряют эффективность вовсе при скоростях более 2 м/с. Так что их применение — как это выглядит на схеме, говорит о слабой компетенции проектировщика.

Кроме того видно, что используется только одна труба. Это выдают обходные линии сепараторов. Так что ни о каком Tier-3 не может быть и речи.

2greyhound72

>>Сетчатый лоток в машзалах недопустим согласно TIA-942.

Если можно уточните пожалуйста пункт.

Алексей, собственно, тут ничего и не уточнишь: In aisles and other common spaces in internet date centers, co-location facilities, and other

shared tenant data centers, overhead cable trays should have solid bottoms or be placed at least

2.7 m (9 ft) above the finished floor to limit accessibility or be protected through alternate means

from accidental and/or intentional damage.

Это 7.6.1 из TIA-942. solid bottoms или выше 2.7 метра. Здесь на фото мы видим, что bottom — сетка, и всё это явно ниже 2.7м, если только у них шкафы не 56 юнитов высотой 🙂 Но видно, что они 42 юнита, самые стандартные.

А 2N+1 по электроснабжению сразу наталкивает на мысль об освоении бюджета… Ну, да ладно. А вот по тексту надо пройтись техническим редактированием, ибо что-такое чиллерные машины, да еще и объединенные в сложную систему промежуточных теплообменников, расширительных баков и мощных насосных станций, я, увы, не знаю 🙂

Мониторинг и диспетчеризация — тоже ничем управлять не могут, увы. Помогают только следить за состоянием и оповещать. Нет газа Novec, есть Novec 1230… 15кВт на 244 стойки это никак не 6800кВт ПОЛЕЗНОЙ мощности, а только 3660. А PUE при этом будет 1.85, что вообще прошлый век и говорит только о неэффективности системы холодоснабжения, которая является главным потребителем «неполезной» нагрузки. Ладно, кто-то старался, а я тут в пух и прах разношу… С другой стороны, не стоит писать про «наиболее высокотехнологичную систему кондиционирования машинных залов», ибо при PUE 1.85 и московском климате это заурядная (если не выразиться жестче) система. Все, хватит критики. Нормальный для России ДЦ, только небось стоил как ДнепроГЭС…

Да, дополню, чтобы избежать споров: написано также и про другие стойки, кроме 15-киловаттных. Но 3660 — тем не менее — это верная цифра. Ибо: на схеме — машины Hitec по 2MVA. Система 2N+1, т.е. имеем 4MVA. Искомые 3660кВт или примерно так. Сути эти копейки не меняют.

И еще 🙂 Я вообще не понимаю, что за мощность 6800кВт, когда DRUPSы выдают 4МВА в совокупности? Или они работают только на стойки? Бред — ибо что — чиллеры защищены при этом отдельными ДГУ при том, что есть Hitec.. Ерунда какая-то. Либо здесь ошибки (в цифрах, в картинках), либо этот проект рисовали под кайфом

И еще-еще! Я склоняюсь ко второму предположению (о том, что проектировали под кайфом), ибо мощность пяти чиллеров будет 5500кВт (по холоду), при системе N+1 это 4400кВт, потери 10% на контуре, получаем те самые мои 4000кВт на стойках. И DRUPSы тоже 4! Только на стойки их и хватит! И? Получается, что чиллеры либо незащищены, либо на своих отдельных ДГУ?? Отсюда вывод о проектировании…

2 greyhound72

Вы очень много сделали неверных выводов, начиная от первого и заканчивая последним постом.

Все ваши замечания это лишь плод вашей же фантазии. Можно было бы конечно же ответить на все ваши вопросы «по пунктам», но как то грустно это будет выглядеть. А вообще критиковать можно до бесконечности, опять таки и дырки в полу не того сечения и суп не в чайнике…

2 greyhound72

И еще-еще! Я склоняюсь ко второму предположению (о том, что проектировали под кайфом), ибо мощность пяти чиллеров будет 5500кВт (по холоду), при системе N+1 это 4400кВт, потери 10% на контуре, получаем те самые мои 4000кВт на стойках. И DRUPSы тоже 4! Только на стойки их и хватит! И? Получается, что чиллеры либо незащищены, либо на своих отдельных ДГУ?? Отсюда вывод о проектировании…

А вот у меня вывод о ваших выводах…что вы просто теоретик и не более того.

Любому, даже малоопытному человеку в этой индустрии понятно, что есть крайне удобные связки «чилер-DRUPS», сложнейшая система автоматики позволяет «играть» с этими связками как угодно.

Да этот проект — это уход от стандартных стереотипов.

относительно полезной нагрузки:

244 х 15 кВт = 3660 кВт;

40 х 15 кВт = 600 кВт (зона нестандартного оборудования);

40 х 5 кВт = 200 кВт (сетевое ядро ЦОД+кросс);

5 х 5 кВт = 25 кВт (операторская);

5 х 5 кВт = 25 кВт (собст. нужны);

Сумма: 4510 кВт

Посчитаем PUE? У меня получилось 1,507…

к сожалению у меня не хватает ума рассчитать PUE с учетом FreeCooling, который если мне не изменяет память работает в наших широтах минимум 6 месяцев в году…

Остальное уже все мелочи и считать их ну совсем глупо.

А! Да и насчет освоения бюджета…

Считаю совершенно глупым ваше высказывание ибо вы даже стоимость проекта не знаете и не представляете, а если попросить Вас сделать бюджетную оценку, то уверен, что ваша цифра будет приближаться к масштабу Сбера…:)

От себя скажу, что за такие деньги и сроки в этой стране не строит никто, заявляю авторитетно, как человек работающий на топ позициях в этой индустрии начиная с 2007 года 🙂

мимо проходил: Понимаете, здесь не блог желтой газетки, поэтому, когда Вы что-то утверждаете, необходимо это подтвердить доказательно. Если Вы этого не делаете, то и не стоит писать

greyhound72

Золотые слова!

Осталось дело за малым…взять эти «золотые слова» Вам на вооружение 🙂

Есть вопросы? Звоните, с удовольствием отвечу на них.

Кроме того, я вижу, Вы знаете дополнительные цифры, к тому же высказываетесь обиженно. Не Вы ли проектировали? Даже если у вас получается 1.5 PUE, то это очень много. Что значит поиграться со связкой чиллер-DRUPS мне непонятно, как инженеру. Ну, и, в конце концов, меня не нужно просить составить бюджет, тем более, что Вы априори уверены в том, что у меня получится 🙂 А не нужно потому, что я не знаю сколько и что стоит в Вашей стране: я живу и работаю в Евросоюзе, здесь оборудование (по моему мнению) стоит значительно дешевле, в то время как работы — значительно дороже.

Если хотите продолжить разговор, то давайте обойдемся без утверждений относительно друг друга (мне менталитет не позволяет смешивать обсуждение технических аспектов наряду с выводами о человеке, которого я не знаю), и перейдем к делу. Если готовы, то у меня первый вопрос: если полезная нагрузка 4МВА (не будем окопейках), DRUPS в конфиг. 2N+1 (5 штук, видно по схеме, что каждый 2МВА) выдают 4МВА. Выходит верно — для полезной нагрузки. И вот вопрос — а чиллеры -то при этом КАК защищены, где мощность для них? Выходит, они не на DRUPS? Чудес-то не бывает, что еще за «поиграться связками»? Объясните, как это бывает, держать 4 МВА нагрузки плюс чиллеры (которые 4 штуки жрать будут не немее 1МВА при их мощности по холоду)? Откуда мощность-то? Я в чудеса не верю — исключительно в физику. А второй вопрос — зачем вам 2N+1 на электрику, если у вас по холоду N+1? У вас может произойти так, что холод накроется, а электричество будет. Что с серверами произойдет? Вы, конечно, можете отследить такую ситуацию, но вопрос в целесообразности… Ответьте, и посмотрим, кто из нас окажется прав.

Да, что касается стоимости: «квадратный метр фальшпола» будет стоить от 12000 до 18000 ЕВРО, если это честный Tier-3. Это в Евросоюзе. Вот вам и весь бюджет…

Насчет сроков в России я в курсе 🙂 Встречалось, когда при строительстве больших объектов даже не было планов работ. Я ДЦ тоже проектирую с 1998 года (бывает и такое 🙂 ), но, к счастью, не в России, иначе нервов бы не хватило.

А по поводу фрикулинга я позволю себе дать Вам совет: поднимите температуру воды в контуре до 20/25, и будет Вам фрикулинг не 6 месяцев в году, а все 10. Расчеты есть, но здесь не выложу, только лично.

Нужно будет следить за ресурсом компрессоров — не любят они таких температур. И сходу почти все производители могут отказать. Но не все 🙂

2greyhound72

>>>Да, что касается стоимости: «квадратный метр фальшпола» будет стоить от 12000 до 18000 ЕВРО, если это честный Tier-3. Это в Евросоюзе. Вот вам и весь бюджет…

А есть ли у Вас примеры честного TIER III построенного за такие деньги?

Ок, я отвечу по порядку:

1. Да, я знаю цифры;

2. Конечно же я не проектировал, я не проектировщик. В данном проекте я являюсь одновременно в разных пропорциях: РП, ГИП, идеолог, финансист и еще по мелочи.

3. Конечно много 1,5…с фрикулингом будет интереснее, но самые тру цифры будут только через год эксплуатации, причем при 100% загрузке. Так что предлагаю сей вопросы пока отложить. А потом вы же понимаете, что можно сидеть в кабинете и расчитывать на калькуляторе до потери пульса и потом когда все заработает понять, что и половина прогнозов не сбылась, только потому, что нагрузка на CPU идет не так, как планировалось изначально…

4. относительно бюджета все понятно. Стало быть прошу вас забрать свои слова обратно относительно стоимости строительства.

Да у нас стоимость любой железки как минимум равна ее стоимости в EU+НДС18%+таможня (5-35%)+прибыль поставщика/дистрибьютора+логистика;

Относительно того, что инженер не знает что, сколько стоит…имхо не правильно, ибо инженер помимо правильности выбранного тенического решения должен руководствоваться и стоимостной адекватностью. Лично мне не нужен чилер с КПД 99% при его стоимости «как чугунный мост» и сроком окупаемости 10 лет 🙂

5. К делу:

Имеет место быть ошибка в исходных данных (в статье). Указана схема резервирования 2N+1 — это некорректно.

У нас связка N+1. Связка трансформатор-DRUPS-чилер, резервирование реализовано не на уровне какой то железки, а на уровне всей связки. Мощность каждого DRUPSa — 2,2 кВА. Мы не резервируем отдельно DRUPS или чилер, резервируем сегмент системы целиком. Учитывая, что все сегменты (связки) имеют перекрестные байпасы между собой, мы имеем более отказоустойчивую схему резервирования и можем смело говорить о уровне резервирования Tier4.

На DRUPS-ах «висит» все жизненноважное оборудование ЦОДа. Кстати именно использование DRUPS-ов в нашей схеме позволяет сделать экономически целесообразное решение по бесперебойному питанию.

Евгений, есть примеры. Но есть и сложность 🙂 Дело в том, что мало, кто ориентируется в Европе на TIA-942, его вообще очень любят в России, настолько, что забывают о целесообразности. Но «плюс-минус» уровень надежности соответствует. Текущий мой проект дает около 20000 евро, но лишь за счет того, что строится первая фаза. После второй стоимость упадет до 17000.

мимо проходил:

ну, вот эта ошибка в статье и привела к тому выводу (одному из двух), что что-то неверно. Так что мои выводы верны, не кипятитесь 🙂 Относительно сбываемости прогнозов, может, это и допустимо в России, но здесь — нет. Вам за такие прогнозы придется такую кучу денег отвалить, что можно сразу оформлять банкротство. Какая у вас температура воды в контурах?

То, что DRUPS дает экономически целесообразное решение — вопросов нет 🙂 Да и как вы сделаете ДЦ на десяток мегаватт иначе? Можно, конечно, ставить КЭТы на 10-26 киловольтах, но это дорого и это — Штаты.

Никогда не считал стоимость ЦОД по квадратным метрам. У меня «мерило» простое — кол-во стоек и сколько кВТ на каждой. В EU и USA привыкли мерить ЦОД метрами, с одной стороны это правильно, но только с одной.

Я видел кучу ЦОДов с площадями 10-20к м2, при этом там стоят стойки по 5 кВт и как следствие плотность размещения крайне низкая, я же считаю это в нашем случае не целесообразным. Т.к. специфика бизнеса — это cloud…

2мимо проходил

Мы не резервируем отдельно DRUPS или чилер, резервируем сегмент системы целиком. Учитывая, что все сегменты (связки) имеют перекрестные байпасы между собой, мы имеем более отказоустойчивую схему резервирования и можем смело говорить о уровне резервирования Tier4.

А как реализована синхронизация DRUPS между собой ?

Да никто и не кипятится, специфика мой работы вообще не позволяет кипятится…

Относительно температур контуров:

Внутренний (вода) +12 — +18

Внешний (раствор гликоля) +10 — +16

Фотографии (именно фотографии, не картинки) из другого нашего ЦОД, маркетологи напутали. На них не стоит обращать внимание.

В нашем новомом ЦОДе применяется система горячи/холодных коридоров и используются межрядные теплообменники Knuerr, показавшие свою высокую эффективность на других моих проектах.

2greyhound72, а можете показать какой-то конкретный пример, желательно с фотографиями?

2 greyhound72

Ну я видел ЦОДы по 20-25 МВт на батарейках 🙂

Согласен — утопия.

И именно о них можно сказать, «парни, а вы освоением денег занимаетесь или делом?» 🙂

2 АК

Досконально не отвечу на ваш вопрос, но скажу что система управления DRUPS-ами и наша централизованная система управления, мониторинга и диспетчеризации, в которую интегрируется вендорная система позволяет в автоматическом и ручном режимах решать данную задачу.

Вообще опыта реализации сложных систем с DRUPS-ами у нас в стране нет, те проекты, которые были реализованы, либо слишком просты и малы, либо пока еще не работают в «полный рост».

Eugene, пример чего и какие именно фотографии? Постараюсь поискать или сделать на объекте на следующей неделе.

мимо проходил

Температура в контурах, конечно, не 7/12, но можно и повыше, зачем Вам в машзалах ниже 24-25 температура. Окно фрикулинга вырастет сильно.

2greyhound72 инженерной инфраструктуры дата-центра TIER III, при заявленном бюджете до 20 тыс. евро за кв.м.. В принципе можно попросить администрацию выложить отдельным топиком, если это возможно.

Наверное, лучше на форум пойти продолжать, посколкьу здесь и фото не выложить, и т.д. Да и админ будет против длинной дискуссии в комментариях, я так думаю. Просьба к админу: можете ли Вы перенести эту ветку в один из разделов форума?

Eugene, да, на следующей неделе снимки сделаю, только имейте ввиду, что, как я говорил, это объект в процессе строительства. А фото эксплуатируемых сейчас попробую поискать у себя.

greyhound72, конечно мы не против любой конструктивной дискуссии в топиках.

Что касается переноса в форум, техническим мы можем перенести только текст фотоэкскурсии, а комментарии к сожалению нет.

Думаю что обсуждение инженерской инфраструктуры дата-центра Электронной Москвы можно продолжить здесь, а для темы с фотографиями либо отдельно создать топик на форуме, либо Вы можете прислать их мне и мы опубликуем ввиде отдельной на статьи на сайте.

P.S. Если необходимо опубликовать какое-то изображение в комментариях на сайте, вставляете ссылку в текст, а мы оперативно ее загрузим, в ближайшее время постараемся реализовать это функционал.

author, спасибо!

Eugene, выложу фото по готовности в форум.

мимо проходил

Вот мои данные по последней инсталлированной системе холодоснабжения (климат чуть «хуже», чем московский):

51% FC — это полный фрикулинг

43% FC_DX — это частичный (конечно, не вполне информативно, но полная таблица за год это простыня не для размещения здесь)

6% DX — это на компрессорах (это screw, не турбокоры).

PUE=1.12 не расчетный, а годовой с BMS взятый

мимо проходил

А это — другая система, климат ужасающий, +45 по паре недель в году по 5-8 часов в день….

32% FC

53% FC_DX

15% DX

По PUE пока рано давать реальные данные. Компрессоры — Турбокоры. Кондеры — двухконтурные, один только на фрикулинг, через драйкулеры, вторые трубы — в реку с низкой температурой круглогодично, или в обход на чиллеры (это данные — для обхода, конечно, не для речки)

Предварительно PUE будет в пределах 1.25, но для такого климата это сильный результат.

Да, ДЦ из первого примера проектировался для Гугла 😉

Кому интересно — перенес тему: см. В Продолжение Комментариев… …к статье «Фотоэкскурсия в ЦОД Нагорная, Электронная Москва» на форуме

продолжение находиться по адресу: http://forum.telecombloger.ru/index.php/topic/1172/

Как так безответственно можно размещать материалы, характеризующие уровень компании, показывающие качество выполняемых ею работ, на ресурсах, где присутствуют помимо простых читателей, ещё и профессионалы данной отрасли, спроектировавшие и построившие не один ЦОД. Это мы не так схему резервирования указали, это маркетологи не те фотографии выложили, я в компании и РП, и частично ГИП, частично финансист. Ответственнее к делу пожходить нужно.

Кстати, в официальном релизе, указано, что ОБЩЕЕ энергопотребление 6 МВт. Вот ссылка на презентационные материалы — http://www.r-style.com/files/style/cod-em.pdf Чему верить? И на DatacenterDynamics 2012 должен был этот проект подробно освещаться — http://www.r-style.ru/presscenter/news/20121106173544/ Если кто из посетителей сайта был на данном мироприятии, поделитесь информацией. А может и Вячеслав Тихонов пояснит )))