Как ЗАО «Дата-Центр» строил свой ЦОД.

В Европе да и в Америки многие интеграторы ведут блоги с описанием всех этапов строительства новых Дата-Центров. Например в одном из моих постов я рассказывал о том, как Digital Realty Trust за 26 недель построила с нуля один из своих Дата-Центров.

Хочу отдать должное Ивану Карпухину, который не побоялся и выложил в интернете фотографии с описанием многих этапов строительства своего Дата-Центра, несмотря на некоторые недочеты, которые присутствуют в строительстве у подавляющего большинства строящихся Дата-Центров в России, он не стал их скрывать, а опубликовал все так как и было. За это ему отдельное спасибо.

Начиная отношения со своими клиента без лукавства и обмана со стороны Дата-Центра, не может не радовать!

Предлагаю Вашему вниманию фотографии с описанием всех этапов строительства ЦОД ЗАО «Дата-Центр» описанных на хабре Иваном Карпухиным:

Как известно, любой стартап начинается с фразы «Как же вы за***ли, лучше сам сделаю лучше».

В 2007 году положение с датацентрами в Москве, да и во всей России было критическим. Попасть туда простому хостеру можно было только по предварительной записи. Драли с него втридорога, сервера частенько перегревали, электричество периодически отсутствовало, и еще, стоило датацентру начать генерировать 2-3 гигабита полосы, как он тут же воображал себя царем горы, пытался барыжить твоим трафиком, а с несогласными боролся методом пускания моего трафика через узкий зашейпенный канал ***телекома зарубеж.

А общение с ночными дежурными датацентра — это отдельная песня. Чаще всего было проще приехать и самому найти вывалившийся патчкорд, чем полночи пытаться добиться от мало вменяемого, ничего не хотящего юноши. И это хорошо, если дежурный был и попасть в датацентр ночью было возможно. Некоторые датацентры работали с 9 до 5, кроме праздников и выходных дней. Все остальное время там не было НИКОГО. Сервер, упавший в пятницу вечером, пролежит, минимум, до дня понедельника.

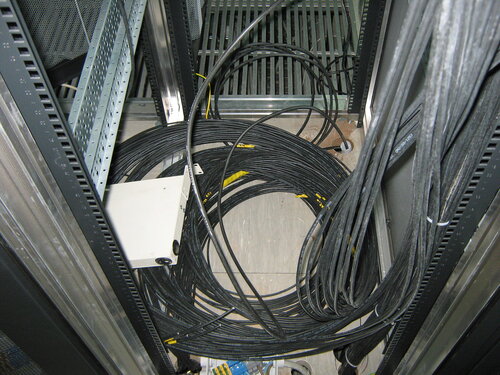

Картинка, о том, что творилось внутри типичного датацентра того времени.

Взято с сайта Nag.ru

Взято с сайта Nag.ru

Мне, к тому времени, это порядком надоело, и, как выход, я решил строить свой датацентр, ориентированный на запросы меня и моих пользователей.

А именно хотелось:

1) Нормального, качественного охлаждения с большим запасом на случай выхода одного из кондиционеров.

2) Беспроблемного электричества и обязательно собственный дизель.

3) Каналы и до местных Tier1 и до пира. Трафик должен стоить нормальных денег.

4) Своей, вышколенной и вменяемой круглосуточной смены на площадке.

Своими мыслями я делился с знакомыми и нашел сочувствующих. Был написан бизнес план. Не спеша были найдены деньги на запуск и клиенты, что бы не работать в минус после запуска.

Был найден и будущий исполнитель строительства датацентра — Группа компаний «Радиус»

С января 2008 года мы начали искать помещение. И не просто так, а размером 200-400 метров, с выделением 600 kW электричества, с обязательной регистрацией договора аренды на срок 5 лет. На первом этаже. Без транзитных труб. И что бы было куда повесить кондиционеры.

Такое удачное сочетание найти было не так просто. Поиски помещения продолжались весь 2008 год. Нашлось немало удачных вариантов, но увы, так или иначе мы не договаривались. Или электричество было по 2 цены, или договор аренды не более чем на 3 года, или вообще завод шел под реконструкцию через 2 года.

Итак прошел весь 2008 год. Зимой количество объектов вдруг резко увеличилось, а арендодатели вдруг стали соглашаться на наши условия, и в январе 2009 года помещение было найдено. Представляло оно из себя не очень приятное зрелище.

Приблизительно вот такое

И с другой стороны

Итак, договор аренды подписан, мы с специалистами группы компаний Радиус засучили рукава и начали делать рабочий проект. Большой такой, талмуд, страниц на 1000. В котором подробно описали как сделать из того, что есть, красоту необыкновенную, нужную нам. К марту проект был готов, и началась стройка.

Итак, проект готов, начались работы.

Так как я не строитель, а связист, в этой части будет много картинок и мало букв.

Прежде всего, строители выкинули все лишнее и сняли подвесные потолки.

Стало светлее и веселее.

Затем, с пола ломами убрали все лишнее, там были многолетнии слои асфальта поверх бетона.

Заложили шахты неработающих грузовых лифтов (Интересно, они ничего в лифт не спрятали?)

Отодрали старый утеплитель

И, не спеша, начали строить скелет гермозоны

Удалили все трубы из будущей гермозоны. Начали делать потолок от протечек сверху. Делаем стяжку.

Скелет сделан. Потолок сделан. Стяжка залита. Пора обшивать

Обшиваем негорючим утеплителем и негорючим влагонепроницаемым гипсокартоном.

Зачем ругаться, насяльника. Все хорошо будет сделано.

Обшили, заделали щели, покрасили гермозону белой краской.

Ставим рамы под юпсы.

Ура, фальшпол привезли. Какой же датацентр без фальшпола? Разве что первой категории надежности по TIA-942

С помощью похожего на НЛО приспособления и чайника собираем фальшпол. Контур заземления я упустил, но тут мы его уже видим.

Фальшпол собрали, почти готовая гермозона 🙂

Гермозона у меня есть, осталось нашпиговать ее по последнему слову техники. Начнем с электричества.

Ведь куда датацентру без электричества?

Прямо в помещении столько электричества, конечно, нет. Но есть в трансформаторной. Прокладка кабеля за счет арендатора.

Итак, копаем канаву по всему заводу.

Привозим кабелюку, бронированную, чтобы ей в земле хорошо лежалось.

Реклама Чувашкабеля детектед

Закопали. Положили, тремя слоями сверху, каждые полметра, ленту с надписью «осторожно кабель».

А в гермозону привезли вентиляционные решетки, материалы для воздуховодов.

И водо — фреоно водов. А также накрыли пол, чтобы очень его не загадить

Начали прокладывать разные трубки загадочного назначения

Подсказываю, черные — фреон, серые — слив сконденсированной влаги, белые — забор воды в увлажнители.

Тут и пожарные подоспели, привезли балоны с хладоном. Хорошие такие огнетушители

И давай монтировать систему пожаротушения.

Между делом привезли рамы для кондиционеров.

А вот и сами кондиционеры приехали.

Кондиционеры, конечно, прицензионные, Emerson Liebert HPM, с выдувом холодного воздуха под фальшпол. Всего запланировано 60 серверных шкафов не более чем по 6 kW каждый (Больше охлаждать воздухом не получается). Итого на 360 kW вероятной чистой мощности у нас 9 кондиционеров по 56 кW холода каждый.

Тем временем, систему пожаротушения доделали

Поставили внешние блоки

Картинка, вполне, в духе стимпанка.

Поставили щиты управления вытяжкой — приточкой.

Привезли серверные шкафы и начали собирать. И приточку вытяжку тоже.

Собрали шкафы

Шкафы Knürr 42 юнита, 900мм глубиной 600мм шириной. Шкафы шириной 800 мм роскошны, но увы, у нас места на 800 мм не хватило.

А вот и электричество.

Встречайте. UPS

И электрические шкафы.

Упсы Emerson Liebert, как ни странно. На 160 kVa, это 128 kW, тоже включены по схеме N+1 и питают чистое до запуска дизеля. Должно хватить на 15 минут при полной нагрузке, но дизель стартует куда раньше.

Поставили упсы на рамы

Чтобы было не скучно, сделали, наконец, освещение.

Закатили кучу проводов.

И давай их подключать

Чтобы время взря не терять, прикатили циску

Сделали комутационный шкаф и по всем шкафам протащили оптику

Смотрим налево

электричество подключили.

Смотрим направо, чего то не хватает? Конечно, дизеля не хватает. Грустно без дизеля.

Дизель едет-едет и приехал

Знатная зверюга на 730 kVa. 6 горшков, 2 турбины. 2 глушителя. Именитой итальянской фирмы Сoelmo. А как ревет…

Ну все, пора запускать все системы

И снимать красивые фотографиии

Типа таких.

Или таких

Открыть сайт www.webdc.ru Звать инспектора минсвязи и покупать мебель в офис.

» 6 kW каждый (Больше охлаждать воздухом не получается)»

это про энергетику и отведение тепла от каждой стойки идёт речь, на самом деле спорный вопрос 🙂

Есть возможность воздухом отводить от стойки до 7-8 кВт, а с применение доп. техн. решений воздухом и 15 кВт (конечно имею ввиду то, что можно включить в проект, не учитывая возможность компенсировать повышенное энергопотребление/тепловыделение за счёт мест установки энергоёмкого об-ия в ДЦ)

А вообще: молодцы!!! Браво! Учитывая поставленные цели, вполне-вполне. Жмём крепко руку.

p.s. при проектировании конечно бы посоветовал кое-что сделать иначе, что не изменило бы невысокой стоимости проекта, но было бы полезно.

А чтож не из соломы сделали гермозону?

Получился бы домик Наф-Нафа

EN1047-2 в России не знает ни кто!!!

Это, в принципе показано на примере данного ЦОД.

Защищать «скорлупу», прошу прощения, гермозону — от огня и воды слоями из гипсокартна — оригинально!!!

Денег на стройку истратили много, но могли чуточку меньше и получили зону по EN 1047-2 — ну почти….

А так, хорошее решение.