iDataCool – выделяемое серверами тепло служит для охлаждения других серверов

В небольшом городке на краю Полярного круга соцсеть Facebook построила свой первый дата-центр за пределами Соединенных Штатов Америки. ЦОД в шведском городе Лулео инженеры назвали Node Pole (Узловой полюс) из-за огромного потока данных, которые скоро будут через него проходить. У данного кампуса есть огромный потенциал. Тут полно земли: дата-центр Facebook занимает площадь, которая эквивалентна пяти футбольным полям. Тут имеется дешевая электроэнергия: мощная река Лулео вместила несколько гидроэлектростанций, которые вырабатывают избыточное количество электричества, с лихвой удовлетворяя все потребности ЦОД. Тут постоянно холодно: среднегодовая температура в Лулео составляет 1.3 °С, что позволяет существенно удешевить процесс охлаждения серверного оборудования.

В небольшом городке на краю Полярного круга соцсеть Facebook построила свой первый дата-центр за пределами Соединенных Штатов Америки. ЦОД в шведском городе Лулео инженеры назвали Node Pole (Узловой полюс) из-за огромного потока данных, которые скоро будут через него проходить. У данного кампуса есть огромный потенциал. Тут полно земли: дата-центр Facebook занимает площадь, которая эквивалентна пяти футбольным полям. Тут имеется дешевая электроэнергия: мощная река Лулео вместила несколько гидроэлектростанций, которые вырабатывают избыточное количество электричества, с лихвой удовлетворяя все потребности ЦОД. Тут постоянно холодно: среднегодовая температура в Лулео составляет 1.3 °С, что позволяет существенно удешевить процесс охлаждения серверного оборудования.

Однако любая высокотехнологическая компания, решившая спроектировать, построить и запустить крупный дата-центр в Арктике всенепременно сталкивается с одной проблемой. По словам Акселя Ауетера, который является научным сотрудником Центра суперкомпьютерных вычислений им. Лейбница в Германии, несмотря на оптимальные температурные условия для работы ЦОД в регионе, талантливые инженеры не обязательно захотят покидать обжитые места, чтобы там работать. Ауетер и его коллеги работают над новой системой охлаждения для SuperMUC. Эта машина заняла девятую строчку в списке TOP500 самых мощных суперкомпьютеров в мире за июнь текущего года.

«Мы предлагаем инженерное решение, которое действительно может помочь тем людям, которые из-за тех или иных причин все еще не решаются на переезд в северные регионы, где в зимнее время довольно темно и холодно. Не так уж и много квалифицированных людей хотят там работать», говорит он.

Группа Ауетера является одной из нескольких инженерных команд, которые создают новые виды систем охлаждения для суперкомпьютеров и крупных дата-центров. Принципы работы подобных решений выходят далеко за рамки регулирования температуры серверного оборудования с помощью воздуха. Вместо этого разработка Ауетера сотоварищи использует воду.

Новая технология была представлена на Международной конференции по суперкомпьютерам 2013, которая совсем недавно состоялась в Лейпциге (Германия). Там команда исследователей из Университета Регенсбурга (который опять же находится в Германии) представил результаты годичной работы над передовой технологией жидкостного охлаждения, которая предназначена для монтажа в крупномасштабных и очень “горячих” компьютерных кластерах. Решение может охладить крупнейшие дата-центры в мире за счет повторного использования части тепла, выделяемого элементами высокопроизводительных вычислительных систем.

По сути дела избыточное тепло можно использовать для снабжения энергией особого холодильника, который называется адсорбционным чиллером. Чиллеры позволяют охлаждать воду, которая затем используется для охлаждения других серверов в дата-центре или применяется для кондиционирования воздуха в помещениях, где размещается персонал. Исследователи окрестили свою систему iDataCool.

«Электрическая энергия, которая подается в сервер, превращается в тепло, и если бы вы могли повторно использовать это тепло, то вам удалось бы восстановить большую часть энергии и минимизировать совокупный расход на эксплуатацию IT- и вспомогательного оборудования. То есть можно было бы уменьшить количество денег, которые кампания вкладывает в свой дата-центр», говорит Тило Веттиг, профессор физики из Университета Регенсбурга, который был частью команды, спроектировавшей систему iDataCool.

Большинство компьютеров, от нетбуков до высокопроизводительных систем, охлаждаются воздухом, что имеет очевидные преимущества. Воздуха всегда хватает, а системы воздушного охлаждения отличаются предельной простой в проектировании, производстве и сборке. С другой стороны системы жидкостного охлаждения являются более дорогими и должны быть тщательно протестированы перед выводом в серию. Они требуют больше ухода, при этом протечка в водоводах может привести к короткому замыканию в системе и нанести непоправимый ущерб всему кластеру. Все это создает впечатление, что энтузиасты, решающие использовать жидкостное охлаждение, выбирают намного более рискованный подход. Тем не менее, сторонники подобных платформ говорят, что они (СЖО) тщательно испытываются перед началом продаж, что сводит риск поломки к минимуму.

«Мы многому научились, работая над этим проектом. Есть множество средств, позволяющих убедиться в безопасности эксплуатации такого рода системы», говорит Ауетер. Инженер отметил, что при тщательном тестировании материалов и благодаря использованию ряда инженерных хитростей система может оказаться не только крайне безопасной и стабильной, но и будет требовать меньшего обслуживания по сравнению с системами воздушного охлаждения.

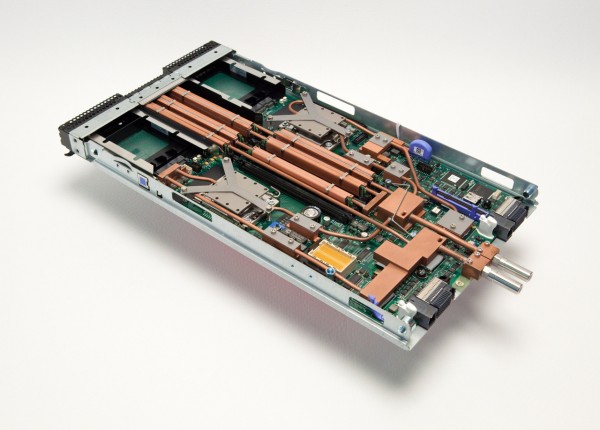

Именно такими соображениями руководствовались разработчики iDataCool. Система, по сути, является компьютерным кластером, который функционирует как исследовательская платформа для анализа эффективности системы охлаждения IT-оборудования. Проект был осуществлен в сотрудничестве с исследовательской лабораторией IBM в Беблингене (Германия). Поэтому исследователи внедрили свой механизм рекуперативного жидкостного охлаждения в серверную систему производства компании IBM, которая называется iDataPlex. Эта серверная система была разработана специально для организации высокопроизводительных вычислений в дата-центрах.

iDataCool состоит из трех серверных стоек с семьюдесятью двумя вычислительными узлами в каждой. Внутри каждого вычислительного узла работает либо пара четырехъядерных процессоров Intel Xeon E5630 с частотой в 2.53 гигагерца или же два шестиядерных процессора Intel Xeon E5645 с частотой в 2.40 гигагерца, что обеспечивает действительно впечатляющую производительность, которая увеличивается за счет 24 гигабайт оперативной памяти. Первоначально система iDataPlex охлаждалась целиком и полностью с использованием воздуха. Чтобы построить iDataCool, ученые полностью переработали систему охлаждения, но при этом они оставили все остальные компоненты нетронутыми.

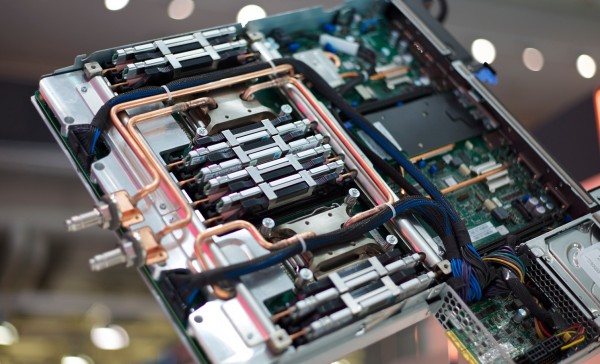

«Мы не вносили никаких изменений в программно-аппаратное обеспечение,» говорит Нильс Мейер, научный сотрудник Университета Регенсбурга, который также работал над iDataCool. «Однако мы убрали все элементы, которые необходимы для организации системы воздушного охлаждения: вентиляторы и радиаторы. Все они были заменены нашими собственными разработками, позволяющими охлаждать процессор, память и все остальные IT-компоненты кластера, которые во время работы становятся довольно горячими… и охлаждаются они непосредственно с использованием воды».

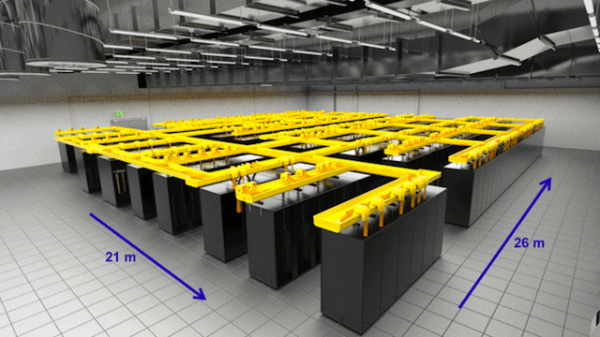

В iDataCool используется схема, которая называется “охлаждение горячей воды”. Аналогичная технология используется в машине SuperMUC, которая работает в Центре суперкомпьютерных вычислений им. Лейбница. (фактически система iDataCool выступала завещающей тестовой платформой, прежде чем система была установлена в SuperMUC). В немецком суперкомпьютере тепло передается от серверов посредством содержащих воду микроканалов в помещения, где трудятся инженеры.

«Это очень рациональный подход», говорит Веттиг. «Но летом такое сильное отопление нам не нужно, а в некоторых странах с относительно теплым климатом отопление не нужно вообще… В этом случае, вам нужно даже тратить некоторое количество электроэнергии для отвода тепла».

Веттиг отмечает, что вместо отопления помещений, где размещаются люди, система инженеров из Университета Регенсбурга позволяет использовать тепло для запитки адсорбционных чиллеров, которые в свою очередь отвечают за организацию климат-контроля в рабочих помещениях или используются для охлаждения серверного оборудования.

Ключевой инновацией iDataCool является низкая стоимость установки, которая достигается за счет использования специально разработанных медных радиаторов. Именно через эти радиаторы и проходит вода, предающая тепло от одного элемента системы другому. Водоблоки, которые устанавливаются поверх процессоров, жестко припаяны к медным трубопроводам с проточной водой, которые также присоединены к водоблокам на других компонентах системы, таких как память и контроллеры напряжения.

Энергия от всей этой нагретой водой идет на запитку адсорбционных чиллеров, которые работают с повышенной эффективностью, когда поступающая вода нагревается выше 65 °C. Чиллеры охлаждают воду, которая затем используется внутри отдельного контура охлаждения вычислительного кластера. Внешние охладители, которые также могут здесь использоваться, в перспективе могут быть полностью заменены на адсорбционные чиллеры.

Несмотря на тот факт, что адсорбционные чиллеры лучше всего работают при температуре выше 65 °C, сами процессоры потребляют меньше электроэнергии, работая при более низких температурах. Таким образом, в рассматриваемом кластере процессоры потребляли на 5 процентов больше электроэнергии, чем при идеальной рабочей температуре. Тем не менее, дополнительное электропотребление более чем компенсировано 90-процентным повышением КПД адсорбционных чиллеров. С помощью этой системы операторам кластера iDataCool удалось восстановить около 25 процентов энергии, которая в случае применения традиционных систем охлаждения была бы безвозвратно потеряна.

Ауетер видел iDataCool в действии и думает, что это хорошо продуманная система. «Честно говоря, я думаю, что… они на самом деле решили всех ключевые проблемы и создали систему охлаждения с относительно высокотемпературным хладагентом», говорит он.

Веттиг отмечает, что после установки системы перед командой инженеров не возникали какие-либо серьезные проблемы, но он также признался, что у СЖО был один недостаток, который мог быть устранен. «Мы теряем много тепла, которое нагревает воздух внутри вычислительного центра, потому что серверные стойки плохо изолированы», говорит он. По данным исследователей, при использовании улучшенной теплоизоляции около 50 процентов теряемой энергии может быть восстановлено.

Охлаждение серверного оборудования с помощью теплой воды и повторное использование тепловой энергии до сих пор считаются относительно новыми технологиями в сегменте высокопроизводительных вычислительных систем, но Ауетер искренне считает, что это самый лучший вариант – особенно для суперкомпьютеров, установленных в регионах с теплым климатом. Он говорит, что наиболее существенным препятствием на пути к массовому внедрению технологии является страх чрезмерного инвестирования в систему, которая до сих пор широко не используется.

«Когда дело доходит до траты большого количества денег, люди, как правило, становятся очень консервативными и придерживаются проверенных технологий. В нашем случае это будет означать, что они придерживаются воздушного охлаждения», говорит Ауетер. «Но я думаю, что сейчас для всех нас важно наличие примера успешной установки таких систем как iDataCool. Анализируя подобные примеры, консервативные операторы ЦОД смогут понять, что риск внедрения СЖО на самом деле не такой высокий, как может показаться изначально».

Всего комментариев: 0