Фото-экскурсия по новому Дата-Центру Facebook в Прайнвилль, штат Орегон

Некоторым счастливчикам повезло, для них провели живую экскурсию по новому Дата-Центру Facebook в Прайнвилль, штат Орегон. Многим из нас такое счастье не светит и в ближайшей перспективе, поэтому нам остается довольстоваться обзорной фото-экскурсией от тех самых счастливчиков, которые побывали в одном из самых энергоэффективных Дата-Центров мира. В дополнении, несколько панорамных фотографий с углом обзора 360 градусов и 8-ми минутным видео туром по Дата-Центру.

Некоторым счастливчикам повезло, для них провели живую экскурсию по новому Дата-Центру Facebook в Прайнвилль, штат Орегон. Многим из нас такое счастье не светит и в ближайшей перспективе, поэтому нам остается довольстоваться обзорной фото-экскурсией от тех самых счастливчиков, которые побывали в одном из самых энергоэффективных Дата-Центров мира. В дополнении, несколько панорамных фотографий с углом обзора 360 градусов и 8-ми минутным видео туром по Дата-Центру.

Новый дата-центр Facebook, настолько большой, что у него есть свой флаг

Солнечные панели

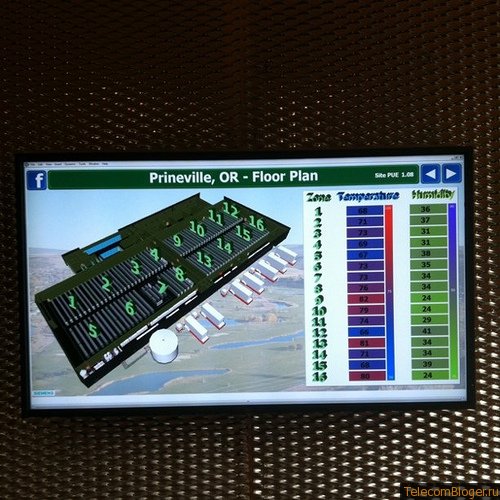

В холле расположен монитор, который показывает состояние системы охлаждения центра обработки данных.

Пройдя дверь системы безопасности, мы упираемся в интерпретацию социальные сети из одеял, сделанную сотрудниками Дата-Центра Facebook

Операционный директор площадки Томас Ферлонг (Thomas Furlong), показывает помещения, которые обрабатывают внешний воздух. Первое помещение фильтрует воздух. Второе помещение фильтрует уже отфильтрованный первым помещением воздух.

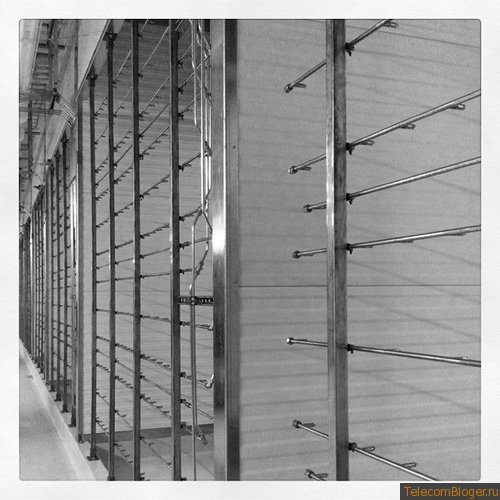

На фото ниже, Томас показывает огромную стену воздушных фильтров

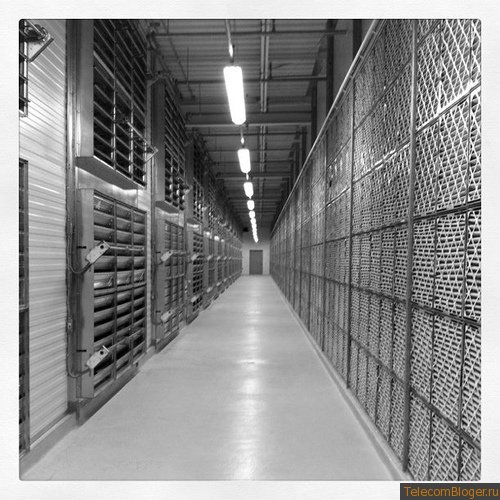

Коридор с помещениями для фильтрации воздуха

После очистки, воздух попадает в третье помещение и в нем смешивается до состояния оптимальной влажности и температуры. Напротив установлены вентиляторы с двигателями по 5 лошадиных сил каждый.

На фотографии ниже, задняя часть фильтров.

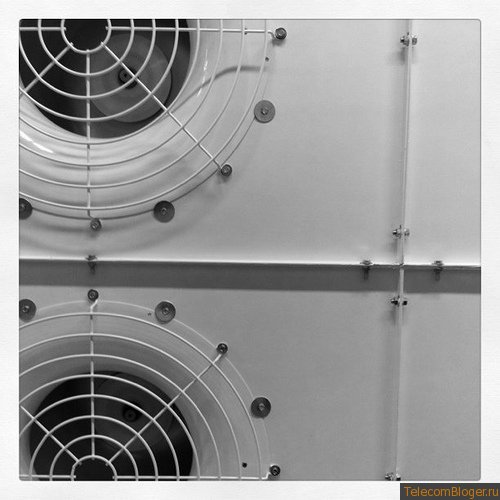

а вот и сами вентиляторы

Вентилятор, который всасывает воздух в Дата-Центр через всю систему фильтрации воздуха, крупным планом

Вытяжные вентиляторы, выбрасывающие отработанный горячий воздух

Еще один шаг перед тем, как воздух попадет в серверное помещение. Воздух пропускают через форсунки, распыляющие воду. За счет быстрого испарения воды, происходит охлаждение воздуха. Вода, которая распыляется, проходит отчистку в отдельном помещении.

И последний набор фильтров не позволяющий проникнуть воде в гермозону

Форсунка распыляющая воду крупным планом

Холодный коридор Дата-Центра FaceBook

Панорамные виды Дата-Центра facebook, для просмотра кликните на картинку

Солнечные панели Дата-Центра FaceBook

И 8 минутный видео ролик о Дата-Центре

По материалам: scobleizer.com

Ничего-ничего, лет через 10 и в России такие строить начнут. Ведь первый ЦОД в Uptime сертифицировали, и всего-то понадобилось 18 лет чтоб до этого дозреть 🙂

Конкретно до этого не дойдут. Адиабатическое охлаждение требует большое пространство, да и степень очистки воды должна быть очень высокой.

А вот PUE окончательно дискредитировали. Как можно поверить в 1.07, если потери только на ИБП будут не менее 7%, да и то на полной нагрузке.

Насколько я понял там в основном питание DC, соответственно потери меньше.

Но в 1,07 тоже верится с трудом…

grey72 почему не дойдут? В SafeDatа этим летом с жарой таким способом боролись +40 в Москве

то author

Это была штатное решение в SafeData ? 😀

Заложенное при строительстве ?

to АК:

Ну конечно нет ), но зато оно было реализовано у нас и этот факт не может не радовать!

Потом чиллеры очищать от примесей воды очень хлопотно…. Нужна специальная система очистки, да, кроме того, это мелкодисперсная вода, если не очищать, то форсунки забьются быстро. Пробовал я это спроектировать для холодного климата, да отказался — очень много проблем.

to grey72

не расскажите более подробно, что за проблемы возникли?

проблемы с холодным периодом, адиабатику предполагалось поставить для чиллеров. При наступлении холодов одной автоматикой систему не удалось перевести в зимний режим (да и просто выключить нельзя), требовалась ручная работа, слив воды, кроме того, форсунки чувствительны к сезонным перепадам температур (при зоходе в минусовую зону). После сезонного потепления — обратная процедура. Вобщем, вышло экономически неоправданно.