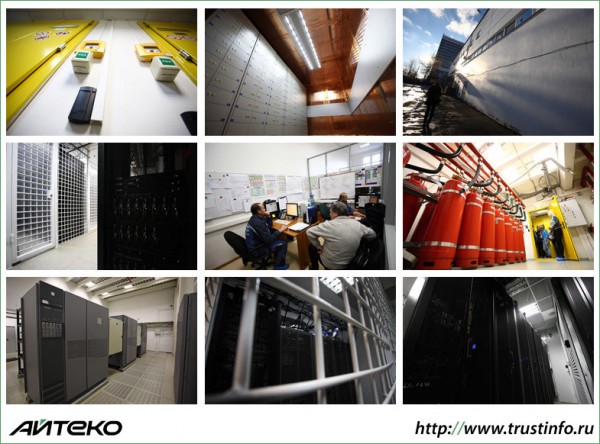

Фото экскурсия по Дата-Центру «Траст-Инфо»

Дата-центр «ТрастИнфо» — один из крупнейших коммерческих ЦОДов России. Он спроектирован и построен по стандарту TIA-942 и соответствует уровню надежности 3 (Tier III), показатель бесперебойной работы составляет 99,982%. Такой уровень дает клиентам достаточно серьезную уверенность в том, что их данные надежно защищены. Предлагаем вашему вниманию фотоэкскурсию по ЦОД «ТрастИнфо».

ЦОД «ТрастИнфо» находится на территории Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) — одного из старейших предприятий-разработчиков средств вычислительной техники и системного программного обеспечения в России, созданного в СССР в конце 1940-х годов. НИЦЭВТ — режимный объект, вход на территорию осуществляется только по специальным пропускам.

Современный ЦОД — это комплекс сложных инженерных систем, позволяющих организовать безопасную и бесперебойную работу серверного и телекоммуникационного оборудования. В «ТрастИнфо» размещено оборудование клиентов «Ай-Теко» и самой компании. Энергопитание «ТрастИнфо» организовано от двух подстанций, здесь можно размещать оборудование с высоким энергопотреблением. Среднее энергопотребление на стойку – 5 кВт. Максимально возможное размещение оборудования – 15 кВт со стойки.

Еще одним колоссальным преимуществом ЦОД «ТрастИнфо» является артезианская скважина прямо на территории. В здании размещены теплообменники, которые осуществляют холодообмен между этиленгликолем внешних контуров системы охлаждения с холодной водой двух внутренних контуров холодоснабжения — и эта вода берется именно из артезианской скважины, ее температура +7°C. А во внутренней системе водоснабжения используется накопительный бак холода на 2000 кубометров воды, расположенный прямо тут же, под зданием, ниже глубины промерзания грунта. При необходимости можно будет обеспечить 4 часа автономного охлаждения дата-центра при полной загрузке мощностей, также этот ресурс системы охлаждения позволяет аккумулировать холод и сглаживать пики тепловыделения оборудования в машинных залах.

За этой массивной дверью — машинный зал. Всего таких залов в «ТрастИнфо» — 10 (9-й и 10-й запущены в эксплуатацию в конце декабря 2012 года).

В этих «клетках» — серверы клиентов «ТрастИнфо». Многие серверные стойки защищены сварными решетками и кодовыми замками, чтобы исключить возможность физического несанкционированного доступа.

Стойка с оборудованием клиента (собственным или арендованным) также может, в соответствии с требованиями заказчика, отгорожена плексигласовыми щитами. Это позволяет создавать особые температурные условия, например — более низкую температуру. Такой способ дополнительного охлаждения применяется для особо нагруженных серверов. Вентиляционная система ЦОД «ТрастИнфо»позволяет поддерживать оптимальный температурный режим и настраивать его индивидуально, согласно потребностям клиентов.

«Свободная касса»… точнее, розетка-«груша» для подвода электричества к оборудованию

Серверные стойки. За перфорированным фальш-потолком — коммуникации и инженерные системы.

Вентиляционная камера. В дата-центре используются холодильные машины (чиллеры) производства Stulz (Германия) с холодопроизводительностью 100 КВт. Каждая машина подключена к двум контурам водоснабжения, что позволяет обеспечить непрерывность работы всех кондиционеров в случае проведения регламентных и ремонтных работ на трассах холодоснабжения или на чиллерах.

Для разграничения доступа к оборудованию в машинных залах и к инженерным систем дата-центра все чиллеры вынесены за пределы машинных залов. Доставка холодного воздуха и отбор нагретого осуществляется через специальные клапаны под фальшполом и за фальшпотолком машинных залов. Высоты фальшпола и фальшпотолка рассчитаны таким образом, чтобы обеспечить необходимый воздухообмен. Это уникальное для российских дата-центров решение.

Все трассы кондиционирования задублированы, кондиционеры имеют систему резервирования «N+1». Они объединены в автоматическую сеть, работа которой управляется автоматикой — исходя из показаний датчиков температуры и влажности, расположенных в кондиционерах, под фальшполом и за фальшпотолком в машинных залах.

Все помещения дата-центра входят в единую систему пожаротушения, которая состоит из цифровой станции производства Schrack (Австрия) и газового оборудования производства АРТСОК. Система интегрирована с пожарной сигнализацией и охранной сигнализацией дата-центра.

Установка пожаротушения состоит из модуля с огнетушащим веществом (Хладон-125). 18 баллонов и управляющее оборудование размещены в выделенном помещении. Их резервирование — по схеме «2N» — то есть в два раза больше, чем необходимо по расчетам (и больше, чем требуется по стандарту Tier III). Из этого помещения сделана трубопроводная разводка по всем помещениям ЦОД.

Зал ИБП — часть системы энергоснабжения ЦОД «ТрастИнфо». Дата-центр укомплектован ABP — системой автоматического ввода резерва. При отсутствии электропитания от двух штатных подстанций ЦОД перейдет на резервное питание от аккумуляторов. Расчетное время работы ИБП составляет 10-15 минут (до полной разрядки аккумуляторных батарей – 45 минут). Этого времени достаточно для запуска ДГУ — дизель-генераторных установкок. Запас дизельного топлива рассчитан более чем на 9 часов работы при полной нагрузке. В случае необходимости более длительной работы на ДГУ организуется непрерывный подвоз солярки, и ЦОД будет работать в таком режиме столько, сколько надо.

Аккумуляторные батареи.

«Медная комната» — специальное помещение, полностью обшитое медными листами. Оно обеспечивает защиту данных, записанных на магнитных лентах, от электромагнитного излучения.

В сейфах, установленных в медной комнате, хранятся носители с критически важными данными, доступ в это помещение строго ограничен.

Новый машинный зал готовится к подключению новых серверных стоек

Помещение дежурных инженеров

Местный «центр управления полетами» — диспетчерская комната мониторинга инженерных систем ЦОДа. Все в real-time.

Дежурный инженер «ТрастИнфо» проверяет работу оборудования

Технические работы

В мире BigData

Фоторепортаж подготовлен во время пресс-тура в ЦОД «ТрастИнфо» в декабре 2012 года.

ДГУ — 72 часа работы — интересно, а где на фото емкость для хранения ГМС? (вероятно с учётом требований емкость закопана под землю и соблюдены все нормы по близлежащим зданиям и сооружениям 🙂 )

Ну почему все делают потолки из этих страшных плит как в офисах…..

Бак с водой для чиллеров находится под землей вот в этом месте

На счет баков с топливом пока информации нет

согласовать склад ГСМ (с учётом объемов необходимого топлива для ДГУ на 72 часа только так) — достаточно сложно.

А в чем прикол прокладки СКС в лотках при наличии фальшпола?

Вполне вероятен вариант когда высоты фальшпола не хватает для прокладке всего СКС.

При большом количестве шкафов в одном помещении, необходимо проложить существенное количество СКС, это приводит к значительной концентрации лотков и кабелей в подфальшпольном пространстве, что в свою очередь может отразиться на проходимости воздуха и как следствие перепада уровня давления воздуха в разных точках автозале.

В коммерческих Дата-Центра очень часто появляются потребности по прокладке дополнительных кабелей, а при включенных кондиционерах, инженерам будет очень сложно проложить дополнительные кабеля в подфальшпольном пространстве, поэтому в дополнении используются подвесные лотки над шкафами.

+ зачастую под фальшполом прокладываются кабели питающие (энергитека), прокладывать вместе с ними СКС крайне не желательно.

В TIA — 942 написано следующее, не менее 300 мм между лотками c экранированными силовыми кабелями и медными кабелями типа «витая пара».

Если выполнять эти условия, то ничего страшного не произойдет, при прокладке всех кабелей в подфальшпольном пространстве

Там силовые кабели со слаботочкой все идет по верху стоек, под фальшполом только оптика. Причем слаботочка с силовыми переплетаются постоянно и ни о каких 300мм там речи не идет.

Также частенько в зале влажность повышенная и температура вырастает аж сам как в бане себя чувствуешь, ибо экономят они.