Названы причины 7-часового глобального отключения ЦОД Facebook

В понедельник 4 октября 2021 года инфраструктура дата-центров Facebook дала сбой, из-за которого пользователи сервисов интернет-гиганта со всего мира лишились доступа непосредственно к одноименной социальной сети, а также к Instagram, WhatsApp и Oculus. Результатами семичасового отключения стали обвал котировок акций интернет-гиганта и отток пользователей в альтернативные сервисы.

В понедельник 4 октября 2021 года инфраструктура дата-центров Facebook дала сбой, из-за которого пользователи сервисов интернет-гиганта со всего мира лишились доступа непосредственно к одноименной социальной сети, а также к Instagram, WhatsApp и Oculus. Результатами семичасового отключения стали обвал котировок акций интернет-гиганта и отток пользователей в альтернативные сервисы.

Эксперты впоследствии назвали данный инцидент наиболее масштабным и продолжительным в истории интернет-компании за более чем десятилетие. Лишь в 2008 году случилась авария сопоставимого масштаба со схожей продолжительностью. Тогда соцсеть Facebook оставалась недоступной около суток. Однако 13 лет назад ей пользовалось лишь 80 млн. человек, тогда как WhatsApp и Instagram, ныне принадлежащие Facebook, на момент предыдущего крупномасштабного инцидента вообще не существовали.

Сегодня пользовательская аудитория одной лишь соцсети Facebook составляет свыше 2,9 млрд. При этом все веб-сервисы интернет-корпорации способны похвастать более чем 7 миллиардами активных аккаунтов, которые принадлежат пользователям со всего мира.

Причины аварии

После непродолжительного внутреннего расследования инженеры Facebook предоставили общественности подробную информацию о причинах недавнего инцидента. Представители компании отметили, что ей принадлежат центры обработки данных двух типов.

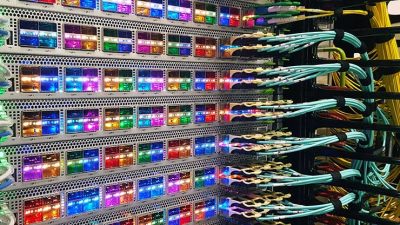

ЦОД первого типа представляют собой «крупные здания, в которых находятся миллионы единиц IT-оборудования», выполняющего основные задачи в части вычислений и хранения информации. Дата-центры второго типа – это «объекты меньшего размера, которые соединяют внутреннюю магистральную сеть между ЦОД Facebook с остальным интернетом и людьми, использующими платформы и сервисы компании».

Пользователи сервисов Facebook сначала обслуживаются небольшими объектами, которые затем отправляют трафик через магистраль Facebook в более крупные центры обработки данных. Подобно любой иной сложной системе, вычислительная инфраструктура требует обслуживания. Инженеры Facebook не справились с данной задачей.

«В ходе плановых работ по техническому обслуживанию была введена команда с намерением оценить доступность глобальной магистральной сети, что привело к непреднамеренному отключению всех соединений в магистральной сети, фактически отключив центры обработки данных Facebook по всему миру», — отмечается в пресс-релизе интернет-корпорации по итогам расследования.

Ранее инженеры соцсети разработали системы, предназначенные для предварительного аудита таких команд, чтобы предотвратить подобные ошибки, но ошибка в коде самого инструмента аудита помешала ему должным образом оценить риски и предотвратить ввод злополучной команды.

Полное отключение соединений между серверными системами Facebook внутри центров обработки данных и интернетом вызвало вторую проблему, которая усугубила ситуацию. Одна из задач, выполняемых небольшими ЦОД, — обработка запросов DNS. Система доменных имён (Domain Name System) или DNS — это «адресная книга» интернета. Она позволяет преобразовывать простые веб-имена, вводимые пользователями в браузеры , в определенные IP-адреса серверов.

За подобные преобразования отвечают принадлежащие Facebook полномочные сервера доменных имен (Authoritative Name Server; A DNS) c хорошо известными IP-адресами, информация о которых, в свою очередь, передается остальной части интернета через другой протокол. Речь о так называемом пограничном (внешнем) шлюзовом протоколе (Border Gateway Protocol; BGP), являющемся основным протоколом динамической маршрутизации, используемым в интернете .

DNS-серверы Facebook отключают распространение информации через BGP, если они сами не могут взаимодействовать с центрами обработки данных корпорации, поскольку это указывает на некорректное сетевое соединение.

Из-за недавнего сбоя вся магистраль оказалась неисправной, что привело к отключению BGP. Конечным результатом стало то, что DNS-серверы оказались недоступны, хотя они все еще работали. В результате остальная часть интернета просто перестала «замечать» серверные системы Facebook.

Устранение последствий

Масштабный инцидент оказал влияние на всю инфраструктуру Facebook, включая системы, связанные с обеспечением физической безопасности серверного оборудования и офисных помещений. Инженеры долгое время не могли получить доступ к центрам обработки данных обычными способами, потому что их сети были отключены и, соответственно, карточки доступа не могли открыть электронные замки.

В результате инженеры оказались вынуждены воспользоваться угловой шлифовальной машиной, чтобы вскрыть двери и попасть внутрь ЦОД. Кроме того, во время даунтайма сотрудники компании, работающие в обычных офисах, оказались заблокированы за пределами своих рабочих мест из-за прекращения работы внутренней системы безопасности, что также затрудняло восстановление. В довершение ко всему, полная потеря DNS нарушила работу многих внутренних инструментов, которые обычно используются для расследования и устранения подобных сбоев.

Компания достаточно оперативно отправила инженеров в центры обработки данных. К сожалению, потребовалось очень много бесценного времени, чтобы не только добраться до защищенных объектов с неработающими системами контроля доступа и попасть внутрь, но и восстановить работоспособность инфраструктуры ЦОД. Современное IT-оборудование и маршрутизаторы сложно модифицировать – даже при наличии физического доступа.

После восстановления магистрали все было готово к возобновлению работы сервисов, но команда опасалась сбоев из-за приближающегося всплеска трафика. Отдельные центры обработки данных сообщали о спадах энергопотребления в диапазоне десятков мегаватт, и внезапный всплеск энергопотребления после возвращения пользователей мог поставить под угрозу все: от электрических систем до серверов.

Стремясь минимизировать риски, инженеры компании использовали опыт предыдущих тренировок по восстановлению после серьезного сбоя, что позволило медленно вернуть платформу в рабочий режим без происшествий.

«Мы проделали обширную работу по укреплению наших систем для предотвращения несанкционированного доступа, и было интересно увидеть, как это укрепление замедлило нас, когда мы пытались восстановиться после сбоя, вызванного не злонамеренными действиями, а нашей собственной ошибкой. Подобный компромисс того стоит: значительно повышенная повседневная безопасность по сравнению с более медленным восстановлением после, надеюсь, редкого инцидента, подобного этому», отмечается в официальном пресс-релизе.

Всего комментариев: 0