Какие системы охлаждения серверов показали на Supercomputing 2022: фотоотчет

Можно с уверенностью утверждать, что жидкостное охлаждение серверов стало ключевой горячей темой Международной выставки-конференции по высокопроизводительным вычислениям, сетевому оборудованию, системам хранения и анализу данных Supercomputing 2022 (SC22), проходившей с 13 по 18 ноября 2022 года в городе Даллас, штат Техас (США).

Можно с уверенностью утверждать, что жидкостное охлаждение серверов стало ключевой горячей темой Международной выставки-конференции по высокопроизводительным вычислениям, сетевому оборудованию, системам хранения и анализу данных Supercomputing 2022 (SC22), проходившей с 13 по 18 ноября 2022 года в городе Даллас, штат Техас (США).

Насколько мог видеть глаз, выставочный зал был заполнен серверами с жидкостным охлаждением, резервуарами для иммерсионного охлаждения с диэлектрическим минеральным маслом, а также всевозможными фитингами, насосами и узлами распределения охлаждающей жидкости (CDU).

Именно такие устройства могут понадобиться команде центра обработки данных, нацеленной на развертывание IT-оборудования с повышенной плотностью мощности комплектующих при одновременном сокращении энергопотребления инфраструктуры охлаждения.

Учитывая тематику выставки-конференции SC22, которая посвящена главным образом высокопроизводительным вычислениям и суперкомпьютерам, акцент на управлении температурным режимом не должен вызывать удивления.

Но с появлением центральных и графических процессоров мощностью 400 Вт и 700 Вт, соответственно, в составе обычных серверов для корпоративных центров обработки данных, рассматриваемая задача уже начала выходить за рамки суперкомпьютерного сегмента.

Поскольку все больше предприятий стремится добавить в свои центры обработки данных системы с поддержкой искусственного интеллекта / машинного обучения, серверные системы мощностью 3 кВт, 5 кВт или даже 10 кВт уже не являются чем-то из ряда вон выходящим.

Ниже доступно описание, дополненное фотографиями, наиболее интересных продуктов для оптимизации температурного режима вычислительной техники, представленных на недавней выставке Supercomputing 2022, включая решения для ЦОД.

Прямоконтактное жидкостное охлаждение

Подавляющее большинство систем жидкостного охлаждения, представленных на выставке SC22, относятся к категории прямоконтактных. Иными словами, конструкция подобных устройств предполагает размещение непосредственно на чипе теплосъемника с двумя отверстиями: для подачи рабочего тела и удаления нагревшегося хладагента. Они заменяют традиционные медные или алюминиевые радиаторы и вентиляторы, предлагая охлаждающие пластины, многочисленные резиновые трубки и фитинги.

Все охлаждающие пластины выглядят более или менее одинаково, представляя собой, по сути, просто металлический блок, внутри которого циркулирует жидкость. Обратите внимание, что применительно к прямоконтактному охлаждению используется именно термин «жидкость», поскольку в подобных системах могут использоваться любые хладагенты – не обязательно являющиеся водой / ее производными.

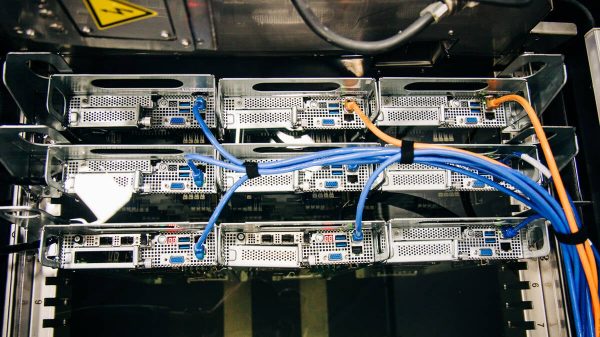

Сервер с жидкостным охлаждением от Supermicro, оснащенный охлаждающими пластинами CoolIT.

Во многих случаях OEM-производители закупают охлаждающие пластины у одних и тех же поставщиков. Например, CoolIT поставляет оборудование для жидкостного охлаждения нескольким OEM-производителям, включая HPE и Supermicro.

Однако внешняя схожесть охлаждающих пластин не означает отсутствие возможностей для дифференциации. Внутренняя часть этих блоков заполнена массивами микроребер, которые можно настраивать произвольным образом для оптимизации потока проходящей через них жидкости. Внутренняя часть этих пластин может сильно различаться в зависимости от размера / количества ребер.

В большинстве систем с жидкостным охлаждением, которые были представлены на выставке SC22, использовались резиновые трубки для соединения охлаждающих пластин. Трубки не прилегали к электронике. Это означает, что жидкость охлаждает только определенные компоненты: центральный и графический процессор. Таким образом, хотя большую часть вентиляторов можно снять при установке системы жидкостного охлаждения, некоторый поток воздуха все же требуется.

HPE демонстрирует новейшие блейд-серверы Cray EX с жидкостным охлаждением, использующие 96-ядерные процессоры AMD Epyc 4.

Блейд-серверы Lenovo Neptune и HPE Cray EX были исключением из этого правила. Их системы специально созданы для жидкостного охлаждения и до отказа набиты медными трубками, распределительными блоками и охлаждающими пластинами для всей «начинки», включая ЦП, ГП, оперативную память и сетевые карты. Используя этот подход, HPE удалось «втиснуть» восемь процессоров AMD Epyc 4 Genoa мощностью 400 Вт в 19-дюймовый корпус.

Сервер Lenovo Neptune с жидкостным охлаждением, оснащенный двумя процессорами AMD Genoa и четырьмя графическими процессорами Nvidia H100.

Тем временем Lenovo продемонстрировала систему Neptune высотой 1U, предназначенную для охлаждения пары 96-ядерных процессоров Epyc и четырех графических процессоров Nvidia H100 SXM. Lenovo и прочие производители утверждают, что их системы с прямоконтактным жидкостным охлаждением, в зависимости от реализации, могут удалять от 80 до 97 процентов тепла, выделяемого сервером.

Иммерсионное охлаждение

Одной из наиболее экзотических технологий оптимизации температурного режима серверного оборудования, представленных на выставке SC22, было иммерсионное охлаждение, ставшее за последние несколько лет крайне популярным в медийной сфере. Подобные устройства способны удалять практически 100 процентов излишков тепла, выделяемого системой.

Вместо того, чтобы модернизировать сервер, дополняя конструкцию охлаждающими пластинами, создатели резервуаров для иммерсионного охлаждения вроде представленного на фото выше продукта Submer, погружают их в непроводящую жидкость.

Справедливости ради следует отметить, что данная технология существует уже давно. Инженеры десятилетиями погружали компьютерные компоненты в непроводящие жидкости, чтобы они не перегревались. Одной из самых известных систем с иммерсионным охлаждением был суперкомпьютер Cray 2.

Хотя жидкости, используемые в этих системах, варьируются от поставщика к поставщику, синтетические масла от Exxon или Castrol или специализированные хладагенты от 3M являются наиболее распространенными вариантами.

Submer была одной из нескольких компаний, занимающихся иммерсионным охлаждением, которые продемонстрировали свои технологии на SC22. Резервуары SmartPod производства данной компании выглядят так, как если бы вы наполнили горизонтальную морозильную камеру из магазина (морозильный ларь) минеральным маслом и начали вертикально вставлять серверы сверху.

Submer предлагает резервуары разных размеров, которые примерно эквивалентны традиционным половинным и полноразмерным стойкам. Эти резервуары рассчитаны на тепловыделение 50-100 кВт, что ставит их на один уровень с монтируемой в стойку инфраструктурой воздушного и жидкостного охлаждения с точки зрения удельной мощности.

Резервуар Submer поддерживает форм-фактор OCP OpenRack, с использованием которого изготовлены эти блейд-системы на базе Intel Xeon.

В демонстрационном резервуаре было установлено три 21-дюймовых сервера, каждый из которых комплектовался тремя двухпроцессорными блейдами на базе процессоров Sapphire Rapids от Intel. В качестве демонстрационного образца инженеры также использовали стандартную систему AMD высотой 2U, которая была преобразована для использования в иммерсионных резервуарах.

Представители вендора отметили, что количество требуемых модификаций, особенно в случае использования решений на базе спецификаций OCP, довольно незначительно. Единственным значимым изменением является демонтаж любых движущихся частей из таких элементов вычислительного узла как блок питания, обычная версия которого комплектуется вентилятором / вентиляторами.

Как и следовало ожидать, иммерсионное охлаждение усложняет техническое обслуживание. Кроме того, данная технология немного «грязнее», чем воздушное или прямоконтактное жидкостное охлаждение.

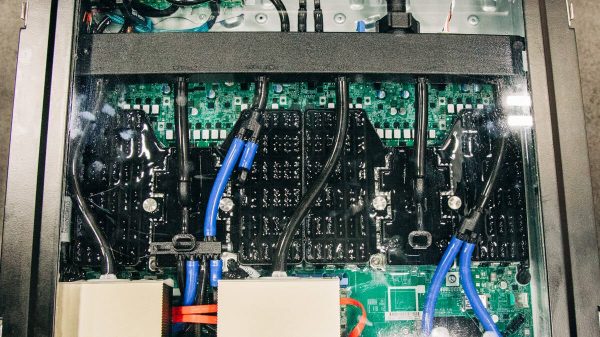

Корпус сервера Iceotope с иммерсионным охлаждением

Не каждой установке для иммерсионного охлаждения в выставочном зале требовалась специализированная жидкость в большом количестве. Одним из примеров экономичного подхода стала система иммерсионного охлаждения Iceotope, встроенная в серверный корпус. Герметичный серверный корпус компании функционирует как резервуар, где в диэлектрическую жидкость погружена только материнская плата с наиболее горячими компонентами.

Резервный насос в задней части сервера обеспечивает рециркуляцию хладагента рядом с «горячими точками», включая центральный и графический процессоры, а также оперативную память, а затем пропускает нагревшуюся жидкость через теплообменник, сообщающийся с внешним контуром. Оттуда излишки тепла передаются в систему водоснабжения объекта или в стоечные узлы распределения охлаждающей жидкости / CDU.

Вспомогательная инфраструктура

Будь то прямоконтактное или иммерсионное охлаждение — независимо от типа используемого подхода к удалению излишков тепла, также требуется и дополнительная инфраструктура. Так, в случае установок с прямоконтактным жидкостным охлаждением это могут быть распределительные коллекторы, трубопроводы на уровне стойки и, что наиболее важно, один или несколько блоков распределения хладагента.

Крупные блоки распределения хладагента размером с целую серверную стойку стандартного формата, как показывает практика, вполне могут быть использованы для охлаждения целого ряда полноценных монтажных стоек c IT-оборудованием. Например, компания Cooltera продемонстрировала несколько больших CDU, способных обеспечить до 600 кВт охлаждения для нужд центра обработки данных.

В случае развертывания небольших массивов вычислительных узлов можно использовать монтируемый в стойку узел CDU. Ниже представлены фото пары подобных устройств производства Cooltera, которые обеспечивают мощность охлаждения от 80 до 100 кВт.

Блок распределения охлаждающей жидкости, предназначенный для монтажа в стойку от Cooltera.

Блоки CDU состоят из трех основных компонентов: теплообменника, резервных насосов для обеспечения циркуляции охлаждающей жидкости по стойкам и системы фильтрации, предотвращающей засорение критически важных компонентов, таких как микроребра внутри охлаждающей пластины, твердыми частицами.

Способ фактического удаления излишков тепла из контура системы охлаждения, сильно зависит от типа используемого теплообменника. Теплообменники типа жидкость-воздух являются одними из самых простых, поскольку требуют наименьшего количества модификаций самой установки. Запечатленный на фото ниже узел CDU от Cooltera использует большие радиаторы для удаления тепла, полученного жидкостью, с последующим перенаправлением в «горячий коридор» внутри центра обработки данных.

Узел CDU от Cooltera со встроенным жидкостно-воздушным теплообменником, дополняющим насосы и фильтры

Однако в большинстве CDU, которые были представлены на SC22, использовались теплообменники типа «жидкость-жидкость». Идея здесь состоит в том, чтобы использовать отдельную систему трубопроводов на уровне всего ЦОД для перемещения тепла, собранного несколькими CDU, в сухие градирни снаружи здания, где оно рассеивается в воздухе.

Или вместо того, чтобы перемещать излишки тепла в атмосферу, некоторые центры обработки данных, включая недавно введенный в эксплуатацию ЦОД корпорации Microsoft в финской столице Хельсинки, подключают собственные трубопроводы, используемые для организации циркуляции хладагента, к внешним системам горячего водоснабжения / централизованного теплоснабжения, помогая соседям снижать цифры на счетах за коммунальные услуги.

Ситуация во многом аналогична иммерсионному охлаждению, хотя многие компоненты CDU, включая насосы, жидкостно-жидкостные теплообменники и системы фильтрации, встроены в резервуары. Требуется лишь их подключение к трубопроводной системе на уровне ЦОД.

Распространение жидкостного охлаждения растет

Сегодня на долю жидкостного охлаждения приходится лишь небольшая часть систем управления температурным режимом, фактически используемых в корпоративных и коммерческих центрах обработки данных по всему миру. Но переход на все более горячие компоненты серверов и повышение плотности мощности комплектующих в среднестатистической стойке начинают стимулировать более активное внедрение этой технологии.

Согласно недавнему отчету от консалтинговой компании Dell’Oro Group, ожидается, что по итогам 2026 года расходы на оборудование для жидкостного и иммерсионного охлаждения существенно вырастут и достигнут 1,1 миллиарда долларов (или 19 процентов от расходов на управление температурным режимом в ЦОД по всему миру).

Стремительный рост цен на энергоносители и повышенный акцент на экологичность также делают жидкостное и иммерсионное охлаждение все более привлекательными в глазах операторов и владельцев ЦОД.

Всего комментариев: 0