Серверная ферма Facebook близ Полярного круга меняет парадигму ЦОД

Из года в год крупные производители вычислительной техники вроде Hewlett-Packard, Dell и Cisco Systems продают “железо” стоимостью более $ 100 млрд. Речь главным образом о серверах, системах хранения данных и сетевых решениях. В список покупок клиентов этих вендоров также можно добавить специализированные системы безопасности, системы анализа данных, а также соответствующее программное обеспечение, после чего вышеозначенная цифра станет гораздо больше. Обычному обывателю подобные суммы сложно представить. И именно поэтому можно понять обеспокоенность перечисленных выше компаний инициативами Facebook: соцсеть регулярно публикует в открытом доступе проекты передового энергоэффективного аппаратного обеспечения и вспомогательного оборудования для ЦОД. Бесплатно. Это несет непосредственную угрозу бизнесу Hewlett-Packard, Dell, Cisco и многих других вендоров из “высшей лиги”.

Из года в год крупные производители вычислительной техники вроде Hewlett-Packard, Dell и Cisco Systems продают “железо” стоимостью более $ 100 млрд. Речь главным образом о серверах, системах хранения данных и сетевых решениях. В список покупок клиентов этих вендоров также можно добавить специализированные системы безопасности, системы анализа данных, а также соответствующее программное обеспечение, после чего вышеозначенная цифра станет гораздо больше. Обычному обывателю подобные суммы сложно представить. И именно поэтому можно понять обеспокоенность перечисленных выше компаний инициативами Facebook: соцсеть регулярно публикует в открытом доступе проекты передового энергоэффективного аппаратного обеспечения и вспомогательного оборудования для ЦОД. Бесплатно. Это несет непосредственную угрозу бизнесу Hewlett-Packard, Dell, Cisco и многих других вендоров из “высшей лиги”.

Компании Dell и НР и иже с ними существуют, чтобы продавать “железо” корпоративным клиентам и настраивать его. Решение Facebook относительно публикации информации по своим наработкам в области оптимизации конструкций элементов инфраструктуры ЦОД может заставить этих самых клиентов всерьез задуматься о целесообразности апгрейда IT- и вспомогательного оборудования внутри своих дата-центров в обход крупных вендоров из США. Ведь никто не запрещает воспользоваться выложенным в открытый доступ проектом и относительно дешевыми услугами подрядчиков из Азии.

Именно так и поступает сама соцсеть Facebook: вместо того чтобы покупать серверные стойки у все тех же крупных вендоров, компания разрабатывает свои собственные решения и отдает их сборку на откуп аутсорсерам из Азии. В апреле 2011 года социальная сеть начала публиковать чертежи своего аппаратного обеспечения в рамках своей инициативы Open Compute Project (OCP). Теперь данная инициатива оказалась в самом центре крупнейшего сдвига парадигмы в индустрии ЦОД за последнее десятилетие.

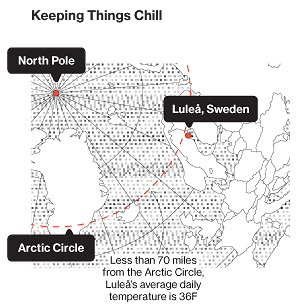

Центральным элементом эксперимента Facebook является серверная ферма, расположенная чуть южнее Полярного круга. Компания открыла свой новый гипермасштабный дата-центр посреди леса на окраине шведского городка Лулео еще в июне прошлого года. Фасад гигантского здания обрамляют тысячи прямоугольных металлических панелей, при этом само оно выглядит как заправский космический корабль. Это один из самых энергоэффективных вычислительных объектов в человеческой истории. Шведский колосс помогает Facebook обрабатывать 350 миллионов фотографий, 4.5 млрд. «лайков» и 10 млрд. сообщений в день. Примечательно, что в то время как в обычном дата-центре на каждый ватт IT-нагрузки приходятся полтора-два ватта электромеханического оборудования и систем охлаждения, ЦОД Лулео работает в разы эффективнее: его коэффициент PUE равен 1.04.

Центральным элементом эксперимента Facebook является серверная ферма, расположенная чуть южнее Полярного круга. Компания открыла свой новый гипермасштабный дата-центр посреди леса на окраине шведского городка Лулео еще в июне прошлого года. Фасад гигантского здания обрамляют тысячи прямоугольных металлических панелей, при этом само оно выглядит как заправский космический корабль. Это один из самых энергоэффективных вычислительных объектов в человеческой истории. Шведский колосс помогает Facebook обрабатывать 350 миллионов фотографий, 4.5 млрд. «лайков» и 10 млрд. сообщений в день. Примечательно, что в то время как в обычном дата-центре на каждый ватт IT-нагрузки приходятся полтора-два ватта электромеханического оборудования и систем охлаждения, ЦОД Лулео работает в разы эффективнее: его коэффициент PUE равен 1.04.

Эффективность и экологичность ЦОД во многом обусловлена его расположением. Операторам шведских дата-центров доступна дешевая электроэнергия, генерируемая надежными гидроэлектростанциями, а также холодный климат, который IT-специалисты могут обернуть в свою пользу. Вместо того чтобы полагаться на огромные энергозатратные кондиционеры для охлаждения десятков тысяч серверов в Лулео инженеры Facebook позволяют наружному воздуху попадать внутрь здания и охлаждать серверные системы (в машзалы ЦОД суровый шведский воздух попадает лишь после фильтрации, а также оптимизации температуры и влажности). В отличие от обычных дата-центров, которые напоминают склады, новая серверная ферма соцсети функционирует как один большой механизм.

Чтобы упростить конструкцию своих серверов, инженеры Facebook отказались от использования ряда стандартных компонентов, таких как дополнительные слоты памяти, кабели и защитные пластиковые корпуса. Эти серверы с ни чем не защищенными материнскими платами размещаются внутри стандартной монтажной стойки размером с холодильник. Инженеры говорят, что подобная конструкция позволяет интенсифицировать воздушные потоки, проходящие через каждый сервер. Кроме того, для эффективной работы подобных вычислительных систем требуется меньшая холодопроизводительность: благодаря сократившемуся количеству компонентов они выделяют меньше тепловой энергии, чем стандартные аналоги. Кроме того, машины Facebook способны функционировать при повышенных температурах.

Когда инженеры Facebook начали делиться своими идеями с общественностью, большинство экспертов в области ЦОД были настроены скорее скептически – особенно касательно эксплуатации серверных систем при повышенных температурах. Тем не менее, время расставило все на свои места. При этом дальнейшее улучшение инфраструктурных систем участниками инициативы Open Compute Project (помимо Facebook проект развивают многие производители аппаратного обеспечения и микрочипов, хостинг- и колокейшн-провайдеры, а также далекие от IT-сегмента банковские организации) позволило использовать их и вдалеке от заполярья. Так, следующий крупный дата-центр соцсети будет построен в штате Айова (США), который характеризуется умеренным климатом. Как и в Швеции там более чем достаточно дешевой электроэнергии из возобновляемых источников (в Айове роль гидроэлектростанций выполняют ветряные фермы). Компания также начала разработку своих собственных систем хранения данных и сетевого оборудования.

HP оперативно отреагировала на инициативу соцсети, начав продажи микросервера под названием Moonshot, который лишен всего лишнего, комплектуется маломощными чипами и характеризуется высокой энергоэффективностью. По мнению экспертов, релиз Moonshot является наиболее радикальным изменением линейки продуктов для ЦОД, предпринятых американской компанией за последние годы. HP также работает над механизмами повышения энергоэффективности серверов за счет водяного охлаждения. Примечательно, что топ-менеджеры компании вполне открыто заявляют, что главным стимулом довести проект Moonshot до конца стала популярность разрабатываемого Facebook сотоварищи аппаратного обеспечения. «Я думаю, что инициатива Open Compute Project заставила нас стать лучше», говорит вице-президент HP Пол Сантелер. «Инженеры Facebook добились огромных успехов, но я думаю, что мы отреагировали довольно быстро».

С другой стороны, Cisco преуменьшает угрозу, исходящую от Open Compute Project. По мнению руководства сетевого гиганта, лишь немногие компании захотят иметь дело со столь специализированными системами, которые были разработаны в первую очередь для удовлетворения потребностей крупных интернет-компаний, владеющих гипермасштабными ЦОД. По словам пресс-секретаря Cisco Дэвида Маккалока, сетевой гигант не рассматривает новый тренд как угрозу для своего бизнеса. Но не следует забывать о том, что еще шесть лет назад еще один крупный американский вендор Dell создал специальную команду инженеров, чтобы те разрабатывали вычислительные системы без «излишеств», которые приобретались интернет-компаниями. С тех пор доход Dell значительно вырос. Это говорит о том, что вендор избрал правильно направление развития своего бизнеса.

С другой стороны, Cisco преуменьшает угрозу, исходящую от Open Compute Project. По мнению руководства сетевого гиганта, лишь немногие компании захотят иметь дело со столь специализированными системами, которые были разработаны в первую очередь для удовлетворения потребностей крупных интернет-компаний, владеющих гипермасштабными ЦОД. По словам пресс-секретаря Cisco Дэвида Маккалока, сетевой гигант не рассматривает новый тренд как угрозу для своего бизнеса. Но не следует забывать о том, что еще шесть лет назад еще один крупный американский вендор Dell создал специальную команду инженеров, чтобы те разрабатывали вычислительные системы без «излишеств», которые приобретались интернет-компаниями. С тех пор доход Dell значительно вырос. Это говорит о том, что вендор избрал правильно направление развития своего бизнеса.

Специализированное аппаратное обеспечение, разработанное в стенах веб-гигантов Google и Amazon, доступно лишь операторам ЦОД этих компаний. Но открытость Facebook и желание соцсети делиться своими наработками стали причинами роста интереса в адрес ее дата-центров не только со стороны других интернет-компаний – наработками соцсети в области повышения эффективности ЦОД активно интересуются даже субъекты малого и среднего бизнеса. Facebook создала пошаговую инструкцию по созданию гипермасштабного дата-центра, воспользоваться которой может любая компания, обладающая достаточным количеством человеко-часов и денег.

Примечательно, что в состав совета директоров некоммерческой организации Open Compute Project Foundation, возглавляемого топ-менеджер Facebook Фрэнком Франковскии, уже вошли руководители таких грандов от мира высоких технологий и финансов как Intel и Goldman Sachs, соответственно. При этом многие крупные азиатские производители аппаратного обеспечения вроде Quanta Computer и Tyan Computer уже начали продавать серверные системы на основе спецификаций, созданных участниками Open Compute Project. Все это говорит о том, что инициатива соцсети оказалась действительно популярной.

По мнению специалистов, в среднесрочной перспективе дата-центры масштаба серверной фермы Facebook в Лулео, стоимость возведения которой может достигать целых $ 300 миллионов, будут появляться с завидной популярностью. При этом компании любого размера смогут воспользоваться все более дешевым и более энергоэффективным оборудованием, разрабатываемым попутно этим гипермасштабным ЦОД. Нечто подобное происходило 100 лет назад в автомобилестроении: в тот раз появление конвейерных сборочных линий произвело настоящую революцию в промышленном производстве.

Всего комментариев: 0