Фотоэкскурсия по дата-центру AMD близ Атланты

Американский чипмейкер Advanced Micro Devices в 2012 году занялся консолидацией своих центров обработки данных. Производитель микроэлектроники стремился сократить количество своих ЦОД по всему миру с восемнадцати до двух: один из новых ЦОД должен был разместиться в Малайзии, другой – в городе Сувани (пригород Атланты, штат Джорджия (США)).

Американский чипмейкер Advanced Micro Devices в 2012 году занялся консолидацией своих центров обработки данных. Производитель микроэлектроники стремился сократить количество своих ЦОД по всему миру с восемнадцати до двух: один из новых ЦОД должен был разместиться в Малайзии, другой – в городе Сувани (пригород Атланты, штат Джорджия (США)).

Проект стартовал в конце позапрошлого года. Компания решила в первую очередь заняться консолидацией всех своих североамериканских дата-центров, расположенных в Остине, штат Техас (США), Саннивейле, штат Калифорния (США), и Онтарио (Канада). Все вычислительные нагрузки должны были быть перемещены в ЦОД площадью 14.2 тыс. квадратных метров в Сувани. Руководство американской компании надеется завершить этот процесс к середине 2015 года. AMD уже переместила свое оборудования из ЦОД в Остин в новое здание, после чего ее техасский кампус был продан.

Относительно дешевая электроэнергия и налоговые льготы в Джорджии позволят AMD экономить около $ 8.5 миллионов в год. Но в число целей проекта входили не только экономия денег и возведение более современных и энергоэффективных дата-центров – чипмейкер также хотел создать площадку для демонстрации своих собственных технологий текущим и перспективным партнерам и клиентам.

На фото выше запечатлены топ-менеджеры Advanced Micro Devices, которые отвечают за реализацию проекта по консолидации дата-центров: вице-президент по глобальной вычислительной инфраструктуре и операционной деятельности Энди Бинум (слева) и вице-президент по информационным технологиям Джейк Доминкес (Справа).

Так выглядит вход в новый дата-центр AMD. Снаружи этот ЦОД ничем не выделяется. Объект не отличается от других близлежащих зданий. Тем не менее, после того, как в следующем году дата-центр будет полностью укомплектован северным, сетевым и вспомогательным оборудованием, он станет плацдармом для обеспечения работоспособности всех технологических и бизнес-процессов AMD на североамериканском континенте.

Оператор дата-центра AMD в Джорджии, специалист по управлению критически важным оборудованием и мониторингу окружающей среды Лемар Вашингтон рассказывает об используемой на объекте системе управления зданием (Building Management System; BMS), которая позволяет операторам ЦОД отслеживать все, что происходит в здании дата-центра: от состояния серверов до количества используемой электроэнергии. AMD наняла 21 специалиста, что те поддерживали работоспособность этой серверной фермы.

В одном из помещений дата-центра производится подготовка систем к началу эксплуатации: инженеры тестируют оборудование, после чего оно устанавливается в монтажные стойки, размещенные в машзалах ЦОД. Эти башенные серверы поступили из разукомплектованного дата-центра AMD в Остине.

Дата-центр в Сувани проектировался и строится по модульному принципу. Объект имеет 10 машзалов. В настоящее время два из них уже укомплектованы оборудованием и исправно эксплуатируются (включая запечатленный на фото выше машзал под названием Diamond Data Hall). Каждый машзал имеет площадь около 150 квадратных метров. Находящиеся в них монтажные стойки наполнены серверами от Hewlett-Packard и Dell, а также машинами собственной разработки AMD (серверы производит подразделение чипмейкера под названием ServerMicro).

Эти серверы HP, размещенные в машзале Citrine Data Hall, используются AMD для запуска бизнес-приложений и ПО для технических расчетов. Два машзала служат домом для 204 стоек с серверным оборудованием. За счет виртуализации более чем 90 процентов своих серверов компания AMD смогла вывести из эксплуатации 76 процентов физических систем, используемых в Остине. Чипмейкеру также удалось высвободить около 45 процентов внутристоечного пространства.

По словам Лемара Вашингтона, для достижения высокого уровня энергоэффективности дата-центра необходима хорошая изоляция воздуховодов. На фото выше вы можете увидеть систему изоляции «горячих» коридоров между монтажными стойками AMD. Пластиковые шторы на входе в коридоры используются, чтобы удерживать горячий воздух внутри них.

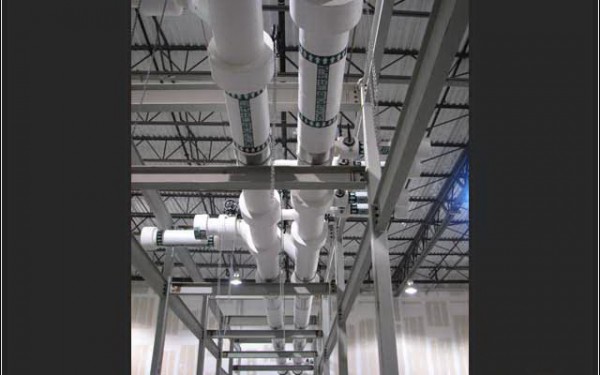

Холодный воздух подается через фальшпол в «холодные» коридоры, после чего он поступает в передние части монтажных стоек и используется для охлаждения IT-оборудования. Горячий воздух выходит из задней части стоек и попадает в «горячие» коридоры. Затем он попадает в воздуховоды на потолке и в системы кондиционирования, где снова охлаждается и отправленных обратно в машзал дата-центра. В каждом машзале этого дата-центра работает по девять систем кондиционирования воздуха.

Рядом с каждым машзалом есть помещение, где находятся дизельные электрогенераторы (ДГУ), которые обеспечивают работоспособность IT-систем в случае неполадок в центральной электросети. Там же находятся системы резервных источников бесперебойного питания (ИБП), которые берут на себя всю нагрузку в период между отключением подачи тока из центральной электросети и началом работы ДГУ.

AMD использует эту комнату для хранения картриджей с магнитной лентой, каждый из которых способен вместить до 1600 гигабит пользовательских данных.

Машзалы Diamond и Citrine вскоре будут дополнены еще 8 помещениями для размещения IT-оборудования. По словам руководителей AMD, помещение, которое показано выше, вскоре превратится в целых шесть отдельных машзалов.

Внутри этого помещения будут размещены два других машзала ЦОД.

Инженеры AMD начали готовить эту часть дата-центра к возведению нового машзала, установив в нем трубопровод для холодной воды, которая поможет сохранить температуру серверного оборудования на нужном уровне.

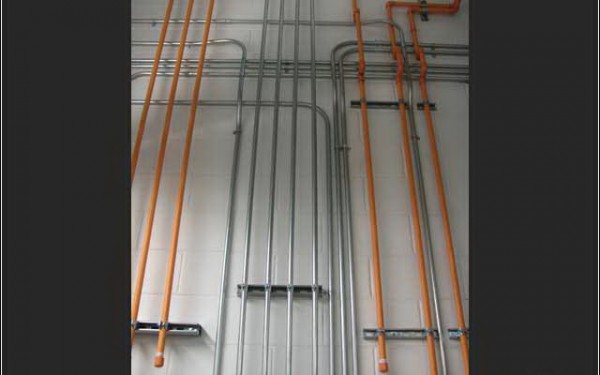

Учитывая тот факт, что новый ЦОД расположен в южной части североамериканского континента, инженеры AMD отказались от идеи использовать наружный воздух для охлаждения серверов (фрикулинг) слишком часто. Тем не менее, бывают случаи, когда снаружи становится достаточно холодно, чтобы активировать механизм фрикулинга. Оранжевые трубы, запечатленные выше, помогают использовать воздух извне для охлаждения серверного оборудования.

В дата-центре AMD имеется система, которая анализирует циркулирующий в помещениях ЦОД воздух на предмет наличия дыма или других индикаторов потенциально опасных ситуаций. Оранжевые трубы на фото выше используются для нагнетания «проб» воздуха в эту систему.

Трубы в этой части объекта используются для распределения холодной воды по всему дата-центру. Система обрабатывает 2.8 тыс. литров (752 галлонов) воды каждую минуту. Цепи с зелеными бирками позволяют операторам ЦОД изолировать отдельные клапаны при необходимости.

Если возникнут проблемы с подачей воды и системы центрального водоснабжения, операторы дата-центра могут использовать H2O из этого резервуара, способного вместить до 227.1 тыс. литров (60 000 галлонов) жидкости. По словам Вашингтона, этого количества воды будет достаточно, чтобы ЦОД проработал около 36 минут.

Всего комментариев: 0