Google использует нейронные сети для снижения PUE своих дата-центров

В настоящее время корпорация Google обрабатывает около 4 миллионов поисковых запросов ежеминутно, что требует значительных энергозатрат. Дабы уменьшить цифры на своих счетах за электричество, поисковый гигант начал использовать искусственный интеллект для повышения энергоэффективности своих дата-центров по всему миру. Высокотехнологичная компания из США применила искусственные нейронные сети, чтобы узнать, как тратить меньше электроэнергии на обеспечение работоспособности вычислительной инфраструктуры, которая лежит в основе ее онлайн-сервисов.

В настоящее время корпорация Google обрабатывает около 4 миллионов поисковых запросов ежеминутно, что требует значительных энергозатрат. Дабы уменьшить цифры на своих счетах за электричество, поисковый гигант начал использовать искусственный интеллект для повышения энергоэффективности своих дата-центров по всему миру. Высокотехнологичная компания из США применила искусственные нейронные сети, чтобы узнать, как тратить меньше электроэнергии на обеспечение работоспособности вычислительной инфраструктуры, которая лежит в основе ее онлайн-сервисов.

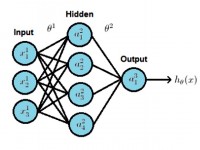

Отметим, что искусственные нейронные сети, создаваемые с использованием алгоритмов машинного обучения и предназначенные для имитации различных аспектов функционирования нашего с вами серого вещества (в частности, взаимодействия между нейронами), уже довольно давно и плодотворно используются Google и рядом других компаний для решения определенных задач. Так, поисковый гигант применяет их для формирования рекомендаций своим клиентам с учетом их прошлых заказов. Данная технология также применяется среди прочего для распознавания речи и изображений.

Трехуровневая искусственная нейронная сеть. Изображение: Google

«Применение алгоритмов машинного обучения для обработки существующих данных, получаемых при мониторинге IT- и вспомогательной инфраструктуры серверной фермы, дает возможность добиться значительного улучшения эффективности работы ЦОД. […] Тысячи датчиков внутри типичного гипермасштабного ЦОД генерируют огромное множество данных каждый день. В настоящее время эти данные довольно редко используются для решения задач, отличных от мониторинга различных элементов инфраструктуры дата-центра. Достижения в области повышения вычислительной мощности и улучшение функциональных возможностей систем мониторинга создают большие возможности для применения агрегируемой информации при машинном обучении с целью повышения эффективности ЦОД «, отметил инженер-механик Google и специалист по анализу данных Джим Гао в статье, посвященной рассматриваемому проекту. К слову, коллеги по американской корпорации дали Гао прозвище «Boy Genius», что намекает на недюжинные интеллектуальные способности этого специалиста.

Все ради минимизации PUE

Сообщается, что идея использовать искусственные нейронные сети для решения подобной задачи первоначально возникла у вице-президента Google по развитию инфраструктуры ЦОД Джо Кава, который в свое время активно углублял знания в области ИИ и машинного обучения в Стэнфордском университете. Мотивация проста – дальнейшая минимизация коэффициента эффективности использования энергии (Power Usage Effectiveness; PUE).

Напомним, что коэффициент PUE показывает соотношение количества электроэнергии, идущей на запитку всей инфраструктуры ЦОД (включая систему охлаждения и распределения электричества), к количеству электричества, расходуемого исключительно IT-оборудованием.

В последние годы крупные интернет-компании вроде Facebook и Google смогли вплотную приблизиться к идеальному PUE на уровне 1.0, используя такие методы, как изоляция воздуховодов, экономизация со стороны охлажденной воды / воздуха, а также расширенный мониторинг IT- и вспомогательной инфраструктуры.

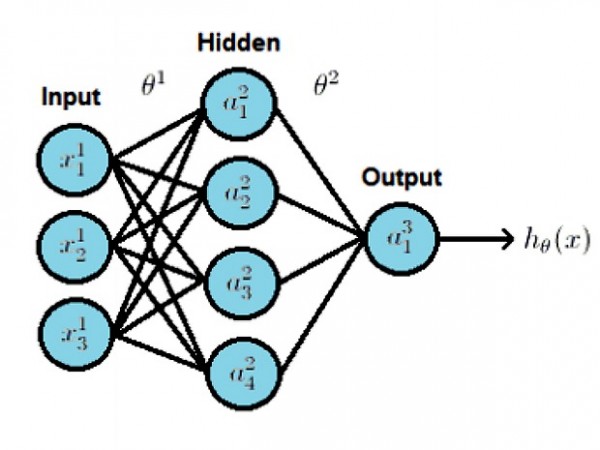

Но не так давно выяснилось, что при приближении к нулевому PUE отдача от инвестиций в повышение энергоэффективности ЦОД снижается. Представленный ниже график весьма наглядно это демонстрирует. На графике показана динамика коэффициента эффективности использования энергии в дата-центрах Google в разрезе последних пяти лет (рассматриваемый показатель снизился с 1.21 в 2008 году до 1.12 в 2013 году).

Изображение: Google

Эксперты Google утверждают, что активная работа с искусственными нейронными сетями позволит поисковому гиганту рационализировать расходование инвестиций на повышение энергоэффективности ЦОД и шагнуть в эру PUE < 1.10.

Почему именно искусственные нейронные сети?

Объем данных, генерируемых массивами механического и электроэнергетического оборудования внутри мощных дата-центров, а также сложные корреляции между подобными устройствами, затрудняют использование обычных инженерных формул для прогнозирования энергоэффективности дата-центра.

В статье Google приводится пример того, как незначительные изменения в пределах ЦОД могут инициировать каскадный эффект, который затронет все связные системы:

«Простое изменение «холодного» коридора (регулировка заданного значения температуры) способно увеличить нагрузку на охлаждающую инфраструктуру (чиллеры, градирни, теплообменники, компрессоры т.д.). Это, в свою очередь, вызывает нелинейные изменения производительности оборудования. […] При использовании стандартных формул для прогнозного моделирования зачастую возникают крупные ошибки, потому что такие формулы не позволяют охватить весь спектр сложных взаимозависимостей. […] Огромное количество комбинаций оборудования и параметров эксплуатации устройств усложняет процесс определение модели использования, которая будет предполагать оптимальный уровень эффективности».

Как отмечают специалисты Google, искусственные нейронные сети идеально подходят для создания моделей, которые позволяют с легкостью прогнозировать различные исходы сложных взаимодействий физических систем внутри дата-центра. Все потому, что они могут вести поиск паттернов в массивах данных и корреляциях между системами, не требуя предварительного определения этих бесчисленных корреляций.

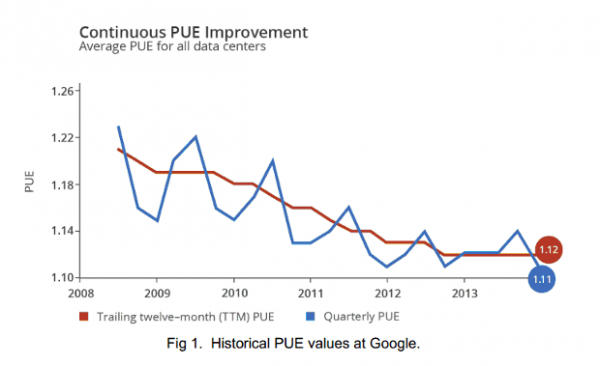

Изображение: Google

Эти модели могут использоваться для точного прогнозирования PUE дата-центра(ов) и для автоматического определения проблем возникающих, если ЦОД слишком сильно отклоняется от прогнозной модели. Данная концепция позволяет выявить возможности для дальнейшего энергосбережения и протестировать новые конфигурации для повышения эффективности дата-центра.

«Наши механизмы моделирования позволяют операторам создать виртуальную модель ЦОД с целью выявления оптимальных конфигураций оборудования при одновременном снижении неопределенности, связанной с возможными изменениями», отмечается в статье поискового гиганта.

Многофакторная модель

Массив данных, используемых искусственными нейронными сетями при предиктивном моделировании PUE в рамках созданного поисковым гигантом алгоритма, включает в себя 19 различных переменных, полный перечень которых приведен в таблице ниже.

| 1 | Общая IT-нагрузка на серверы [кВт] |

| 2 | Общая IT-нагрузка на сетевое оборудование [кВт] |

| 3 | Общее количество работающих насосов в системе обработки воды (Process Water Pump; PWP) |

| 4 | Средняя частота вращения электропривода с частотным регулированием (Variable Frequency Drive; VFD) в PWP [%] |

| 5 | Общее количество работающих насосов конденсаторной воды (Condenser Water Pump; CWP) |

| 6 | Средняя частота вращения VFD в CWP [%] |

| 7 | Общее количество работающих градирен |

| 8 | Средняя температура воды на выходе из градирен (Leaving Water Temperature; LWT) [в градусах по Фаренгейту] |

| 9 | Общее количество работающих чиллеров |

| 10 | Общее количество работающих сухих (поверхностных) воздухоохладителей |

| 11 | Общее количество работающих нагнетательных насосов для впрыска охлажденной воды |

| 12 | Среднее заданная температура воды в нагнетательных насосах для впрыска охлажденной воды [в градусах по Фаренгейту] |

| 13 | Средний перепад температуры на концах теплообменника [в градусах по Фаренгейту] |

| 14 | Температура наружного воздуха по влажному термометру (Wet Bulb; WB) [в градусах по Фаренгейту] |

| 15 | Температура наружного воздуха по сухому термометру (Dry Bulb; DB) [в градусах по Фаренгейту] |

| 16 | Энтальпия наружного воздуха (кДж / кг) |

| 17 | Относительная влажность наружного воздуха (Relative Humidity; RH) [%] |

| 18 | Скорость ветра за пределами здания [миль / ч] |

| 19 | Направление ветра за пределами здания [град] |

Пилотный проект осуществляется в дата-центре Google, который находится в Даллесе, штат Орегон (США). Фактический PUE рассчитывается каждые 30 секунд, после чего полученные результаты сравниваются с прогнозными.

Реальная польза

Следует отметить, что в документе, который был подготовлен Гао сотоварищи, также присутствует пример того, как Google использует эти прогнозные модели при определении возможностей для оптимизации инфраструктуры и минимизации PUE: «Например, внутренний анализ динамики PUE в зависимости от температуры внутри «холодных» коридоров, проведенный в одном из наших ЦОД, позволил найти возможность для теоретического сокращения коэффициента PUE на 0.005, увеличивая температуру подаваемой из градирен воды на 3 градуса по Фаренгейту. Эта симуляция снижения PUE впоследствии была проверена путем изучения результатов тестов, проводимых с применением реального оборудования «.

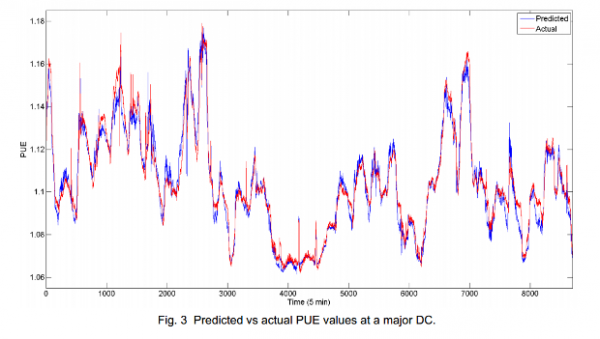

Как отмечают специалисты Google, искусственные нейронные сети помогли им с высокой степенью точности предсказывать PUE одного из основных дата-центр корпорации на протяжении одного месяца, демонстрируя среднюю абсолютную частоту ошибок на уровне всего в 0.004 при стандартном отклонении на уровне 0.005. Иными словами, созданный поисковым гигантом программно-аппаратный комплект для анализа данных, способен с 99.6-процентной точностью предсказать, насколько эффективно ЦОД потребляет электроэнергию.

Изображение: Google

«Реальное тестирование в ЦОД Google показывает, что машинное обучение является эффективным методом использования поступающих с сенсоров данных для моделирования энергоэффективности дата-центров, позволяя добиться значительной экономии средств «, резюмируют авторы статьи.

Данная инициатива уже приносит реальные плоды. Как отметил Джо Кава, пару месяцев назад операторам одного из ЦОД американской корпорации пришлось отключить часть серверных систем на несколько дней. Подобная операция, как правило, делает дата-центр менее энергоэффективным ввиду роста PUE. Тем не менее, используя модель Гао, операторы ЦОД смогли временно модифицировать настройки системы охлаждения, уменьшив негативное воздействие вышеназванной операции на динамику PUE в разрезе рассматриваемого периода времени (тех самых нескольких дней). Небольшие хитрости вроде этой, в конечном итоге, оборачиваются значительной экономией как электроэнергии, так и денег.

Старая сказка на новый лад

Хотя корпорация Google и закрепила за собой звание пионера в области использования искусственных нейронных сетей для оптимизации физической инфраструктуры ЦОД, эта концепция появилась уже давно. Искусственные нейронные сети в той или иной форме существовали примерно с 1960 года, при этом разработка Google переняла многое у системы под названием Машина Больцмана, которая была создана в 80-х годах прошлого века.

Примечательно также, что один из признанных авторитетов в области разработки ИИ Джефф Хокинс создал более сложную систему, которая уже легла в основу коммерческого продукта под названием Grok. Последний способен осуществлять мониторинг нагрузки на серверы и прогнозировать данный показатель с использованием ИИ, принцип действия которого схож с нашим мозгом.

Всего комментариев: 0