Дата-центры Facebook по всему миру в цифрах и фотографиях

Социальная сеть Facebook, количество активных пользователей которой перевалило за 1.3 млрд. и продолжает расти, уделяет внимание не только совершенствованию качества своих сервисов, но и повышению эффективности, а также постоянному расширению вычислительной инфраструктуры, которая стоит за этими сервисами.

Социальная сеть Facebook, количество активных пользователей которой перевалило за 1.3 млрд. и продолжает расти, уделяет внимание не только совершенствованию качества своих сервисов, но и повышению эффективности, а также постоянному расширению вычислительной инфраструктуры, которая стоит за этими сервисами.

В то время как Google, Microsoft и Amazon в течение последних нескольких лет активно возводили новые серверные фермы для обслуживания облачных платформ, Facebook строила свои дата-центры ради агрегации огромного объема генерируемого ее пользователями медиа-контента.

При этом компания, чей головной офис находится в городе Менло-Парк, штат Калифорния (США), уделяла повышенное внимание развитию открытых платформ и архитектур, видя в них источник идей для дальнейшей максимизации энергоэффективности ЦОД.

Мы постарались собрать наиболее актуальные данные по энергосбережению в ее дата-центрах по всему миру, добавив в получившийся отчет фотографии соответствующих серверных ферм.

Facebook: Прайнвилл, штат Орегон (США)

Согласно официальным данным Facebook, за последние три года компания сэкономила более $ 1,2 млрд за счет полной оптимизации своих дата-центров: аппаратного обеспечения и программного обеспечения, а также вспомогательной инфраструктуры.

На фото выше представлен флагманский дата-центр Facebook в городе Прайнвилл, штат Орегон (США). Внутри этого ЦОД было проложено 1.5 тыс. километров телекоммуникационных проводов и силовых кабелей. Это в полтора раза больше расстояния между Брестом и Москвой.

Facebook: Прайнвилл, штат Орегон (США)

При возведении ЦОД в Прайнвилле было использовано 1560 тонн стали, что сопоставимо по весу с 9 сотнями автомобилей среднего размера.

Если перевернуть крупнейшее здание (Building 1) на кампусе ЦОД Facebook в Прайнвилле на бок, оно сравнится по высоте с 81-этажной высоткой.

Facebook: Прайнвилл, штат Орегон (США)

Именно на кампусе в Прайнвилле инженеры Facebook решили впервые использовать наработки, созданные в рамках инициативы Open Compute Project (OCP). Когда этот ЦОД начал обслуживать трафик, представители Facebook отметили, что он оказался на 38 процентов более энергоэффективным, чем коммерческие серверные фермы, площади внутри машзалов которых соцсеть в то время арендовала. Ввод объекта в эксплуатацию позволил соцсети снизить текущие расходы на свою вычислительную инфраструктуру на 24 процента.

Facebook: Алтуна, штат Айова (США)

Строящийся кампус ЦОД Facebook в городе Алтуна будет иметь площадь в 82 гектара, что на 20% больше чем у находящегося неподалеку Диснейленда.

Facebook: Алтуна, штат Айова (США)

Интересный факт: инженеры Facebook подсчитали, что в первое здание на кампусе ЦОД в Алтуне (Building One), сможет вместиться 6.4 миллиарда мячиков для пинг-понга.

Facebook: Алтуна, штат Айова (США)

Информация о первой очереди проекта по возведению кампуса ЦОД в городе Алтуна была представлена более года назад. С тех пор более 460 человек приняли участие в работе над проектом. На возведение здания площадью около 46 тысяч квадратных метров к настоящему моменту было потрачено более 435 тыс. человеко-часов.

Юристы Facebook уже направили в адрес местного городского совета запрос поводу выдачи разрешения на строительство второго здания на кампусе ЦОД, которое будет практически полной копией первого.

Facebook: Форест-Сити, штат Северная Каролина (США)

Кампус ЦОД соцсети близ города Форест-Сити, был построен на земельном участке площадью в 65 гектара. Открыт он был в 2012 году. В рамках этого проекта инженеры соцсети смогли вывести концепцию Open Compute Project на качественно новый уровень.

Благодаря энергоэффективным конструкциям OCP компании Facebook удалось добиться существенного сокращения затрат на эксплуатацию инфраструктуры. Снижение расхода электроэнергии за счет внедрения продвинутого оборудования позволило высвободить достаточно электричества для удовлетворения потребностей 40 000 домохозяйств в течение года, а также уменьшить углеродный след компании на объем эквивалентный эффекту от удаления 50 000 автомобилей с дорог общего пользования.

Facebook: Форест-Сити, штат Северная Каролина (США)

Чтобы добиться дальнейшего снижения затрат, инженеры Facebook создали механизм повторного использования излишков тепловой энергии серверов для обогрева офисных помещений в течение холодных месяцев.

Facebook: Форест-Сити, штат Северная Каролина (США)

Система испарительного охлаждения используется для испарения воды и охлаждения поступающего в машзалы воздуха. Она выгодно отличается от стандартных систем охлаждения на базе чиллеров, для работы которых требуется большое количество электроэнергии.

Facebook: Форест-Сити, штат Северная Каролина (США)

Дата-центр в Форест-Сити охлаждается на 100 процентов с помощью наружного воздуха (фрикулинг), что позволяет добиться существенной экономии на эксплуатационных расходах.

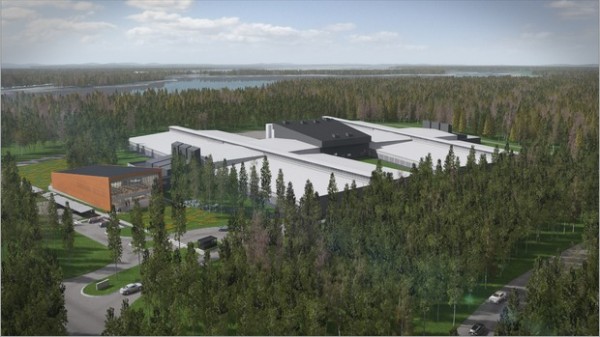

Facebook: Лулео, Швеция

Первый ЦОД Facebook за пределами США появился в Швеции. По всей видимости, американские инженеры решили не только использовать преимущества региона с точки зрения благоприятного климата и наличия множества ГЭС, но и применить разработанный шведами подход к созданию всевозможных конструкции для дома, начав строить ЦОД по технологии схожей с концепцией сборки мебели из Ikea.

Facebook: Лулео, Швеция

Разработанная специалистами соцсети Facebook концепция RDDC (Rapid Deployment Data Center или ЦОД быстрого развертывания) предполагает применение модульных конструкций и принципов бережливого использования строительных материалов в масштабе кампуса ЦОД.

В основе RDDC лежат два принципа: перед размещением модульных блоков создаются несущие рамы; на удаленном заводе на быстровозводимые модули, которые впоследствии размещаются на рамах, устанавливаются все необходимые дополнительные компоненты (от систем освещения до структурированных кабельных систем). Конструкции доставляются на строительную площадку на грузовиках.

Специалисты Facebook считают, что этот подход позволит компании создавать по два машзала, тратя столько же времени, столько ранее уходило на один машзал, при одновременном значительном сокращении количества материала, необходимого для строительства.

Facebook: Лулео, Швеция

Инженер Facebook Марко Магарелли еще в марте отметил в своем блоге, что концепция RDDC была сформирована из лайф-хака.

«Наши предыдущие конструкции позволяли создавать крупные крытые помещения. Но они также предполагали довольно трудоемкие мероприятия по сборке и размещению электрораспределительных систем и элементов инфраструктуры охлаждения непосредственно на месте строительства. Вместо этого мы решили использовать концепцию похожую на ту, которой руководствуются покупатели сборной мебели Ikea. Мы сделали упор на размещение всех необходимых компонентов в модульные конструкции на удаленном заводе, где этот процесс поставлен на поток. Затем готовый ЦОД собирается на стройплощадке из стандартных модулей, которые можно легко транспортировать к месту строительства серверной фермы «, пишет Магарелли.

Facebook: Лулео, Швеция

Благодаря своим мощным дата-центрам соцсеть Facebook может обрабатывать в среднем по шесть миллиардов «лайков» в день. За последние 10 лет дата-центры Facebook обработали более 400 млрд. фотографии и примерно 7.8 триллиона отправленных сообщений.

Facebook: Лулео, Швеция

В настоящее Facebook строит второй ЦОД на территории кампуса в Лулео, используя концепцию RDDC. Площадь этого строения должна составить около 12.5 тысяч квадратных метров.

Всего комментариев: 0