Фотоотчет: холодное хранилище Facebook в действии

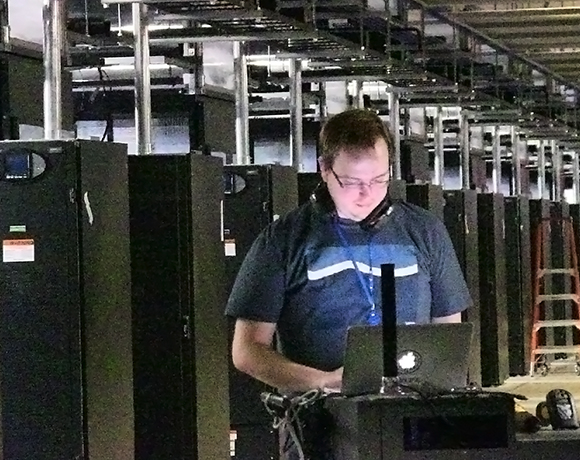

Среднеаттический оператор ЦОД Facebook обслуживает по 20 000 серверов благодаря достижениям компании в области стандартизации, автоматизации и максимизации отказоустойчивой IT-инфраструктуры. В дата-центрах американской соцсети по всему миру используются сотни тысяч серверов, созданных по спецификациям Open Compute Project. Десятки тысяч таких машин работают в машзалах серверной фермы Facebook в городе Форест-Сити, штат Северная Каролина (США). Причем эти машины четко разделены в соответствии с выполняемых функционалом: стандартные вычисления, хранение данных, обработка баз данных, обслуживание запросов и так далее. Ниже представлен фотоотчет о том, как дата-центр в Форест-Сити выглядит изнутри. Причем особое внимание уделено освещению серверного оборудования, которое используется для организации так называемого «холодного хранилища» (инфраструктура хранения редко используемого контента: фотографий, видеороликов, музыки).

Среднеаттический оператор ЦОД Facebook обслуживает по 20 000 серверов благодаря достижениям компании в области стандартизации, автоматизации и максимизации отказоустойчивой IT-инфраструктуры. В дата-центрах американской соцсети по всему миру используются сотни тысяч серверов, созданных по спецификациям Open Compute Project. Десятки тысяч таких машин работают в машзалах серверной фермы Facebook в городе Форест-Сити, штат Северная Каролина (США). Причем эти машины четко разделены в соответствии с выполняемых функционалом: стандартные вычисления, хранение данных, обработка баз данных, обслуживание запросов и так далее. Ниже представлен фотоотчет о том, как дата-центр в Форест-Сити выглядит изнутри. Причем особое внимание уделено освещению серверного оборудования, которое используется для организации так называемого «холодного хранилища» (инфраструктура хранения редко используемого контента: фотографий, видеороликов, музыки).

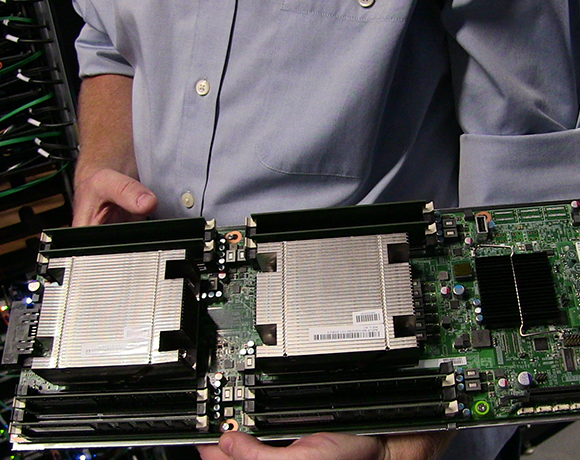

Facebook активно использует аппаратное обеспечение, созданное в рамках инициативы Open Compute Project в своих дата-центрах ввиду дешевизны и эффективности такого «железа» при решении отдельных задач.

Напомним, что участники инициативы OCP стремятся удалить из IT- и вспомогательного оборудования для ЦОД все ненужные компоненты. OCP-серверы имеют модульную конструкцию и комплектуются стандартизированными компонентами. Каждый элемент конкретной машины еще на этапе проектирования удешевляется по максимуму, после чего Facebook заказывает крупную оптовую партию состоящих из этих компонентов серверов для получения дополнительной скидки.

Избавленные от всего ненужного машины лучше походят для эксплуатации в более жестких условиях, чем обычно. Благодаря отсутствию полноценного корпуса воздушные потоки легко проходят через горячие компоненты на текстолите машин, что позволяет снизить обороты и, как следствие, энергопотребление охлаждающих вентиляторов, а также уменьшить их число. Температура внутри «холодных» коридоров, используемых для нагнетания воздуха внутрь монтажных стоек с плотно расположенными OCP-серверами в дата-центрах Facebook, может достигать 28 градусов по Цельсию (83 градусов по Фаренгейту ). Температура в «горячих» коридорах может достигать 49 градусов по Цельсию (120 градусов по Фаренгейту).

Прогуливаясь внутри огромного дата-центра с тысячами серверных систем в каждом ряду стоек, вы ожидаете столкнуться со столь же огромным уровнем шума. Но серверная ферма Facebook в Форест-Сити, как ни странно, является относительно тихим местом. Фальшпол вы там не найдете, равно как и механические кондиционеры. Вместо них для оптимизации температурного режима серверов используется нагнетаемый внутрь здания наружный воздух. Воздух предварительно фильтруется, увлажняется или осушается и направляется к монтажным стойкам. Нагретые воздушные массы покидают серверы Facebook и попадают в «горячие» коридоры. К слову, дополнительное снижение энергопотребления серверной фермы в Форест-Сити достигается за счет системы контроля освещения, которая включает и выключает LED-лампы, исходя из показаний с датчиков движения.

Инженеры Facebook стремятся минимизировать негативное влияние серверной фермы на экологию региона не только путем повышения энергоэффективности инфраструктуры, но и посредством активной высадки зелени снаружи дата-центра. На фото выше представлена телекия. Этим многолетним вечнозеленым растением засажен участок земли в центре кампуса ЦОД. Примечательно, что Facebook стремится интегрировать свой дата-центр с местным сообществом, проводя всевозможные художественные конкурсы для школьников и курируя программу стажировок с местном колледже.

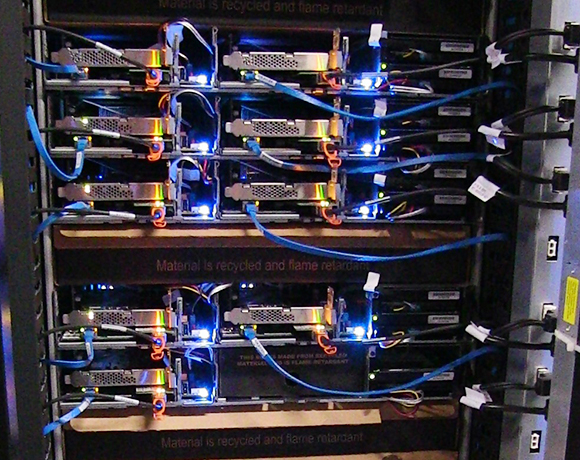

Дата-центр Facebook в штате Северная Каролина является одним из двух объектов, которые соцсеть приспособила под «холодные хранилища». Как любая другая крупная IT-компания Facebook часто сталкивается с необходимостью обслуживать данные, которые используются довольно редко. Хранить эту информацию на стандартных серверах накладно. Поэтому инженеры соцсети создали инфраструктуру хранения контента с многоуровневой архитектурой, в рамках которой старые и редко используемые данные размещаются на дешевых и медленных жестких дисках. Наиболее часто используемые данные при этом размещаются на гибридных СХД (HDD + SSD). Такой подход снижает энергопотребление IT- инфраструктуры и расходы на ее расширение, практически не влияя при этом на качество обслуживания пользователей.

Так выглядят монтажные стойки с оптимизированными для хранения редко используемого контента серверами в дата-центре Facebook. Поскольку подобный контент используется редко, нагрузка на систему охлаждения со стороны соответствующих серверов значительно ниже, чем в основных машзалах. Именно поэтому температура в «холодных» коридорах, сообщающихся с данными серверами, несколько выше, чем в среднем по ЦОД.

Руководство компании Facebook поощряет сотрудничество между командами специалистов по обслуживанию IT-оборудования и экспертов по обеспечению работоспособности вспомогательной инфраструктуры. Это способствует стабильности и упрощает процедуру ремонта оборудования в случае необходимости. Примечательно, что для обслуживания OCP-серверов (для демонтажа и замены отказавших компонентов машин) требуется минимальное количество инструментов.

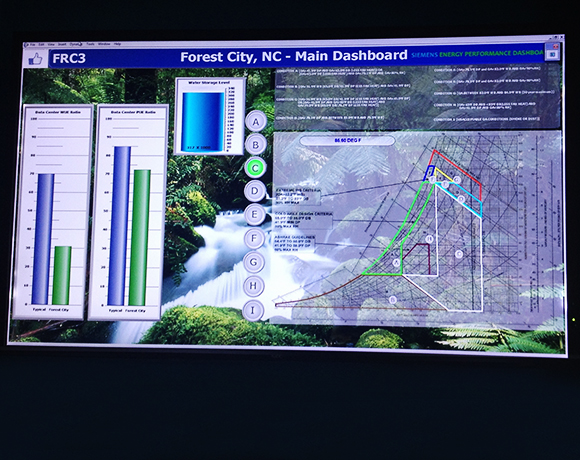

Операторы дата-центра в Форест-Сити постоянно отслеживают коэффициент эффективности использования энергии (PUE) наряду с коэффициентом эффективностью использования воды (WUE). При этом данная информация также доступна всем желающим. Специальная интернет-панель Facebook отображает PUE и WUE для кампуса Форест-Сити в режиме реального времени, а также позволяет получить доступ к средним значениям этих показателей за последние 12 месяцев. Кроме того, все желающие могут ознакомиться с информацией о температуре и влажности снаружи ЦОД. Сочетание разумного выбора места, инновационного подхода к проектированию системы охлаждения, высокоэффективного управления инфраструктурой и продвинутых серверов позволяет Facebook достигать среднего PUE ниже 1.10 и WUE ниже 0.50 л / кВт*ч.

Когда вы покидаете обычную комнату / здание, то практически машинально выключаете свет. В дата-центре Facebook за этой действие отвечает автоматика, которая позволяет избежать растрат электроэнергии впустую на освещение помещений, в которых нет людей.

Всего комментариев: 0