ЦОД eBay и адиабатное увлажнение

«Оборудование центра обработки данных должно эксплуатироваться в температурном диапазоне до +25°C, а охлаждение предпочтительно осуществлять с помощью чиллеров или прецизионных кондиционеров». До недавнего времени, благодаря рекомендациям ASHRAE (American Society of Heating, Refrigerating and Air Conditioning Engineers, одной из наиболее авторитетных организаций в области охлаждения и кондиционирования), это была аксиома. Но расходы на электроэнергию для охлаждения ЦОД росли вместе с тарифами и мощностью оборудования, и, в конце концов, системы охлаждения стали потреблять 35-40 % всей энергии, необходимой для функционирования дата-центра.

Intro

Существует традиционный подход к снижению энергопотребления холодильного агрегата, заключающийся в поиске более эффективных хладагентов и подборе параметров работы системы. Но это — эволюционное развитие, по сути, битва за считанные проценты повышения энергетической эффективности. В этом контексте полный отказ от компрессорно-конденсаторных агрегатов и переход на использование возможностей наружного воздуха можно считать путем революционным. В Мурманске или Норильске такой подход был бы вполне оправдан. Но ЦОД с freecooling в жаркой пустыне — это, на взгляд неспециалиста, уже из области неочевидных маркетинговых решений, придуманных ради «зеленого зуда» и других малопонятных нам пока явлений.

Тем удивительнее то, что к маркетингу такое решение имеет существенно меньшее отношение, а столь нетрадиционный подход обусловлен, в первую очередь, экономическими и техническими причинами. Дата-центр «Меркурий», что в Финиксе, штат Аризона, принадлежит известному всем нам eBay. Эта компания выбирает расположение для своих площадок таким образом, чтобы минимизировать задержки для пользователей по всему миру, ведь на eBay заключается сделок на 2000 долларов ежесекундно, а значит, для сервисов компании жизненно важно оставаться доступными «24/7/365». Таким образом, дата-центр в Финиксе расположен географически удачно. А вот климатически… Тропический пустынный климат, очень жаркое лето с максимумами в районе +50 ᵒС. Тут впору думать о том, что не каждая холодильная машина выдержит работу в подобных условиях, не говоря уже о «фрикулинге». Но изначальные условия – максимальная плотность размещения оборудования и максимальная вычислительная мощность на ватт потребляемой дата-центром энергии – не оставляли выбора: применение традиционных систем охлаждения разбило бы в пух и прах все мечты о высокой энергетической эффективности. После тщательного анализа специалисты Global Foundation Services (подразделение eBay) пришли к выводу, что именно «фрикулинг» лучше всего обеспечит нужную эффективность, и объявили конкурс на проектирование ЦОД в пустыне, но — с круглогодичным охлаждением наружным воздухом.

Принцип действия

Конечно, нельзя взять проект обычного центра обработки данных с традиционными серверными стойками и переделать его систему охлаждения под наружный воздух. Оборудование, для которого IT-стандарт +25..+27 ᵒС незыблем, просто не выдержит этого перехода, ведь «фрикулинг», особенно в жарком регионе, в принципе не может обеспечивать необходимую температуру. Требуется оборудование, способное нормально работать при более высоких температурах. И такое оборудование было найдено в линейке Dell: модульные дата-центры с серверами Dell PowerEdge и плотностью стойки до 30 КВт.

Но как быть с температурой воздуха до +50 градусов по Цельсию? Конечно, температурный диапазон оборудования PowerEdge несколько шире (до 45 градусов в краткие пики), но не до такой же степени! И вот тут было применено совсем уж дикое для большинства IT-специалистов решение: адиабатное увлажнение, или охлаждение с использованием теплоты парообразования воды для отбора тепла от воздуха. Суть предельно проста: в сухой горячий воздух (каковым и является воздух в Финиксе) каплями диаметром, как правило, 0,06–0,08 мм распыляется обыкновенная вода, очищенная от примесей. Удельная теплота парообразования воды — 2260 КДж/кг, удельная теплоемкость воздуха – 1,006 КДж/кг*°С. Таким образом, за счет испарения килограмма воды температура 2200 килограмм воздуха может быть снижена на один градус. На практике температура воздушного потока снижается существенно (в среднем на 7 градусов, это зависит от сочетания факторов). Минусом же данного подхода является рост влажности воздуха. Каждый благодаря многочисленным стереотипам знает: повышенная влажность — это смерть для оборудования, это отказы и преждевременный выход серверов из строя.

Многочисленные исследования гигантов индустрии показали, что это не так. Большая часть оборудования в состоянии выдержать и повышение температуры, и увеличение влажности воздуха безо всякого вреда для него.

Специально спроектированные для таких условий стойки и серверы, разумеется, тоже терпимо относятся к повышенной влажности. Опыт эксплуатации дата-центра «Меркурий» показал, что в короткие жаркие периоды испарение воды способно поддерживать температуру воздуха на приемлемом для ЦОД уровне, при этом большую часть года адиабатное охлаждение не требуется вовсе — все же в Финиксе есть и весьма холодные месяцы. В дата-центре нет никаких «пиковых» и дублирующих систем, таким образом, охлаждение оборудования ЦОД осуществляется с помощью недорогой и весьма надежной, благодаря отсутствию сложных агрегатов, системы.

Нюансы

Конечно, реализация такой системы, да еще и в столь нетрадиционном исполнении, связана с массой практических трудностей. Так, крайне важно совместить правильный диаметр капли и скорость воздушного потока: если она не вписывается в «эталоны красоты» или скорость воздушного потока слишком высока, ее вынесет за пределы пространства, где происходит теплообмен, и соответственно, «фокус не удастся». Вода должна отвечать довольно серьезным требованиям по содержанию CaCO3 и жесткости (8–12 градусов жесткости, 1 градус жесткости соответствует содержанию CaCO3 в количестве 1 мг-экв/л примеси), показатель pH также не должен быть выше 7, иначе элементы системы охлаждения будут подвергаться коррозии. Есть и менее очевидные сложности: например, что делать с водой, которая не испарится, как и куда ее собирать?

Profit

Однако после преодоления этих трудностей применение столь нетрадиционной для дата-центров системы охлаждения позволило добиться завидной энергоэффективности. Коэффициент PUE (Power usage effectiveness, рассчитывается как общая мощность оборудования, поделенная на мощность IT-оборудования) в августовский день составил 1,043, т.е. вспомогательное оборудование, включая систему охлаждения, даже летом потребляет всего около четырех процентов энергии ЦОД, зимой – и того меньше, PUE в районе 1,018. Эффективность компрессорно-конденсаторных систем на основе чиллеров или DX-кондиционеров существенно ниже, для них PUE в районе 1,3 – достижение. Даже в самые жаркие дни «свободная» система охлаждения ЦОД дает возможность серверам функционировать надежно и безотказно. Вспомните, ведь площадкой владеет eBay. Если бы в эффективности и стабильности такого решения были хоть какие-то сомнения, компания, чья жизнь зависит от доступности ее площадок, никогда бы на такое не пошла. А ведь ЦОД «Меркурий» площадью 12 600 квадратных метров и мощностью 4 МВт функционирует уже больше года.

Интересно, что такая система охлаждения и размещение модулей обработки данных на крыше дата-центра позволяют не только эффективно их охлаждать, но и быстро увеличивать вычислительную мощность, если это необходимо. Так, с помощью специальных кранов на крышу может быть поднято полторы тысячи серверов за двадцать минут. Затем их быстро подключают к электричеству и водоснабжению, и вот уже через час они в строю. ЦОД обладает возможностями быстрого расширения мощности до 6 МВт, а также необходимой инфраструктурой для увеличения ее до 12 МВт. 12 600 квадратных метров – совсем немного по меркам современных ЦОД, но такие мощность и плотность – это уже серьезно.

Использование фрикулинга совместно с адиабатным испарительным охлаждением в «жарком» ЦОД — смелое, нетрадиционное, неочевидное, но уже доказавшее свою работоспособность решение.

Конечно, прецизионники и чиллеры никуда не денутся, да и к повышению средней температуры воздуха в ЦОД с воздушным охлаждением надо подходить аккуратно. Но если даже ASHRAE в своих рекомендациях 2011 года признает существование оборудования классов А3 (до 40 ᵒС) и А4 (до 45 ᵒС), а eBay с таким оборудованием уже вовсю работает — значит, ни влажности, ни повышенной температуры не следует бояться только потому, что они есть и ходит слух об их плохой совместимости с серверами. Грамотно подобранное оборудование, эффективная система охлаждения и хорошо налаженный мониторинг – вот и все секреты сверхэффективных дата-центров, доля которых наверняка будет расти в ближайшие годы, в том числе и в нашей стране.

Родные пенаты

Откуда такие выводы? Причина проста: ФЗ-261 устанавливает достаточно жесткие рамки для всех серьезных потребителей ресурсов, а также серьезные показатели повышения энергетической эффективности –—40 % к 2020 году. Переходом на природные хладагенты и применением новых терморегулирующих вентилей таких показателей не достичь. Кроме того, это — при достаточно больших вложениях — не всегда сколько-нибудь ощутимая экономия. А вот переход на принципиально иную парадигму охлаждения ЦОД с помощью наружного воздуха — это и почти те самые требуемые десятки процентов, и, с учетом постоянно растущих тарифов на энергоносители, существенная экономия на эксплуатации дата-центра. Деньги, растущая мощность серверного оборудования, а также нормативные документы, которые после появления ФЗ-261 плодятся как грибы после дождя — вот то, что уже очень скоро приведет фрикулинг в отечественные дата-центры.

Источник: habrahabr.ru

Очередной сок мозга с хабры.

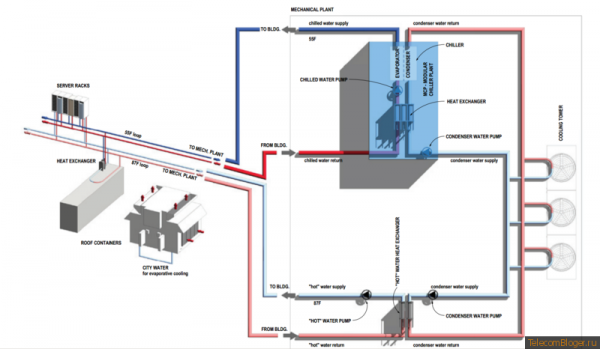

Желающие могут посмотреть исходный кейс грингрида об этом ЦОДе и понять в чем его настоящая фишка и какая небольшая роль там отводится адиабатике. И что описывает приведенная схема системы охлаждения.

Привод фрикулинга в отечественные ЦОД, где он давно есть в большинстве крупных проектов силой беспомощного ФЗ-261 оставим без комментариев.