Как строился дата-центр Phoenix NAP в Фениксе

Возведение центра обработки данных — это нетривиальная задача. Подобные проекты оказывают влияние на судьбы многих людей, позволяя экспертам в той или иной области в полной мере проявить свои лучшие качества. В этой статье речь пойдет как раз-таки об относительно масштабном объекте, возведение которого началось в 2009 году. Представляем вашему вниманию фотоотчет о строительстве ЦОД компании Phoenix NAP площадью в 14.8 тыс. квадратных метров в Фениксе, США. Объект был введен в эксплуатацию в позапрошлом году. В настоящее время Phoenix NAP предоставляет на базе этого дата-центра сервисы IaaS (Infrastructure As a Service / «инфраструктура как услуга»). Иными словами компания представляет услуги облачной инфраструктуры дата-центра как сервис.

Возведение центра обработки данных — это нетривиальная задача. Подобные проекты оказывают влияние на судьбы многих людей, позволяя экспертам в той или иной области в полной мере проявить свои лучшие качества. В этой статье речь пойдет как раз-таки об относительно масштабном объекте, возведение которого началось в 2009 году. Представляем вашему вниманию фотоотчет о строительстве ЦОД компании Phoenix NAP площадью в 14.8 тыс. квадратных метров в Фениксе, США. Объект был введен в эксплуатацию в позапрошлом году. В настоящее время Phoenix NAP предоставляет на базе этого дата-центра сервисы IaaS (Infrastructure As a Service / «инфраструктура как услуга»). Иными словами компания представляет услуги облачной инфраструктуры дата-центра как сервис.

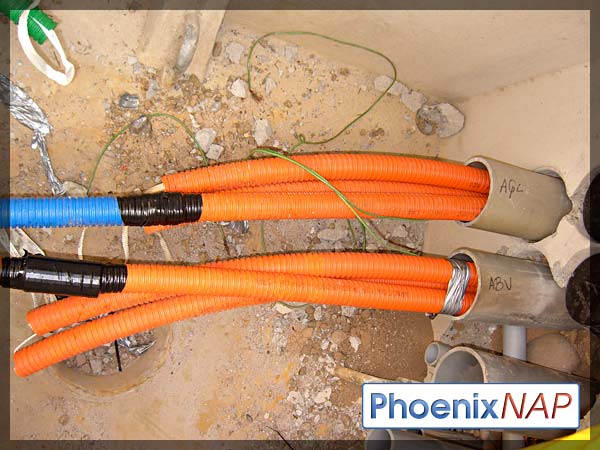

Все начинается со строительства кабельно-канализационных сооружений связи. Было проложено 40 изоляционных труб. При этом внутри каждой трубы заведено по три гибких кабельных канала. В одну траншею укладывается по восемь труб. К зданию ЦОД Phoenix NAP проходят две траншеи: по одной на каждый узел связи. В общей сложности дата-центр подключен к 48 операторам связи. Инженеры использовали жидкий цементный раствор, чтобы заполнить траншеи и добиться дополнительной защиты.

Все начинается со строительства кабельно-канализационных сооружений связи. Было проложено 40 изоляционных труб. При этом внутри каждой трубы заведено по три гибких кабельных канала. В одну траншею укладывается по восемь труб. К зданию ЦОД Phoenix NAP проходят две траншеи: по одной на каждый узел связи. В общей сложности дата-центр подключен к 48 операторам связи. Инженеры использовали жидкий цементный раствор, чтобы заполнить траншеи и добиться дополнительной защиты.

Все эти трубопроводы в конечном итоге подходят к узлам кросс-коммутации(meet-me-room) дата-центра. После завершения строительства все они будут полностью залиты в бетон.

После демонтажа каркасных конструкций и обработки стен пескоструем и монтажа новых стен узла, можно приступать к следующей части проекта, которая включает установку фальшполов. Когда работы завершатся, площадь узла связи будет составлять 280 квадратных метров.

Видеоролик в технике Time Lapse (ускоренная съемка) по строительстве узла связи.

Монтаж распределительных щитов электропитания.

Фальшпол для укладки в узле связи

Краткая демонстрация модулей CRAH (Computer Room Air Handler), которые используются в ЦОД. Под 36-дюймовым фальшполом нет никаких кабелей, поэтому поток воздуха будет свободно по нему перемещаться. Модули CRAH будут прогонять более 1.6 миллиона кубических футов воздуха в минуту (CFM) через систему охлаждения дата-центра.

Процесс укладки фальшпол в узле связи. Высота фальшпола в 90 см без СКС позволит прогонять по нему максимально возможный поток воздуха с помощью модулей CRAH.

К зданию были подведены все гибкие кабельные каналы с оптоволокном, которые проходят по восьми металлически трубам.

После установки фальшпола в узле связи настал черед кабельных лотков лестничного типа. Все кабели внутри узла связи проходят от узла кросс-коммутации к серверам, будут находиться внутри этих лотков. Каждый лоток будет двухуровневым: один уровень для кабелей электропитания и еще один для волоконно-оптических / медных кабелей. Высота каждого будет составлять 91 см.

Time Lapsed видео об установке фальшпола внутри узла связи.

В соседнем техническом помещении с узлом связи, установлены три 80-тонных(281 кВт) модуля CRAH (тонна в данном случае представляет собой единицу холодопроизводительности; 1 тонна охлаждения = англ. 3320 ккал/час, амер. 3024 ккал/час). Представьте себе, как все это оборудование мощностью в 240 тонн(844 кВт) будет охлаждать узел связи и кросс-коммутации.

Вы никогда не задумывались, насколько мощным может быть 80-тонный модуль CRAH? Взгляните на это короткое видео, показывающее как директор Phoenix NAP по разработке дата-центров Джордан Джейкобс удерживает собственную каску от полета в стратосферу!

Даже напольная плитка взмывает вверх под воздействием потока воздуха от высокопроизводительного 80-тонного модуля CRAH.

AGL Networks и AboveNet завели свои волоконно-оптические линии связи в здание ЦОД.

Строительство пропускного шлюза. В нем будет использоваться многоэлементная система безопасности. Аутентификация посетителей будет производиться на основе карты-пропуска, PIN-кода, а также сканирования радужной оболочки глаза. Все посетители должны будут пройти через пропускной шлюз, чтобы попасть во внутренние помещения дата-центра.

Насколько крупным может быть чиллер мощностью в 720 тонн? Взгляните на эти фотографии, чтобы оценить масштабы системы самостоятельно. Охладитель с центробежным компрессором (центробежный водоохладитель / чиллер) будет использоваться в составе модульной системы McQuay. В Phoenix NAP располагается целых восемь таких систем общей мощностью в 5700 тонн.

Отдельные клиентские зоны в машзале ЦОД были размещены внутри узла обмена трафиком. Как вы можете видеть на фотографиях, некоторые поставщики телекоммуникационных услуг уже поместили свое оборудование в отведенные для этого места.

До сих пор большая часть строительных работ была сосредоточена на обустройстве узла связи. Как вы можете видеть в этом ролике, недавно была начата работа и над центральным коридором, в котором разместится пропускной шлюз, а также пункт аутентификации посетителей.

Инженеры занялись обустройством второго этажа. После завершения работ площадь второго этажа будут составлять около 4 700 квадратных метров. Пространство для размещения серверного оборудования будет оборудовано фальшполом (таким же, как и на первом этаже).

Time Lapsed видео о общестроительных работах второго этажа дата-центра.

Еще одно Time Lapsed видео. На этот раз ролик демонстрирует работу, которая ведется над бетонной подушкой под ДГУ, ИБП, аккумуляторные батареи, охладительные установки и многое другое.

Начинается установка электротехнического оборудования на специальной площадке рядом с дата-центра. На фото запечатлены дизельные электрогенераторы производства Cummins, размещенные в конфигурации N+1.

После установки ДГУ настал черед блоков бесперебойного питания PureWave UPS, а также подстанции, которая будет преобразовывать напряжение до 480 вольт, а затем уже подавать электричество в здание дата-центра.

На площадке рядом с ЦОД продолжается монтаж оборудования – инженеры спешат подготовить все системы к началу церемонии торжественного открытия, которая намечена на весну 2011 года. На фото показаны модульные системы охлаждения производства McQuay (McQuay Modular Central Plant). В каждом из этих предварительно собранных и готовых к использованию блоков имеются чиллеры, градирни, насосы, трубопроводы и элементы управления системой охлаждения.

Резервуары, которые станут частью накопителя тепловой энергии (теплоаккумулятор), были доставлены и установлены в ходе первой фазы возведения ЦОД. Емкости, каждая из которых вмещает 280 тыс. литров жидкости и призваны обеспечивать работоспособность системы охлаждения в случае нарушения целостности системы центрального водоснабжения, что крайне маловероятно.

Система безопасности центра обработки данных. Практически во всех ЦОД имеется подобная система. В Фениксе применяется механизм многофакторной аутентификации и пропускной шлюз. Непосредственно перед вводом здания в эксплуатацию было решено добавить на пункт пропуска высокотехнологичный сканер рисунка вен. Система безопасности Phoenix NAP, безусловно, является одной из самых передовых в секторе.

ЦОД Phoenix NAP обретает форму. Оборудование партнеров компании размещается по отдельным клиентским зонам и подключается к узлу кросс-коммутации.

Как вы можете видеть, машзалы начинают заполняться клиентскими серверными стойками. По специальным лоткам к ним подводятся силовые кабели от распределительных щитов электропитания.

Для размещения клиентских серверов и стоек следует установить распределительные щиты электропитания. Каждый из них рассчитан на 150 кВА, не занимая слишком большой площади. Удачное расположение распределительных щитов электропитания позволяет быстро развертывать новые блоки по мере необходимости — для обеспечения масштабируемости и дальнейшего роста.

Перед зданием ЦОД Phoenix NAP были установлены ограждающие тумбы (бетонные столбы, препятствующие движению автомобилей), чтобы увеличить и без того высокий уровень безопасности дата-центра.

А что тонны перевести в кВт трудно?

Нет не трудно, добавили в скобках пересчет в кВт.