Фотоэкскурсия по ИИ-суперфабрике Microsoft Fairwater в США

Стремительное развитие искусственного интеллекта (ИИ) привело к дефициту современной инфраструктуры ЦОД. Компании наращивают строительство серверных ферм, попутно пересматривая стандарты проектирования, чтобы добиться роста плотности мощности IT-оборудования в стойках, который все чаще упирается в фундаментальные законы физики.

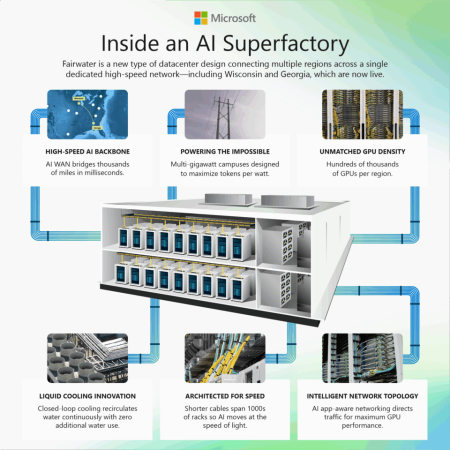

Для ИИ-моделей следующих поколений типичный дата-центр образца «десятых» или даже начала «двадцатых» может стать узким местом. Именно поэтому инженеры Microsoft озаботились созданием нового класса ЦОД, получившего название распределённая ИИ-суперфабрика. Кампус Fairwater – первая площадка подобного плана. Комплекс объединяет дата-центры в американских штатах Висконсин и Джорджия (город Атланта) в единую вычислительную систему, данные в рамках которой передаются почти «на скорости света».

В Microsoft подчеркивают, что Fairwater — это не просто распределенный ЦОД. Это другой подход к архитектуре, охлаждению, электроснабжению и сетям, ориентированный на обучение ИИ-моделей с сотнями триллионов параметров.

Почему традиционные ЦОД не справляются с ИИ?

Рост мощности GPU-кластеров в последние годы стал экспоненциальным. Обычные облачные дата-центры создавались для многозадачных распределённых клиентских нагрузок: виртуальных машин, веб-приложений, баз данных. Но обучение и запуск больших ИИ-моделей — это «монолитный» процесс, требующий:

- сверхбыстрой связи между ускорителями;

- минимальных задержек при передаче данных между стойками и рядами;

- высокой плотности мощности (до 140 кВт на стойку и 1,36 МВт на ряд);

- удаления тепла, с которым воздушное охлаждение уже не справляется;

- сетей, способных эффективно объединять сотни тысяч GPU в единую структуру.

Скорость света де-факто стала физическим пределом: лишние метры кабелей могут замедлить обучение модели.

Архитектура Fairwater

Создавая ИИ-ЦОД нового поколения, инженеры внедрили ряд инноваций и нестандартных подходов в сфере архитектуры:

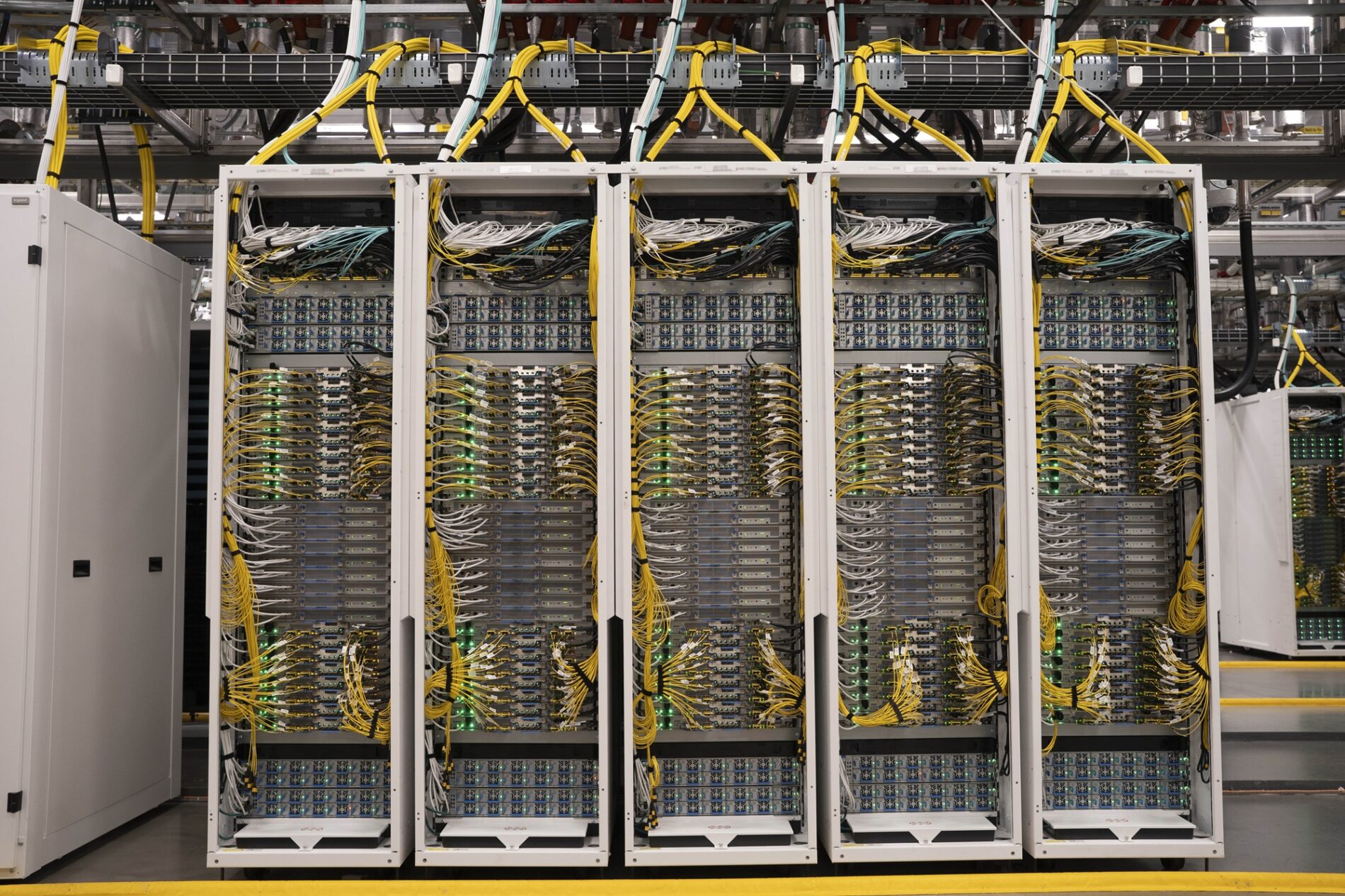

NVL72 — стойки нового класса

В каждой монтажной стойке внутри дата-центров в составе комплекса Fairwater размещено до 72 графических ускорителей NVIDIA Blackwell (GB200 / GB300), соединённых через NVLink. Такой подход даёт:

- пропускную способность до 1,8 ТБ/с на уровне GPU <-> GPU;

- 14+ ТБ пуловой графической оперативной памяти;

- поддержку формата FP4, увеличивающего производительность на ватт.

Эти стойки формируют модульные блоки, которые затем объединяются в огромные кластеры. Внутри каждого ЦОД размещаются сотни тысяч таких ускорителей.

Двухэтажная конструкция здания

Двухэтажные здания позволили компактнее размещать стойки, радикально уменьшая длину кабелей между GPU-кластерами. Меньше кабеля → меньше задержек → быстрее обучение ИИ-моделей. При этом инженерам пришлось решать серьёзные задачи, включая:

- распределение веса серверов над нижним этажом;

- прокладку трубопроводов охлаждения;

- разработку вертикальных магистралей для сети и кабелей электропитания.

Жидкостное охлаждение как база, а не вспомогательный элемент

Воздушное охлаждение более не способно удалять тепло от вычислительных кластеров со сверхплотным размещением компонентов. Например, от кластеров GPU-ускорителей Blackwell, работающих при плотности мощности в 140 киловатт на одну монтажную стойку.

Поэтому команда Fairwater отказалась от этой технологии в пользу закрытого жидкостного контура, который сообщается с системой чиллеров через косвенные теплообменники. Причем вода используется только при первичном заполнении. Благодаря отсутствию испарения достигается высокая экологичность системы охлаждения. Объем заливаемой жидкости на уровне одного ЦОД эквивалентен годовому потреблению 20 домохозяйств. Замена теплоносителя предусмотрена лишь при отклонениях химического состава.

Новая модель электропитания: надёжность без генераторов

Часть комплекса Fairwater в Атланте построена в регионе с крайне надёжной электросетью, обеспечивающей аптайм на уровне 99,99%. Такой выбор позволил отказаться от традиционного подхода к резервированию. При строительстве было решено обойтись без ДГУ и системы ИБП для GPU-кластеров. Также нет двойного ввода силовых кабелей с независимых внешних подстанций.

При этом инженеры Microsoft совместно с партнёрами не забыли о проблеме колебаний нагрузки на электросеть, возникающих во время тренировки больших ИИ-моделей. Для ее решения были внедрены ограничители мощности GPU-ускорителей, ПО для сглаживания пиковых нагрузок, а также локальные накопители электроэнергии.

Сети Fairwater: ядро виртуального суперкомпьютера

Внутри каждого ЦОД в составе распределенной вычислительной системы инженеры Microsoft обустроили «плоскую» сеть, объединяющую сотни тысяч GPU. Заявлена передача данных со скоростью 800 Gbps на уровне GPU<->GPU.

Корпорация отказалась от проприетарных решений, сделав ставку на традиционные технологии Ethernet и SONiC. Также отмечается минимальное количество «хопов» (транзитные участки, по которым сетевой пакет перемещается от одного узла к другому в процессе маршрутизации) внутри стойки, ряда, этажа.

AI WAN — сеть, связывающая разные штаты

Microsoft проложила более 190 тыс. км (120 000 миль) нового оптоволокна, создав выделенную сеть, которая связывает Fairwater Wisconsin с Fairwater Atlanta, а также с будущими дата-центрами, которые станут частью распределенной вычислительной инфраструктуры. Сеть AI WAN работает почти со скоростью света, позволяя:

- распределять одну задачу обучения между несколькими ЦОД;

- синхронизировать GPU-кластеры в разных регионах с минимальной задержкой;

- увеличивать суммарную мощность суперкомпьютера пропорционально числу дата-центров.

Инженеры отмечают, что это принципиально новый уровень. Они создали де-факто один «виртуальный ЦОД» из нескольких физических, взаимодействующих друг с другом практически без задержек.

Масштаб и функциональность суперфабрики

Fairwater поддерживает полный цикл создания ИИ-моделей, включая предварительное обучение, настройку (fine-tuning), обучение с подкреплением на основе обратной связи с человеком (RLHF), генерацию синтетических данных и инференс с применением GB300. Причем всё это происходит в рамках единой распределённой инфраструктуры.

И корпорация не собирается останавливаться на достигнутом. В ближайшее время Microsoft вводит в строй более 100 000 GPU-ускорителей GB300 для крупномасштабного обслуживания ИИ-приложений.

География, кампусы и инфраструктурный контекст

Fairwater Atlanta расположен на кампусе площадью 250 гектаров. Он занимает более 100 тыс. квадратных метров и является первой полностью функционирующей площадкой в составе комплекса. Параллельно Microsoft инвестирует в несколько новых объектов поблизости. Благодаря этим инвестициям Атланта быстро становится вторым по значимости рынком дата-центров в США после Северной Вирджинии.

Эволюция Microsoft: от первого суперкомпьютера для OpenAI в 2019 году к Fairwater

Fairwater — результат многолетнего инженерного труда. При создании комплекса команда Microsoft использовала опыт разработки первого суперкомпьютера OpenAI (2019), развития архитектуры ранних ИИ-кластеров, постепенного повышения плотности стоек, а также оптимизации систем охлаждения, сетей и инфраструктуры электропитания. Проект Fairwater стал кульминацией этого пути.

Значение Fairwater для отрасли

Fairwater — это смена парадигмы: от дата-центров «для многих мелких задач» к ЦОД «для одной гигантской задачи». В результате реализации проекта появился ряд новых стандартов и технологических подходов, включая сверхплотные GPU-стойки, глобальную оптоволоконную сеть под ИИ-задачи, двухэтажные здания для минимизации задержек, закрытое жидкостное охлаждение, а также отказ от классической резервируемости электропитания. Для сектора ЦОД это может означать начало эры сверхмощных суперкомпьютеров, где несколько ЦОД работают как единая вычислительная структура.

Заключение

Fairwater — больше чем ЦОД. Это новая модель развертывания инфраструктуры для ИИ-задач, в которой инженерные решения продиктованы физикой, а не устаревающими отраслевыми стандартами. Сеть таких комплексов способна создать планетарный «ИИ-двигатель» для обучения моделей искусственного интеллекта с небывалой скоростью и в масштабах, недоступных предыдущим поколениям инфраструктуры. Эта архитектура станет основой для будущих прорывов — от самообучающихся систем до ИИ-моделей с сотнями триллионов параметров.

Всего комментариев: 0