Фотоотчет: как французская OVH охлаждает серверы жидкостью, экономя деньги и пространство

По мере роста вычислительных нагрузок из-за распространения искусственного интеллекта операторы ЦОД всё чаще приходят к выводу, что воздушное охлаждение больше не справляется с тепловыми потоками. В ответ вендоры наполняют мировой рынок решениями на основе жидкости – от отдельных теплообменников до комплексных модулей «под ключ».

На фоне этого тренда решение поставщика услуг ЦОД о разработке собственной нестандартной системы жидкостного охлаждения может выглядеть рискованным и дорогостоящим шагом. Однако французская OVHcloud, предлагающая облачные вычисления, хостинг и другие услуги ЦОД, выбрала именно этот путь. Компания самостоятельно строит дата-центры и производит серверы с нестандартной компоновкой, что позволяет удерживать низкие цены и лидирующие позиции на европейском рынке, а также за его пределами.

Собственная архитектура вместо готовых решений

В OVHcloud исходят из принципа полного контроля над инженерными решениями. Как отмечает руководитель направления исследований и разработок в области охлаждения Али Шехаде, философия компании формулируется просто: контроль на стадии проектирования = контроль результата.

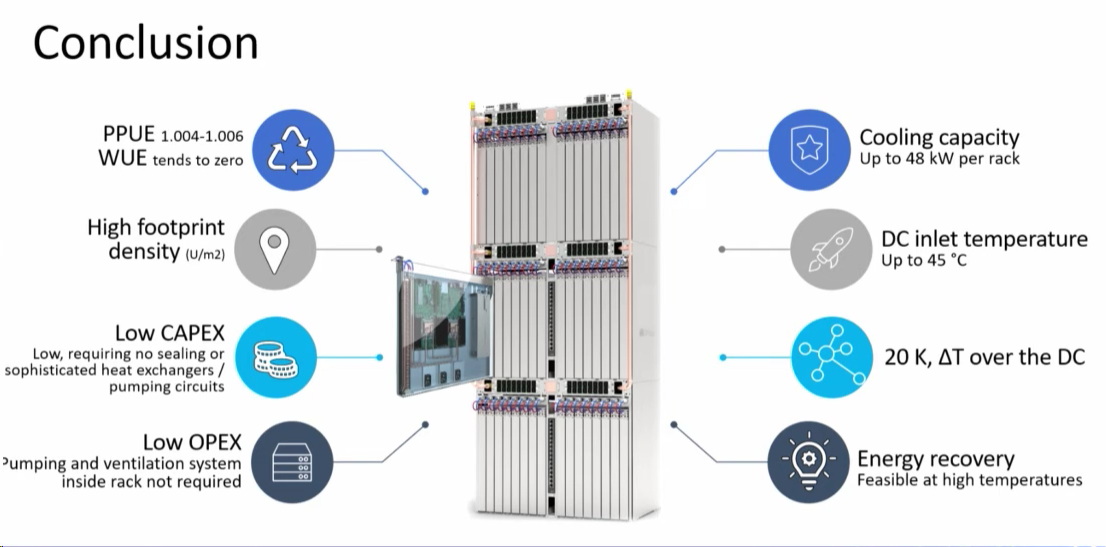

Разработка новой системы охлаждения заняла около двух лет и потребовала значительных вложений, включая финансирование научных программ и прикладных исследований. Однако в результате компания получила собственную архитектуру, охватывающую как серверные стойки, так и механизм распределения охлаждающей жидкости. По оценкам OVHcloud, новая система позволяет:

- сократить энергопотребление охлаждения на 50%;

- снизить потребление воды примерно на 30%;

- обслуживать тысячи серверов с помощью одного узла распределения хладагента (Coolant Distribution Unit, CDU).

Технология уже внедрена на одной из площадок во Франции и готовится к масштабированию с прицелом на всю инфраструктуру компании.

От инженерных экспериментов к серийному производству системы промышленного класса

Проект возглавил непосредственно Шехаде — инженер-механик по образованию, пришедший в OVHcloud около десяти лет назад после защиты докторской диссертации в Orange Labs. Его ранние исследования были посвящены охлаждению телекоммуникационного оборудования за счёт конструктивных особенностей корпусов в пассивном режиме — без использования активных механических систем.

Хотя жидкостное охлаждение применяется инженерами OVHcloud с 2003 года, интерес к этой технологии резко вырос в последние три года. Причина — скачок тепловыделения серверных компонентов на фоне развития искусственного интеллекта и роста плотности IT-систем внутри стоек.

По словам Шехаде, ранее отрасль ЦОД не была готова к масштабному переходу на жидкостные технологии. Сегодня же становится очевидно, что установка современных серверов без использования жидкости как теплоносителя практически невозможна.

При этом в OVHcloud подчёркивают, что для французской компании внедрение жидкостного охлаждения с акцентом на устойчивое развитие — не маркетинговый лозунг, а следствие взятого десятилетиями ранее курса на экономию ресурсов через внедрение передовых инженерных решений.

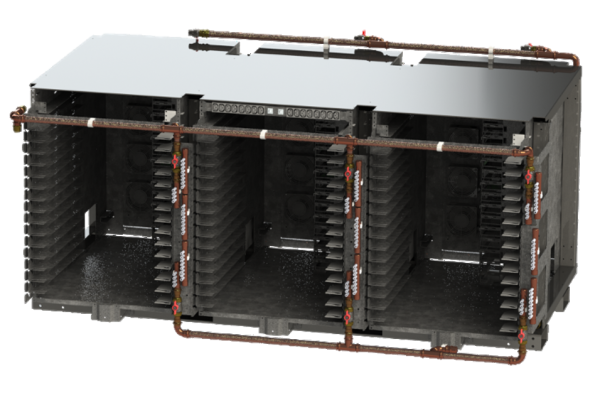

Переосмысление конструкции серверной стойки

Работа над новой архитектурой началась около двух лет назад в исследовательском центре OVHcloud во французском городе Круа, расположенном недалеко от Лилля. К тому моменту компания уже несколько лет использовала собственные стойки с горизонтальным размещением серверов.

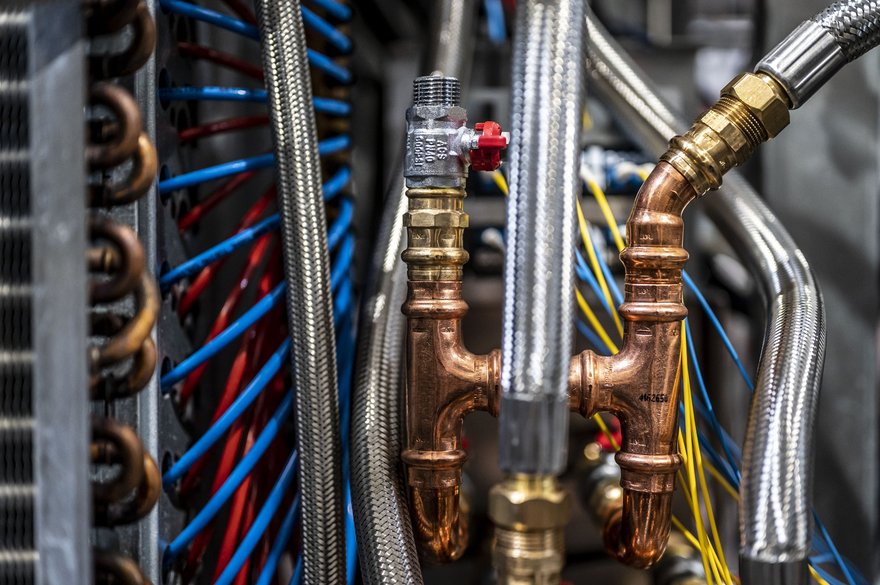

Классическая проблема таких стоек — наличие встроенного узла распределения охлаждающего агента, включающего насосы, клапаны и датчики. Эти элементы потребляют электроэнергию и ограничивают масштабируемость.

Первым шагом стал вынос CDU за пределы стойки. Само по себе это не является революцией: межстоечные узлы CDU давно применяются в дата-центрах по всему миру. Инновационность подхода французов заключается в том, как именно организована система.

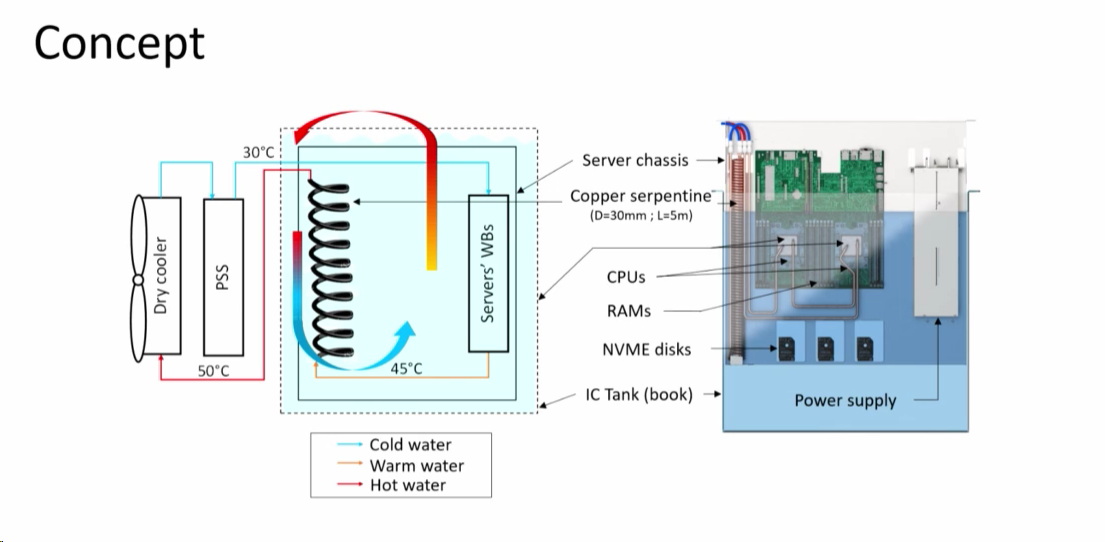

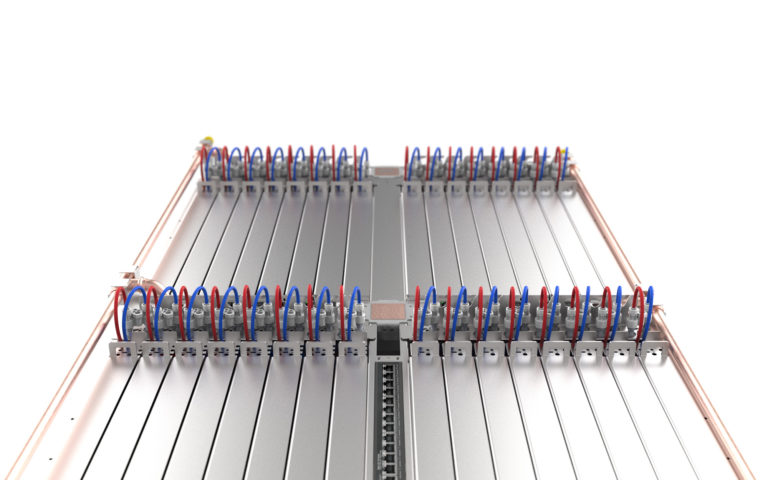

Кластеры стоек, последовательное соединение и один насос

Инженеры OVHcloud объединили стойки в кластеры, внутри которых серверы подключены параллельно. Это позволяет обслуживать отдельные вычислительные узлы без остановки всей системы — стандартная практика для крупных дата-центров.

Ключевое отличие — последовательное соединение самих кластеров. Вместо того чтобы оснащать каждый из них собственным узлом распределения охлаждающего агента, OVHcloud использует один насос для подачи жидкости сразу в несколько кластеров. Это стало возможным по двум причинам:

- Низкие требования к давлению воды. Система не требует высокого давления, поэтому один насос способен обслуживать сразу несколько кластеров.

- Снижение температуры жидкости на входе в стойки. Ранее охлаждающая жидкость поступала в серверные стойки через теплообменники, что приводило к росту внутристоечной температуры. Теперь, после выноса узла CDU и отказа от теплообменников, жидкость поступает к оборудованию при более низкой температуре.

В результате одна и та же вода может последовательно охлаждать до восьми кластеров серверов при сохранении допустимых температурных пределов.

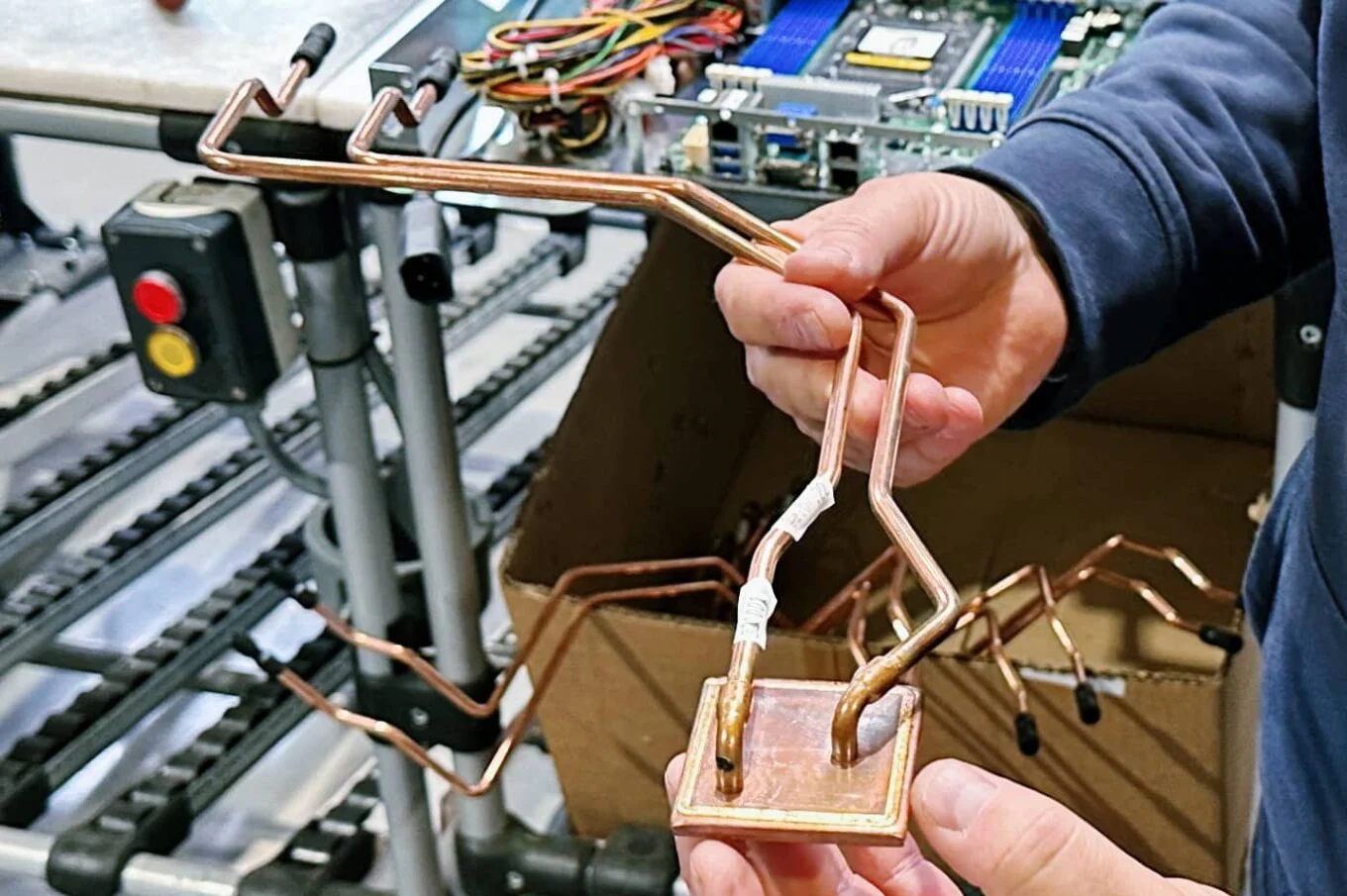

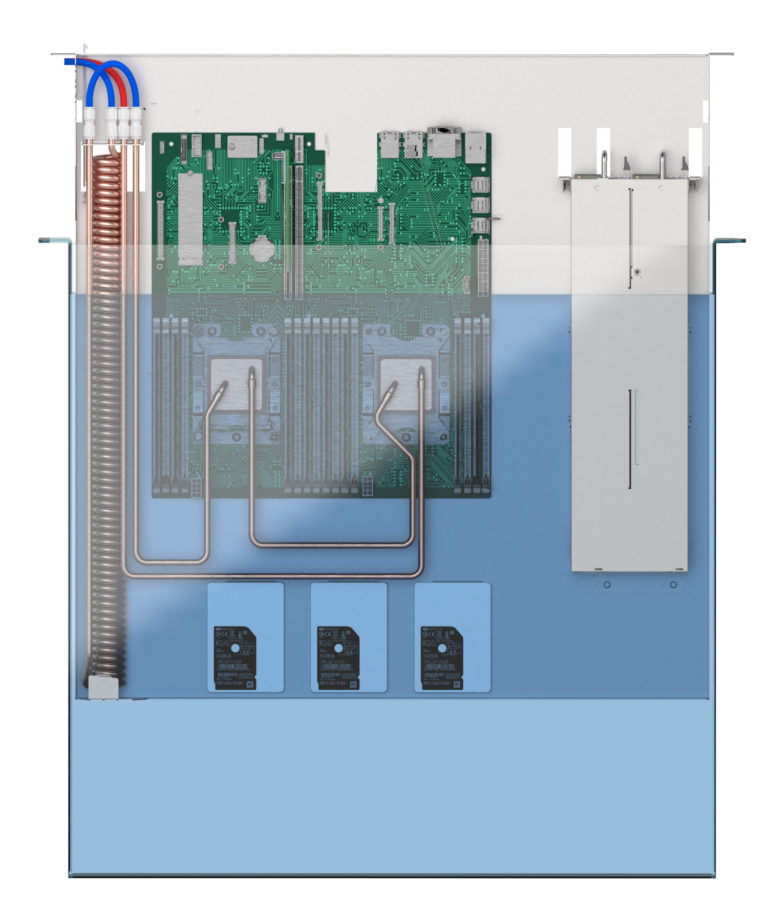

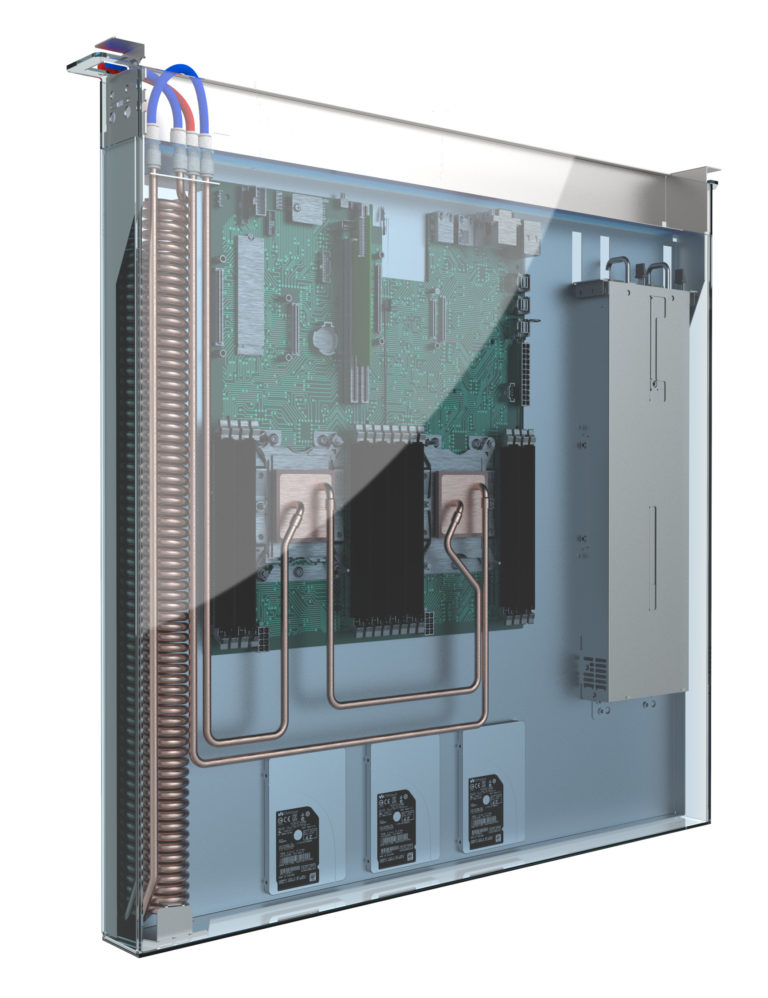

Прямоконтактное охлаждение процессоров и управление тепловым градиентом

Новая архитектура предполагает использование водяных блоков теплоотвода, устанавливаемых непосредственно на процессоры с применением технологии прямоконтактного охлаждения кристалла (Direct-to-Chip Cooling).

Жидкость поступает в первый кластер при температуре около 35 °C, обеспечивая максимальный тепловой запас для самых производительных серверов. Даже в последнем кластере цепочки температура остаётся ниже значений, считающихся допустимыми в контексте эксплуатации IT-оборудования. Такой температурный градиент вынудил французов внедрить ряд нестандартных практик, включая:

- размещение наиболее мощных серверов ближе к началу цепочки;

- гибкое распределение оборудования с разными тепловыми профилями;

- управление конфигурациями IT-систем с помощью математических алгоритмов планирования.

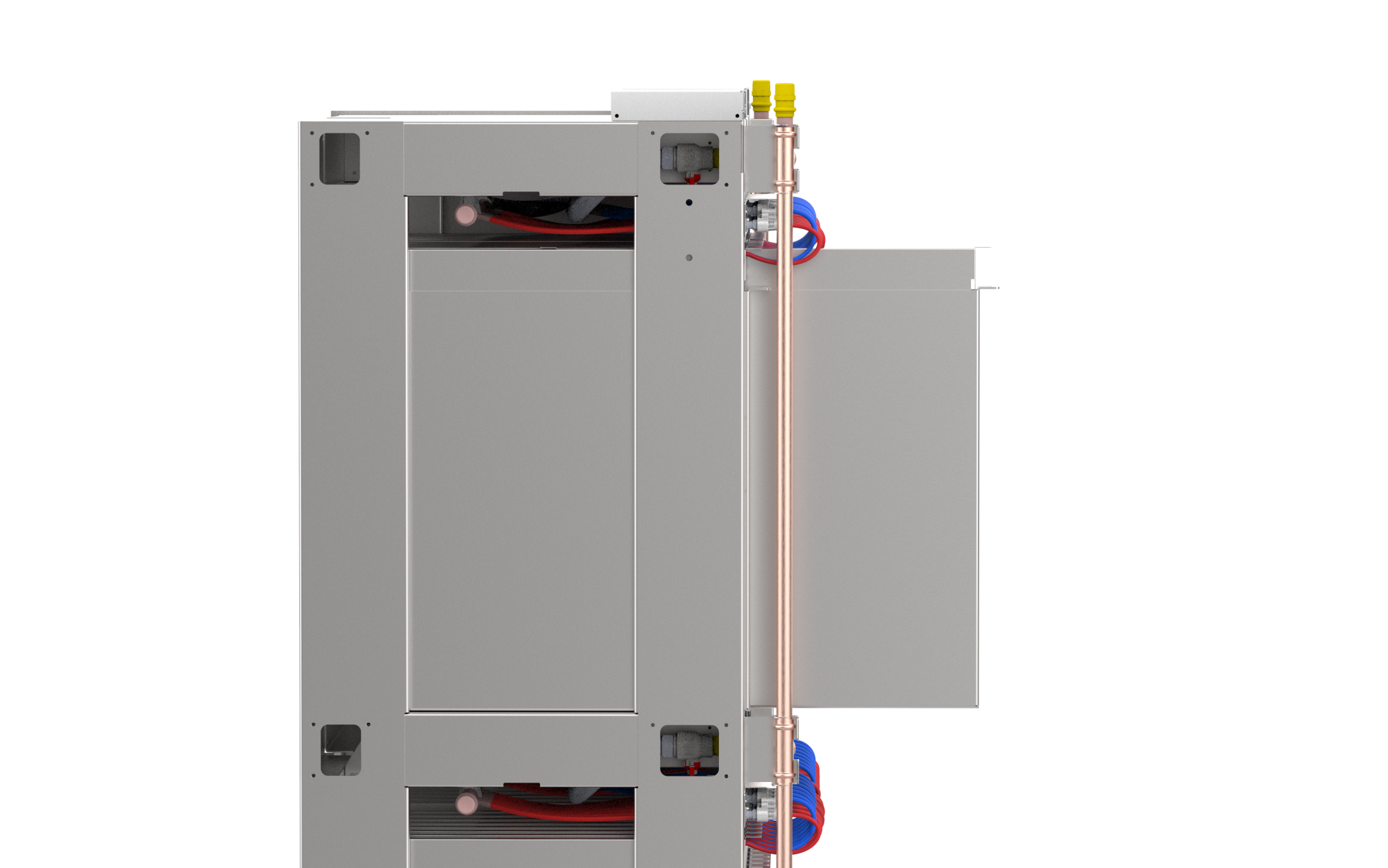

Экономия пространства и отказ от «механики»

Вынос узла распределения охлаждающей жидкости освобождает от 4U до 6U ценного пространства внутри каждой стойки, что позволяет увеличить количество эксплуатируемых серверов. При этом сам узел распределения непрерывно совершенствуется. С годами он стал значительно компактнее. Если раньше площадь фальшпола, занимаемая CDU, составляла около 2,5 м², то новой версии нужно кратно меньше: примерно 1 м². Конструкция упрощена до минимума:

- два насоса (основной и резервный);

- расходомер;

- небольшой резервуар.

«Мозг» дата-центра и роль алгоритмов

Отказ от громоздких теплообменников и сложной трубопроводной разводки позволил заменить «механику» цифровым управлением. Современный узел CDU от OVHcloud включает цифровую систему управления, оснащённую примерно 30 датчиками. Они отслеживают:

- давление;

- скорость потока;

- температуру воды;

- параметры работы стоек.

На основе этих данных система в реальном времени корректирует режимы охлаждения. Алгоритмы позволяют оптимизировать нагрузку серверов, что, по оценкам компании, продлевает срок службы оборудования и снижает общее энергопотребление дата-центра.

Внешний драй-кулер и снижение шума

Завершающим элементом системы является сухой охладитель (драй-кулер), установленный за пределами машзала и оснащенный интеллектуальным блоком управления. Он охлаждает жидкость после прохождения всего контура. Это устройство также активно дорабатывается, что дает ощутимые результаты. Например, по сравнению с предыдущей версией:

- размеры уменьшены примерно на 50%;

- количество вентиляторов сокращено вдвое;

- снижено энергопотребление и уровень шума.

Внедрение на практике и дальнейшие планы

Первая серийная установка была развернута в дата-центре OVHcloud во французском городе Рубе. Сейчас система обслуживает отдельный машзал из 60 стоек и около 2 000 серверов. Все вычислительные узлы эксплуатируются с использованием одного блока распределения охлаждающей жидкости.

В дальнейшем технология будет масштабирована и развернута в других ЦОД компании. Кроме того, OVHcloud рассматривает возможность лицензирования отдельных инженерных решений при поступлении запросов от других операторов дата-центров.

Итог: изменение подхода к проектированию дата-центров

Ключевым результатом проекта оказалось изменение самого подхода к проектированию дата-центров. Французы перешли от набора разрозненных инженерных решений к единой экосистеме, где многочисленные датчики, алгоритмическое управление и промышленный дизайн работают как единое целое.

Проект показателен в контексте искусственного интеллекта, который часто ассоциируется с ростом энергопотребления ЦОД. OVHcloud использует аналитические алгоритмы ИИ для сокращения потребления воды и электроэнергии. Это демонстрирует, что эффективность дата-центра всё чаще определяется не только «железом», но и архитектурой управления.

Всего комментариев: 0