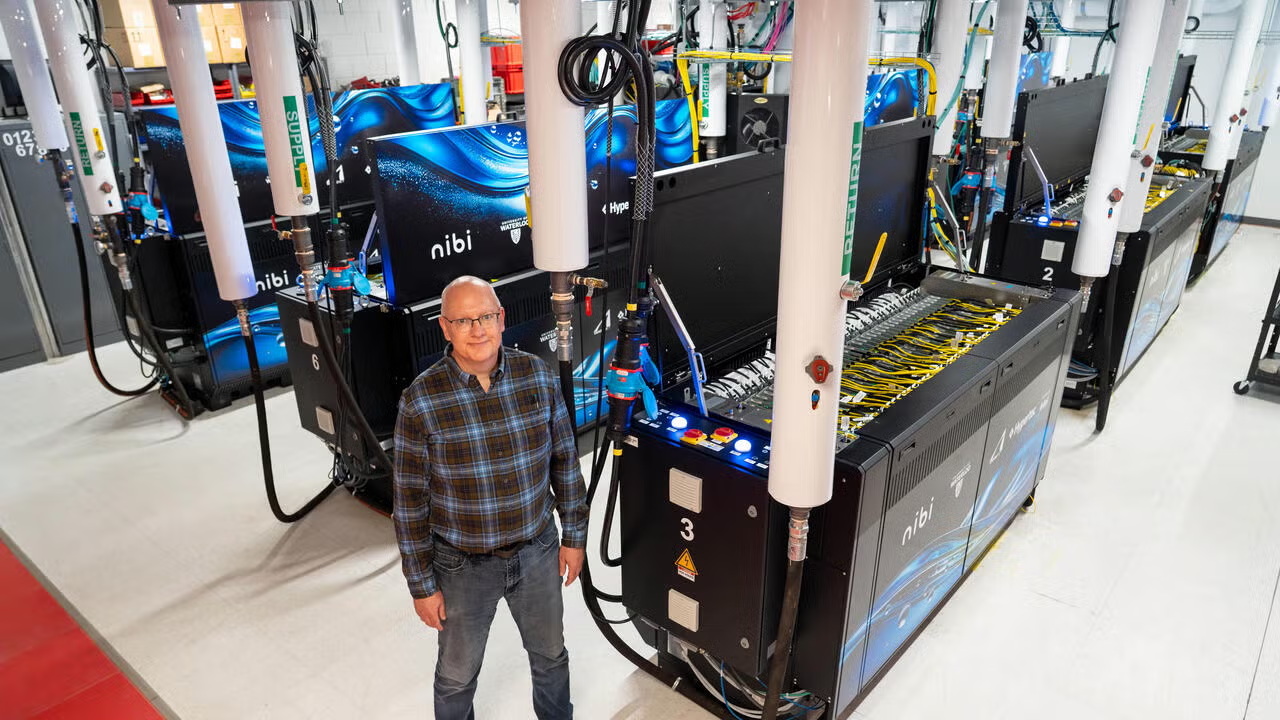

Фотоотчет о Nibi: как устроен первый в Канаде суперкомпьютер с иммерсионным охлаждением?

При развертывании инфраструктуры ЦОД для обслуживания искусственного интеллекта (ИИ) и выполнения высокопроизводительных вычислений (ВПВ) главным ограничителем все чаще становится банальная физика: для повышения производительности нужно наращивать плотность IT-оборудования внутри стоек и его мощность, что заставляет инженеров пересматривать подходы к охлаждению и все более рационально использовать доступную площадь здания.

Если не научиться стабильно и экономно удалять тепло, можно не мечтать о современных ИИ-кластерах. Рассмотрим, как эта проблема решается на практике на примере нового канадского суперкомпьютера Nibi на кампусе Университета Ватерлоо (University of Waterloo).

Зачем канадцам новый суперкомпьютер?

Отправная точка проекта – суперкомпьютерная система Graham, жизненный цикл которой подошел к завершению. Потребовалась замена, рассчитанная на современные профили нагрузок и долгие вычислительные сессии. При этом проектировщикам пришлось учитывать ограничения по доступной площади и энергоснабжению, а также более жесткие требования регуляторов в части углеродного следа: требовалось повысить эксплуатационную эффективность.

Комплекс ориентирован на широкое академическое сообщество и междисциплинарные проекты, предполагающие как классические расчеты, так и ИИ-задачи. Основные профили нагрузок:

- моделирование и эксперименты;

- аналитическая обработка больших данных;

- обучение крупных моделей и сопутствующие расчеты в рамках проектов в сфере ИИ.

Кто участвовал в проекте?

- Университет Ватерлоо. Кампус учебного заведения выступил площадкой для развертывания суперкомпьютерного комплекса. На местную администрацию легла ответственность не только за «железо», но и за инженерную составляющую проекта: электропитание, охлаждение, эксплуатационные регламенты и масштабирование мощностей.

- SHARCNET. Этот консорциум, объединяющий местные исследовательские организации, считается основным пользователем вычислительных ресурсов.

- Hypertec. Компания Hypertec выступила технологическим партнером, занимаясь проектированием, сборкой и интеграцией IT-оборудования и инженерных подсистем.

- Nokia. Инженеры Nokia занимались проектированием и развертыванием сетевой инфраструктуры для нужд вычислительного кластера.

IT-архитектура комплекса: вычислительные узлы, ускорители, хранилище

Основа комплекса — вычислительные узлы на процессорах Intel Xeon 6. Конфигурация включает более 700 узлов и рассчитана на параллельные расчеты и устойчивую работу при длительной нагрузке и больших очередях заданий.

Для ресурсоемких ИИ-задач и вычислений с высокой степенью параллелизма предусмотрены GPU-ускорители NVIDIA H100 в количестве 288 единиц. Также предусмотрено хранилище данных общей емкостью более 25 петабайт, построенное полностью на твердотельных накопителях.

Жидкость как ключевой компонент системы охлаждения

Канадские инженеры отмечают, что при росте плотности мощности IT-систем в стойках воздух становится узким местом по трем причинам:

- теплоемкость и теплопередача: чтобы удалить большее количество тепла, приходится резко наращивать расход воздуха, а это – шум, энергозатраты и усложнение схем воздушных потоков;

- локальные «горячие зоны«: при плотной компоновке возникают зоны перегрева, которые трудно стабилизировать без перерасхода электроэнергии;

- пределы масштабирования: чем выше плотность мощности, тем сильнее охлаждение начинает диктовать планировку машзала и ограничивать инженеров при размещении оборудования.

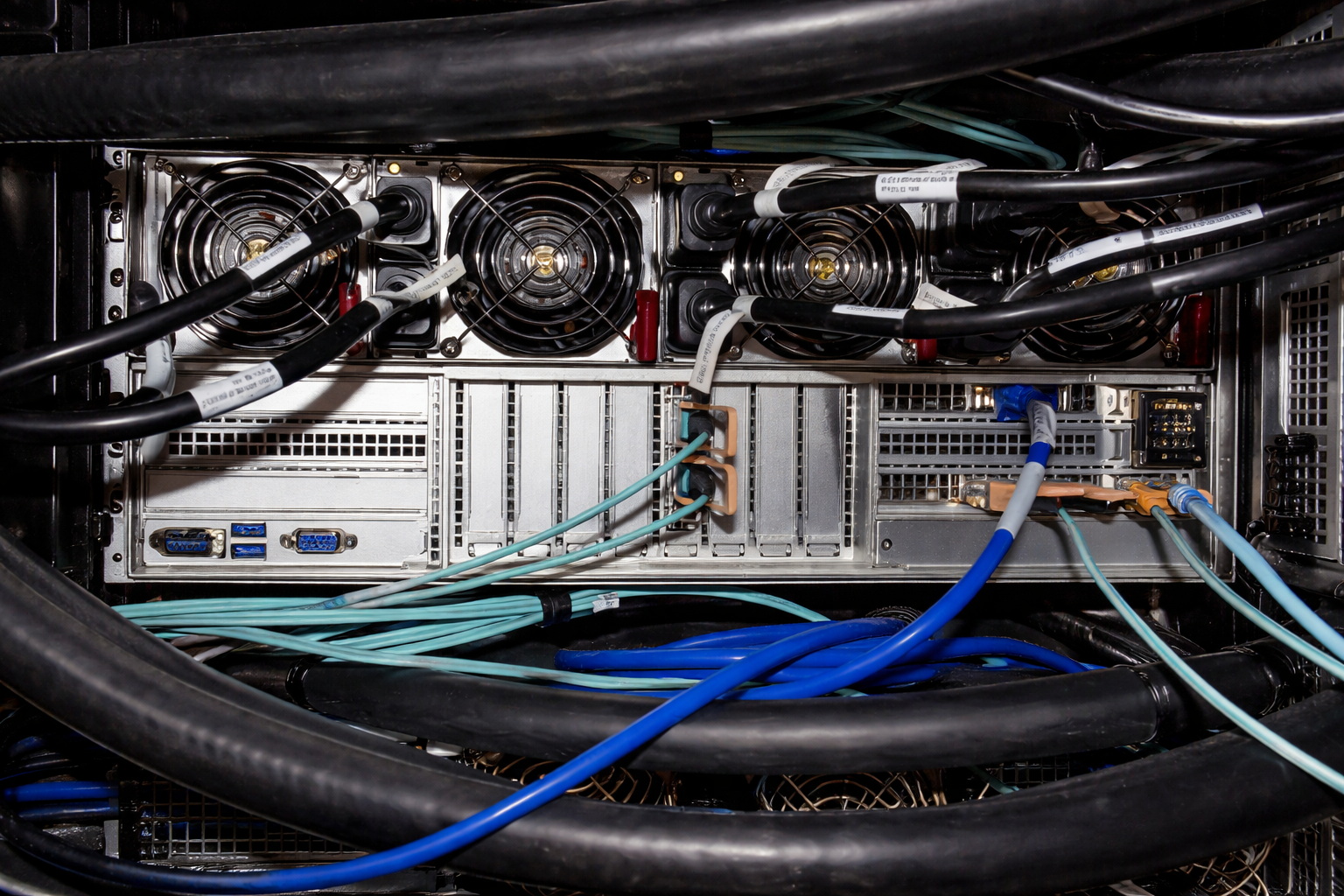

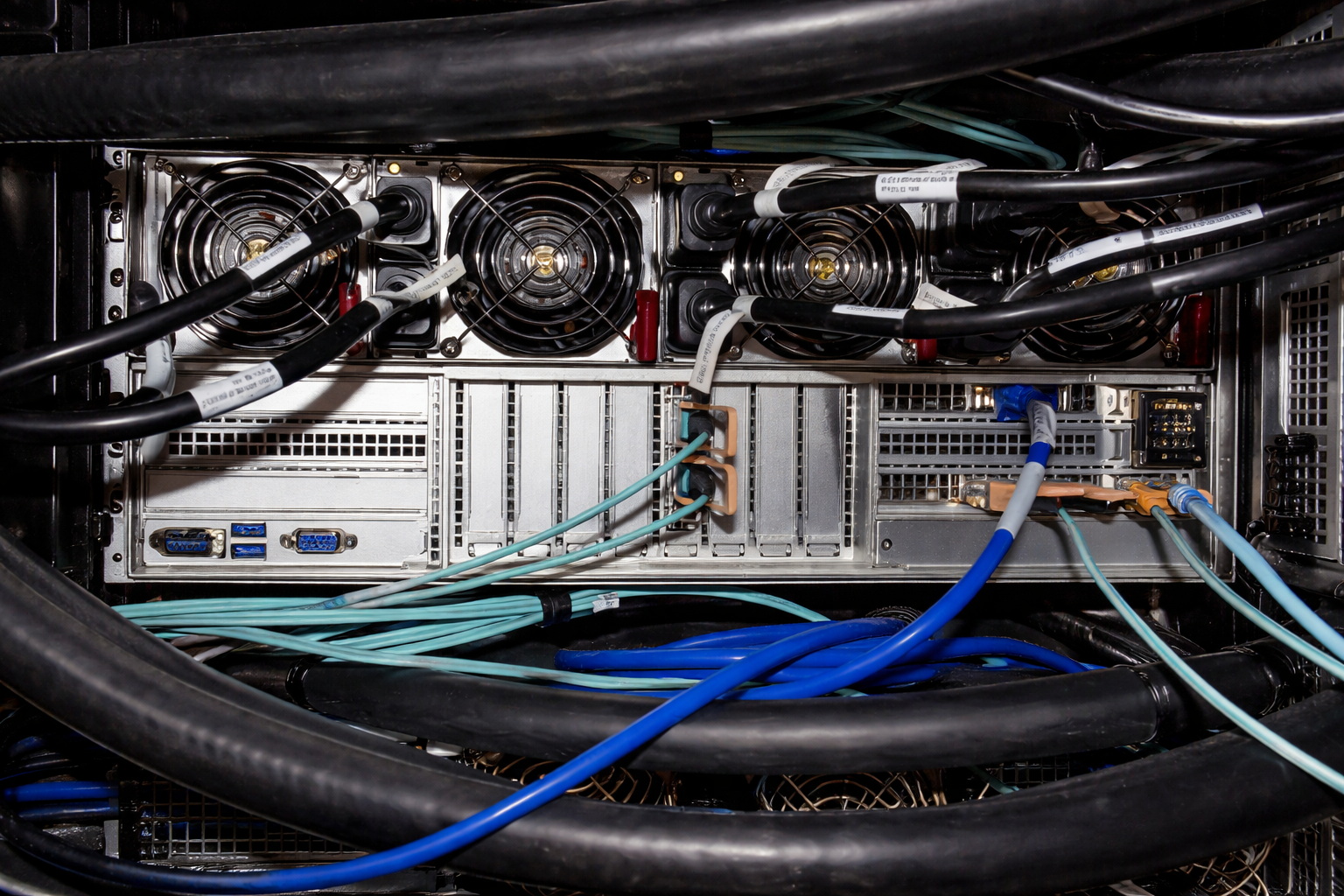

В комплексе Nibi ставка была сделана на жидкостное охлаждение двух типов:

- однофазное иммерсионное: вычислительные компоненты размещаются в иммерсионных резервуарах, где тепло удается непосредственно жидкостью – без фазового перехода;

- прямоконтактное для ускорителей: тепло от наиболее горячих компонентов GPU-подсистем удаляется напрямую через охлаждающие пластины, по которым циркулирует жидкий хладагент в рамках отдельного контура.

Что это дает в контексте эксплуатации? Такой подход обеспечивает стабильность под постоянной нагрузкой на всех узлах в целом и, в частности, на ускорителях. Минимизируется число локальных перегревов и связанных с ними просадок производительности. Достигается более предсказуемая работа при длительных заданиях, которые характерны для обучения крупных ИИ-моделей.

Размещение в существующем здании: масштабирование без нового строительства

Суперкомпьютер Nibi разместили в существующем корпусе факультета математики и компьютерных наук Университета Ватерлоо. То есть проект изначально осуществляли с оглядкой на реальные ограничения действующей площадки, не планируя строить машзалы «с нуля». Это обеспечило сразу несколько преимуществ для оператора и пользователей:

- ускоренный ввод в эксплуатацию: меньше этапов, связанных со стройкой и согласованиями;

- контроль затрат: деньги уходят на вычислительные и инженерные системы, а не на расширение площадей.

Сетевая инфраструктура

Для суперкомпьютерного комплекса сеть — одна из ключевых детерминант производительности: именно она связывает вычислительные узлы, ускорители и хранилище в единый контур. Канадцы использовали межсоединения на базе Ethernet в качестве основы сетевой архитектуры кластера.

Такой подход упрощает масштабирование системы по мере увеличения числа узлов и объемов данных: сеть проще наращивать без полной перестройки архитектуры. Упрощается эксплуатация: больше доступных инструментов мониторинга и диагностики, а также типовых практик обслуживания. Ethernet-архитектура также дает предсказуемость при одновременной работе разных классов задач.

Энергоэффективность и повторное использование тепла

Устойчивость и экономичность заложены в саму архитектуру Nibi. Ставка на жидкостное охлаждение обеспечила значительное снижение энергозатрат (вплоть до 50%), связанных с оптимизацией температурного режима, по сравнению с воздушными системами.

Плотность вычислительной мощности выросла примерно на 40%. Более того, поскольку тепло удаляется жидкостью, а не воздухом, оно впоследствии используется как ресурс, а не превращается в отход. Излишки тепловой энергии перенаправляются на обогрев исследовательского центра Mike and Ophelia Lazaridis Quantum-Nano Centre. В результате годовая экономия на энергозатратах составляет более 150 000 долларов.

Пример для подражания?

Суперкомпьютер Nibi важен не рекордами по количеству петафлопс или другим параметрам, которых здесь нет, а демонстрацией возможности масштабного внедрения комбинации однофазного иммерсионного и прямоконтактного охлаждения. Обе технологии применены не в рамках пилотного проекта, а в рабочем суперкомпьютерном комплексе с сотнями узлов, GPU и большим хранилищем данных. Для субъектов сектора ЦОД это означает, что жидкостные схемы уже можно рассматривать как отраслевой стандарт для высокоплотных нагрузок, а не как перспективную технологию, пригодную исключительно для экспериментов.

Инженерная логика проекта проста и прагматична: жидкость удаляет тепло там, где оно возникает, исключая перерасход электричества и снижая риск локальных перегревов, а также провалов производительности. Итог — повышение предсказуемости системы при выполнении длительных вычислений. При этом уменьшение энергозатрат на охлаждение, повышение плотности мощности и повторное использование излишков тепла помогают канадцам экономить приличные суммы.

Всего комментариев: 0