Новые стратегии охлаждения ЦОД для повышения эффективности и снижения затрат

Какими стратегиями охлаждения центра обработки данных вы пользуетесь в настоящее время? Возможно, вы используете кондиционеры для машзалов (Computer Room Air Conditioning Unit; CRAC), которые непрерывно направляют потоки охлажденного воздуха в отверстия перфорированных пластин фальшпола, позволяя поддерживать оптимальную температуру внутри всех монтажных стоек в помещении? Если ответ «да», вы, вероятно, тратите впустую большое количество электроэнергии и денег. Есть несколько новых подходов к охлаждению ЦОД и технологий, затраты на внедрение которых могли бы окупиться за один финансовых выгод.

Какими стратегиями охлаждения центра обработки данных вы пользуетесь в настоящее время? Возможно, вы используете кондиционеры для машзалов (Computer Room Air Conditioning Unit; CRAC), которые непрерывно направляют потоки охлажденного воздуха в отверстия перфорированных пластин фальшпола, позволяя поддерживать оптимальную температуру внутри всех монтажных стоек в помещении? Если ответ «да», вы, вероятно, тратите впустую большое количество электроэнергии и денег. Есть несколько новых подходов к охлаждению ЦОД и технологий, затраты на внедрение которых могли бы окупиться за один финансовых выгод.

Во-первых, убедитесь в том, что температура в вашем дата-центре не является слишком низкой. Специалисты Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigerating and Air conditioning Engineers; ASHRAE) разрабатывают рекомендации по допустимым температурам эксплуатации серверного и сетевого оборудования ЦОД разных классов с 2004 года.

В 2004 году максимальная допустимая температура эксплуатации IT-оборудования была установлена ими на уровне 77 градусов по Фаренгейту (25 градусов по Цельсию). В 2008 году этот пороговый показатель вырос до 81 °F (27 °C). В 2011 году специалисты ASHRAE пересмотрели свои рекомендации. Рекомендуемую температуру они оставили на уровне 81 °F (27 °C), но при этом они увеличили максимально допустимую температуру (при превышении которой происходит резкое увеличение интенсивности отказов оборудования) до 113 °F (45 °С). Вооружившись этими рекомендациями, вы можете сопоставить свои потребности и риски, связанные с повышением температуры эксплуатации IT-оборудования внутри ЦОД, и по возможности снизить мощность системы охлаждения. Это позволит уменьшить число блоков CRAC и, как следствие, значительно сократить затраты на электроэнергию.

На самом деле наиболее простым способом сократить расходы на эксплуатацию ЦОД является именно снижение количества работающих блоков CRAC. Примечательно, что если за счет повышения температуры эксплуатации IT-оборудования можно будет снизить требования к холодопроизводительности, например, в два раза, то ставшее возможным при этом отключение половины блоков CRAC обернется не только прямой экономией на оплате счетов за электроэнергию, но и значительным снижением расходов на техническое обслуживание системы охлаждения ЦОД.

Использование кондиционеров с частотно-регулируемыми (инверторными) приводами (речь о двигателях компрессора) вместо блоков CRAC с работающими на фиксированной скорости приводами является еще одним способом достижения вышеозначенной цели. Приводы в подобных устройствах могут функционировать именно на той скорости, которая необходима для поддержания заданной температуры.

Также необходимо помнить, что блоки CRAC работают эффективнее всего только тогда, когда они загружены на 100%, поэтому даже инверторные кондиционеры теряют эффективность при работе с частичной нагрузкой. Использование стандартных блоков CRAC, двигатели компрессоров внутри которых работают на фиксированной скорости, чтобы достичь так называемой «тепловой инерции», может быть наиболее эффективным с экономической точки зрения вариантом. В данном случае дата-центр охлаждается значительно ниже заданной температуры с помощью стандартных блоков CRAC, после чего они выключаются. Затем ЦОД постепенно нагревается. Это происходит до тех пор, пока температура не достигнет определенного уровня, после чего блоки CRAC снова включаются. Благодаря этому процессу блоки запускаются при полной нагрузке и работают на самом высоком уровне операционной эффективности.

Тем не менее, столь упрощенные и масштабные подходы к охлаждению дата-центра не позволяют свести расточительное использование ресурсов к минимуму – независимо от того, каким именно образом осуществляется начальное охлаждение воздуха. Все потому, что большинство охлажденного воздуха не вступает в достаточно тесный контакт с IT-оборудованием, чтобы эффективно его охладить.

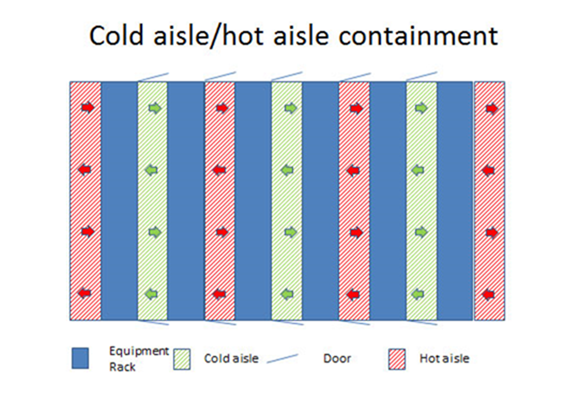

Рисунок 1. «Горячий» и «холодный» коридоры.

Продолжаем охлаждать ЦОД с помощью воздуха

Использование «горячих» и «холодных» коридоров, позволяет уменьшить объем нагнетаемого в монтажные стойки охлаждающего воздуха, если они реализованы должным образом (см. рисунок 1). Промежутки между монтажными стойками изолируются с помощью «крыши», расположенной над стойками, и дверей с обоих концов. Холодный воздух нагнетается в замкнутое пространство и попадает в стойки. С помощью изоляционных фальш-панелей предотвращаются утечки холодного воздуха изнутри стоек. Воздуховоды внутри стоки направляют холодный воздух к самым горячим элементам IT-оборудования. Цель в данном случае состоит в том, чтобы снабдить каждую монтажную стойку своей собственной системой изоляции воздуходув, что позволят свести к минимуму объем воздуха, который требуется для охлаждения IT-оборудования.

Горячий воздух удаляется из стоек либо непосредственно во внутренние помещение ЦОД, а затем наружу, либо используется для нагрева других помещений с помощью механизмов рекуперации тепловой энергии. Горячий воздух также может быть использован для нагрева воды с помощью теплового насоса. Следует отметить, что эти системы изоляции воздуховодов могут быть весьма сложны в реализации, но их внедрение позволяет добиться значительного повышения эффективности системы охлаждения серверного оборудования.

В некоторых регионах с благоприятным климатом помимо эксплуатации оборудования при более высоких температурах есть возможность использовать наружный воздух для охлаждения серверов (фрикулинг), что практически полностью устраняет необходимость в блоках CRAC. Например, если операторы ЦОД решат эксплуатировать оборудование при температуре в 86 °F (30 °C), при этом температура наружного воздуха будет ниже 77 °F (25 °C), то внедрение механизма фрикулинга позволит отказаться от дополнительного охладительного оборудования – пока уровни температуры и влажности поступающего извне воздуха остаются в требуемых границах.

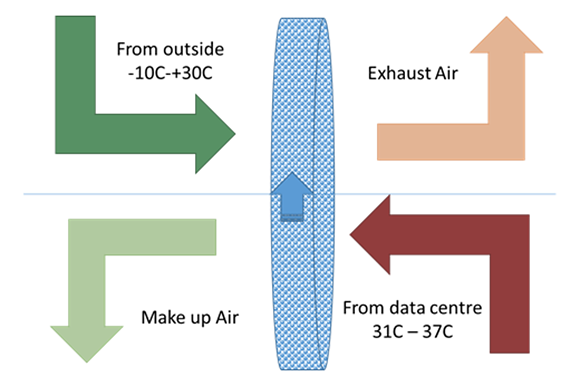

Рисунок 2. Kyoto Wheel.

Тем не менее, базовый подход к оптимизации температурного режима внутри ЦОД с помощью фрикулинга, предполагающий простое нагнетание через воздуховоды холодного воздуха снаружи, может привести к частичному падению эффективности и даже выходу оборудования из строя. Причинами в данном случае выступает появление «горячих точек» в машзалах или попадание в дата-центр пыли и загрязняющих веществ. Ситуацию спасают новые технологии вроде Kyoto Wheel (см. рисунок 2).

В общих чертах принцип работы системы Kyoto Wheel выглядит следующим образом: колесо из гофрированного металла диаметром около 3 метра (10 футов) медленно вращается в двухкамерном блоке. Горячий воздух из дата-центра проходит через одну камеру, передавая свое тепло металлу колеса. Холодный наружный воздух проходит через другую камеру и принимает тепло от металла, после чего уносит его за пределы здания ЦОД. Охлажденный воздух из колеса подается обратно в машзалы дата-центра и используется для охлаждения IT-оборудования.

По сути, воздушный контур внутри дата-центра замкнут. При этом непрерывно вращение колеса гарантирует, что лишь очень малое количество твердых частиц или влаги будут перемещаться из одной камеры в другую. Иными словами, само колесо частично выступает в качестве фильтра. Главное преимущество подобной системы заключается в том, что низкоскоростные вентиляторы и двигатели, используемые в системе охлаждения на базе Kyoto Wheel, требуют минимального техобслуживания. При этом система в целом работает при очень небольших затратах электроэнергии (зачастую ее используют в связке с солнечными панелями и резервной системой хранения энергии на базе аккумуляторных батарей). Подобное решение может эффективно эксплуатироваться в течение многих лет (вендор заявляет о продолжительности службы в районе 25 лет), и ее техобслуживание может сводиться к несложной и довольно быстрой очистке колеса каждые несколько месяцев, а также к стандартному обслуживанию двигателей.

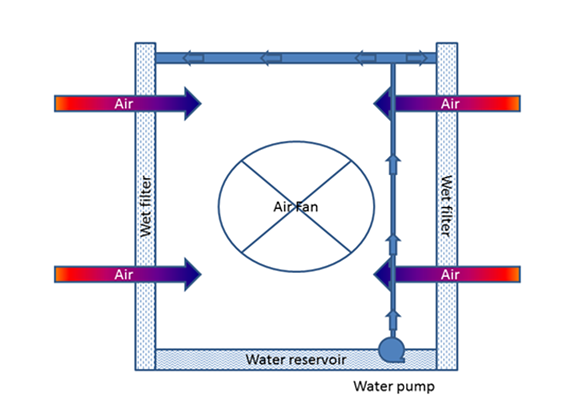

Рисунок 3. Система жидкостного охлаждения.

Когда нет холодного воздуха, попробуйте воду

Помимо вышеописанных методов оптимизации температурного режима IT-оборудования с помощью воздушных потоков, есть и другие подходы к охлаждению серверов. Одним из них является адиабатическое охлаждение, которое предполагает использование охлаждающего эффекта испаряющейся воды (см. Рисунок 3). Водяное охлаждение эффективнее всего в случае размещения ЦОД в регионе с относительно теплым климатом, где нагретый воздух извне может подаваться на мокрые фильтры (промывные камеры), испаряя воду и охлаждая воздушные массы, поступающие изнутри здания и проходящие через фильтры. Этот подход предполагает использование двухкамерной системы для организации теплообмена, в которой фильтры обеспечивают разделение между наружным воздухом извне и воздухом из внутренней части дата-центра. Тем не менее, отработавшие свое фильтры должны регулярно заменяться на новые для удаления загрязняющих частиц. Кроме того, периодически может возникать необходимость корректировки концентрации влаги в воздухе, чтобы предотвратить образование конденсата на IT-оборудовании.

Компаниям, которые хотят воспользоваться преимуществами высокоплотного размещения горячего IT-оборудования в замкнутом машзале, должна пригодиться технология прямого жидкостного охлаждения. Одним из развивающих эту концепцию вендоров является IBM, при этом инженеры компании сумели продвинуть дальше других в области оптимизации СЖО для высокоплотных вычислительных систем. Яркими примерами их достижений могут служить суперкомпьютерные системы Aquasar и SuperMUC. В ходе разработки этих систем специалистам IBM удалось решить проблемы, которые возникают, когда вода из СЖО оказывается соседству с электроникой и энергетическим оборудованием внутри дата-центра. В системе жидкостного охлаждения “Голубого гиганта” для организации непрерывной циркуляции хладагента по контуру вместо насосов используется отрицательное (вакуумметрическое) давление. Благодаря этому в случае возникновения протечки в систему начинает втягиваться воздух, и вода не попадает из контура в машзал ЦОД. Чтобы быстро определить, где произошла протечка, используются продвинутые датчики. При этом модульная конструкция СЖО позволяет ремонтировать отдельные ее элементы, в то время как остальная часть системы продолжает исправно функционировать.

В контур таких СЖО подается теплая вода, выступающая охлаждающей жидкостью, что может показаться странным. Но благодаря особенностям конструкции системы вода при температуре более 86 °F (30 °C) может эффективно охладить процессоры, позволяя в точности соблюдать эксплуатационные параметры. Температура воды на выходе может достигать около 113 °F (45 °С). Высокая температура воды в сочетании с эффективными теплообменниками позволяет использовать горячую воду для технических нужд в других частях здания. Иными словами, кроме снижения потребления электричества примерно на 40% эта СЖО может обеспечить дополнительную экономию энергии благодаря возможности использования выделяемого серверами тепла для организации горячего водоснабжения и отопления остальной части здания ЦОД.

Устройте “железу” охлаждающую ванну

Еще более эффективной и надежной разновидностью жидкостного охлаждения является иммерсионное охлаждение или охлаждение погружением. Компании вроде Iceotope и Green Revolution Cooling разрабатывают решения, которые позволяют погружать в диэлектрический хладагент весь сервер — или другие элементы IT-оборудования. Оба вендора используют специальные жидкости с высокой теплопроводностью. Их продукты являются идеальным решением для охлаждения GPU-ускорителей (графических сопроцессоров) внутри многосокетных серверов с сотни физических ядер, работающих в конфигурациях с высокой плотностью размещения оборудования. Ключевыми элементами систем иммерсионного охлаждения являются специальные резервуары размером с монтажную стойку, внутри которых может быть размещено оборудование мощностью более 100 кВт. Некоторые системы охлаждения погружением в настоящее время работают при температуре жидкости в 140 °F (60 °C).

Системы иммерсионного охлаждения серверов прекрасно функционируют без вентиляторов, что позволяет экономить дополнительную электроэнергию. Поскольку специализированные жидкие хладагенты гораздо лучше удаляют тепло, чем воздух или вода, IT-оборудование может работать при более высоких температурах. Кроме того, конструкция этих систем допускает рекуперацию тепла из жидкости для обеспечения горячего водоснабжения или нагрева остальной части здания дата-центра.

Дата-центр охлажден, теперь что?

Перечисленные выше системы способны обеспечить эффективное охлаждение IT-оборудования различной мощности, работающее в различных условиях окружающей среды. Тем не менее, чтобы контролировать все тепловые аспекты ЦОД, его операторам необходимо дополнительно внедрять эффективное системы мониторинга на базе всевозможных тепловых датчиков и детекторов инфракрасного излучения. Повысить эффективность обработки поступающей с сенсоров информации позволяет программное обеспечение для управления инфраструктурой дата-центра (Data Center Infrastructure Management; DCIM). С помощью DCIM-решения операторы ЦОД могут оперативно составить карту «горячих точек» и соответствующим образом оптимизировать систему охлаждения.

Добавив в этот коктейль ПО для вычислительной гидродинамики (CFD) и механизмы предиктивного планирования с поддержкой сценариев типа «что-если?», можно будет увидеть, как при модификации системы воздуховодов будут распределяться потоки охлажденного воздуха. Кроме того, это позволит понять, как изменение температуры подаваемого в машзал охлажденного воздуха или подводимого в контур СЖО хладагента будет отражаться на состоянии различных серверных систем.

Продолжение активного мониторинга температурного режима ЦОД после внедрения DCIM-решения гарантирует, что операторы дата-центра смогут быстро локализовать новые «горячие точки», появившиеся по причине сбоя в работе или полного отказа того или иного элемента системы охлаждения, и при необходимости быстро их заменить. Следует помнить, что возможность заменить элемент системы охлаждения еще до его отказа, которую дают некоторые DCIM-решения, позволяет максимизировать время безотказной работы дата-центра.

Сегмент ЦОД продолжает меняться, и внедрение все более передовых систем охлаждения может избавить операторов серверных ферм от неоправданно высоких расходов на эксплуатацию подконтрольных объектов. Объединение новых руководящих принципов с передовыми подходами к охлаждению IT-оборудования также позволяет минимизировать затраты на техническое обслуживание и рациональнее вкладывать деньги в расширение вычислительных мощностей.

Всего комментариев: 0