Японцы создали модульный ЦОД будущего

Инженеры из Страны восходящего солнца представили модульный контейнерный центр обработки данных следующего поколения. Главным козырем этого ЦОД является продвинутая многоконтурная система охлаждения: тепло из безвентиляторных серверных систем удаляется с помощью знаменитого хладагента Novec от компании 3М (внутренний контур) и воды (внешний контур), которая после нагрева поступает в водно-воздушный теплообменник, сообщающийся с градирней. При этом остальную электронику охлаждает высокотехнологичный блок приема наружного воздуха Green Unit (на фото в начале статьи – зеленый блок справа), о котором мы расскажем ниже.

Инженеры из Страны восходящего солнца представили модульный контейнерный центр обработки данных следующего поколения. Главным козырем этого ЦОД является продвинутая многоконтурная система охлаждения: тепло из безвентиляторных серверных систем удаляется с помощью знаменитого хладагента Novec от компании 3М (внутренний контур) и воды (внешний контур), которая после нагрева поступает в водно-воздушный теплообменник, сообщающийся с градирней. При этом остальную электронику охлаждает высокотехнологичный блок приема наружного воздуха Green Unit (на фото в начале статьи – зеленый блок справа), о котором мы расскажем ниже.

Заслуживает внимания и тот факт, что для запитки всего серверного, сетевого и вспомогательного оборудования здесь используется не переменный ток, а постоянный ток высокого напряжения, что позволяет повысить общий КПД системы распределения электроэнергии. Японцы также разработали специальное программное обеспечение, используемое для консолидации серверов и автоматического отключения / включения вычислительных узлов по мере необходимости. Результатом стал гораздо более энергоэффективный ЦОД по сравнению со стандартными модульными дата-центрами, которые в настоящее время доступны на рынке.

Новый модульный контейнерный дата-центр является детищем команды ученых из Национального института передовых научных исследований и технологий (National Institute of Advanced Industrial Science and Technology; AIST) Японии во главе с профессором Сатоши Ито. Поддержку ученым оказывала группа местных компаний, в состав которой вошли такие гранды IT-индустрии как NEC, NTT Facilities и Mitsubishi Electric. Профинансировало проект, главной целью которого было создание инновационных технологий для снижения энергетических потребностей индустрии ЦОД в будущем, непосредственно японское правительство.

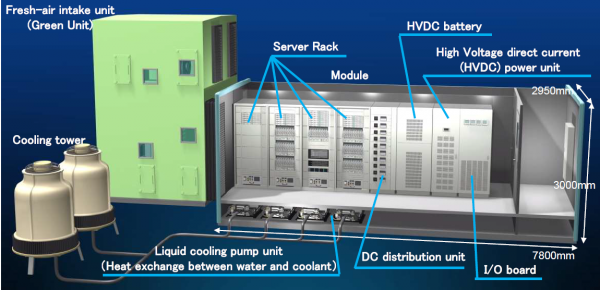

Примечательно, что специалисты AIST разрабатывали экологичный модульный контейнерный ЦОД на базе обычного аналога. Обе модели модульных дата-центров имеет одинаковую высоту и ширину (примерно 3 x 3 метра), но при этом они отличается друг от друга длиной (7.8 против 9 метров) и наличием / отсутствием того самого зеленого блока приема наружного воздуха Green Unit.

Схема модульного ЦОД от исследователей из AIST

«За основу мы взяли стандартный модульный контейнерный дата-центр, который имеет 20 серверных узлов высотой 1U, семь корзин для блейд-серверов (в общей сложности 56 блейдов) и один корпус для сетевых коммутаторов. Все IT-оборудование рассредоточено по четырем серверным стойкам. Никаких изменений в вычислительную инфраструктуру не вносилось, за исключением оптимизации под СЖО. Базовая версия модульного ЦОД содержала два стоечных кондиционера, которые были удалены. Кроме того, там присутствовали обычные внутристоечные системы распределения электропитания и внутристоечные источники бесперебойного питания (ИБП). Электроэнергетическая инфраструктура базовой модели была адаптирована под переменный ток», отметил Ито. Он также добавил, что коэффициент эффективности использования энергии (Power Usage Effectiveness; PUE) базовой модели модульного контейнерного дата-центра составлял 1.33 единицы.

Как уже отмечалось выше, новый «зеленый» модульный дата-центр японцев содержит все те же серверные системы, но конструкция их корпусов была незначительно изменена с прицелом на использование системы жидкостного охлаждения. Кроме того, из серверов была демонтирована часть вентиляторов.

Жидкостное охлаждение: безвентиляторные серверы выстой 1U внутри монтажной стойки

Жидкостное охлаждение: корзина для блейд-серверов

«Мы удалили некоторые вентиляторы и добавили водяные рубашки из алюминия для охлаждения процессоров (речь об устанавливаемых на серверные процессоры теплообменниках)», говорит Ито. «Для организации циркуляции хладагента к водяным рубашками были подключены гибкие трубки. При этом с помощью системы жидкостного охлаждения мы решили удалять тело не только от находящихся в наших серверах процессоров, но и от блоков VRM (Voltage Regulator Module или модуль регулятора напряжения; этот блок необходим для формирования нужных напряжений питания CPU). К слову, система жидкостного охлаждения, которую мы взяли на вооружение, была разработана японской компанией SOHKI».

Первичный контур системы жидкостного охлаждения модульного ЦОД японцев также содержит несколько насосов и теплообменников типа жидкость-жидкость, которые установленный под монтажными стойками. Тепло от серверов передается от первичного теплоносителя (напомним, что в данном случае хладагентом выступает вещество Novec) воде, а затем нагретая вода направляется к градирне, установленной снаружи контейнера.

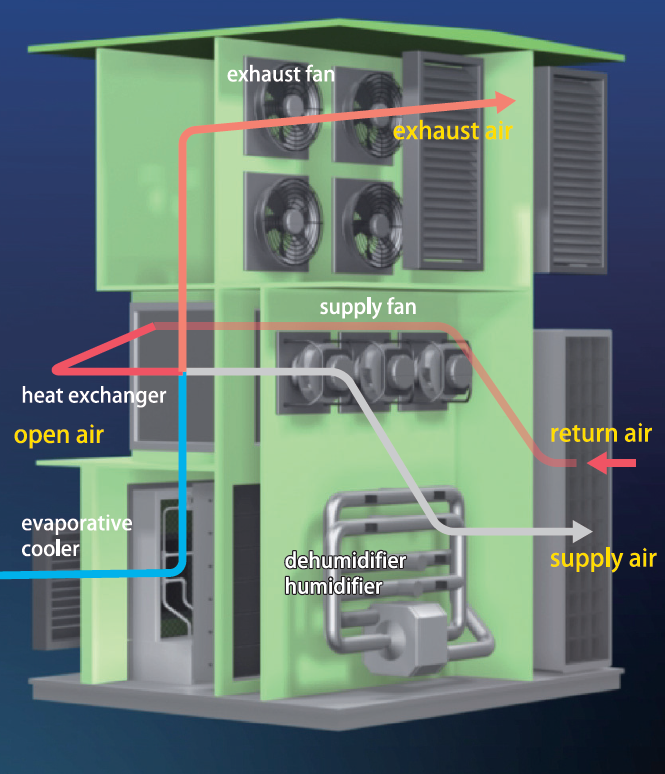

По словам Ито, результаты испытания нового “зеленого” дата-центра показывают, что при внедрении жидкостного охлаждения можно сэкономить значительно количество электроэнергии. Профессор также отмечает, что на долю процессоров приходится около 70-80% всего тепла, выделяемого серверами. И эта тепловая энергия благополучно удаляется с помощью СЖО. Остальное тепло, которое выделяется сетевыми картами, модулями оперативной памяти, жесткими дисками и другими комплектующими, удаляется с помощью блока Green Unit. В последнем установлен массив мощных вентиляторов для нагнетания воздуха в блок, при этом воздушные массы непрерывно циркулируют внутри воздуховодов и монтажных стоек благодаря возникающей разности давлений воздуха.

«Кроме того, нам удалось значительно упростить процесс управления влажностью. Возвратный воздух (обратный / отработанный воздушный поток) из «горячего» коридора подается в «холодный» коридор машзала после удаления излишнего тепла через теплообменник типа воздух-воздух с использованием наружного холодного воздуха. При этом наружный воздух отделяется от того, что циркулирует внутри машзала. Иными словами, даже если наружный воздух содержит много влаги, вода не может попасть внутрь ЦОД. Благодаря подобному подходу нам удалось снизить требования к техническому обслуживанию для фильтров», отметил японский ученый.

«На протяжение довольно длительного периода времени мы измеряли параметры внешнего воздуха в Цукубе (центральная часть Японии), где мы строим модульные дата-центры, и в худшем случае они составляли 35 °С при 60-процентной влажности, что превышает рекомендованные параметры эксплуатации для оборудования класса ASHRAE А2. Тем не менее, даже в столь суровых условиях испарительный охладитель внутри блока Green Unit способен охлаждать подаваемый в машзал воздух до 30 °С и доводить влажность до нужного уровня. Наши серверы отлично работают при 35 °С, поэтому мы не нуждались в дополнительном кондиционировании воздуха для их охлаждения «, говорит Ито.

Удаление тепла с помощью блока Green Unit

Для дальнейшего повышения энергоэффективности своего модульного ЦОД японцы также использовали специальное программное обеспечение для динамического предоставления вычислительных мощностей конечным пользователям. Так, если нагрузка на дата-центр невелика, с помощью этого ПО серверы могут быть консолидированы (объединены), а в некоторых случаях и отключены от электрораспределительной сети. Еще одним достоинством новинки является использование для запитки IT- и вспомогательного оборудования постоянного тока высокого напряжения (при 380 В), что устраняет необходимость неоднократного преобразования постоянного тока в переменный ток внутри ЦОД, ведущего к потере мощности.

Новый модульный контейнерный дата-центр может похвастать коэффициентом PUE в 1.16 единицы. Эксперты отмечают, что было достигнуто снижение общего потребления электроэнергии примерно на 30% по сравнению с базовой моделью. Сейчас команда японских ученых занимается проектированием внешней оболочки, которая позволит эффективнее контролировать климат (температуру и влажность воздушных потоков) внутри их модульного дата-центра.

«Мы планируем создать механизм, который позволит менять температуру внутри машзала в пределах от -10 ° C до 35 °С при возможности изменения уровня влажности от 5% до 100%. Затем мы собираемся протестировать улучшенный дата-центр в северных или южных районах Японии «.

Всего комментариев: 0