Гонка вооружений дата-центров

Спокойная сельская местность в окрестностях реки Колумбия на северо-западе Соединенных Штатов стала местом крупного и, возможно, неожиданного противостояния между Интернет-гигантами. Именно там Google, Microsoft, Amazon и

Yahoo построили крупнейшие в мире и наиболее современные компьютерные центры: гигантские помещения с десятками тысяч серверов, являющиеся движущей силой следующего поколения Интернет-приложений. Впору назвать это гонкой вооружений дата-центров.

Данный регион привлек компании в силу дешевизны земли, наличия оптоволоконных каналов, достаточного количества воды, и, что еще более важно, недорогой электроэнергии. Сегодня эти факторы являются наиболее важными при строительстве крупных дата-центров, размеры и энергопотребление которых превосходят свои ранние аналоги на один или даже два порядка.

Эти новые дата-центры физически олицетворяют то, что Интернет-компании называют «облачными вычислениями». Идея заключается в следующем – распределенная сеть серверов, систем хранения данных и сетевого оборудования образует единую инфраструктуру для удаленной работы приложений и хранения данных, в то время как персональные компьютеры пользователей будут не более чем интерфейсом для взаимодействия с получившим новые возможности Интернетом.

Все это означает, что удаленные дата-центры, ранее являвшиеся незначительными и второплановыми игроками технического мира, теперь начинают играть ведущую роль. Однако эффективная разработка их конструкции, режима эксплуатации, определение местонахождения – сложнейшая задача. Инженеры, разрабатывающие современные масштабные дата-центры (их также называют Интернет-дата-центры, чтобы обозначить отличие от более ранних объектов), используют множество новых стратегий и технологий для сокращения строительных и эксплуатационных расходов, уменьшения энергопотребления, использования более экологичных материалов и процессов, и, в целом, создания более гибких и легко расширяемых объектов. Помимо прочего, в дата-центрах используется современное оборудование для управления питанием, водные системы охлаждения и более компактные конфигурации серверов, что в итоге значительно отличает современные дата-центры от традиционных серверных с воздушным кондиционированием.

Рассмотрим дата-центр компании Microsoft в Квинси, штат Вашингтон. Его площадь превышает 43600 м2, что примерно равно 10 полям для американского футбола. Компания не разглашает количество размещенных там серверов, но при этом сообщает об использовании 4,8 км охлаждающих трубопроводов, 965 км электропроводки, 92900 м2 гипсокартона и полутора метрических тонн источников резервного питания. Дата-центр потребляет 48 мегаватт электроэнергии – этого достаточно для питания 40000 домов.

Yahoo, штаб-квартира которого располагается в Саннивэйл, Калифорния, также выбрал небольшой городок Квинси (население 5044 жителей, расположен в долине, заполненной картофельными фермами) для размещения новейшего дата-центра площадью 13000 м2 – второй дата-центр компании в данном регионе. Компания рассчитывает эксплуатировать оба дата-центра без каких-либо выбросов в атмосферу за счет использования, помимо прочего, гидроэлектроэнергии, систем водного и воздушного охлаждения. Как отметили некоторые обозреватели, картофельные фермы понемногу вытесняются серверными.

Переместимся южнее. Google (штаб-квартира в Мантин-Вью, Калифорния) открыл огромный дата-центр на берегах реки Колумбия в Даллесе, штат Орегон. Объект состоит из двух зданий площадью по 6500 м2, причем ходят слухи о строительстве третьего здания. Так или иначе, Google пока никак не комментирует планы по расширению дата-центра. Также компания не раскрывает информацию о количестве установленных там серверов, потреблении энергии и воды. Сегодня тема дата-центров характерна интенсивным экспериментированием, так что желание компаний сохранить свои результаты в тайне вполне понятно.

Другой закрытый проект по строительству дата-центра реализуется в ста километрах к востоку – в Бордмане, штат Орегон. В прошлом году появились слухи, что его владельцем является крупнейший онлайн-ритейлер Amazon (штаб-квартира в Сиэтле), один из ведущих претендентов на рынок облачных вычислений. Считается, что объект будет включать три здания и подстанцию мощностью 10 МВт, однако компания отказывается уточнять детали.

Amazon, Google, Microsoft и Yahoo стараются идти в ногу с постоянно растущим спросом на такие Интернет-сервисы, как поиск информации, обмен изображениями и видео, социальные сети. Однако они рассчитывают и на взрывной рост Web-приложений, работающих на основе компьютерных вычислений. Данные приложения будут передавать пользователям информацию через Интернет-браузер, тогда как обработка и хранение данных будут производиться на удаленных серверах. Спектр приложений широк – от простой почты вроде Gmail и Hotmail до таких более сложных сервисов, как инструменты создания документов и таблиц Google Docs. К приложениям относятся и различные промышленные системы вроде системы управления взаимоотношениями с клиентами Salesforce.com. Так что гонка в облаках идет полным ходом. Ее ареной является не только тихоокеанский северо-запад, но и многие другие регионы в США и мире.

Уже имея более миллиона серверов, размещенных в трех дюжинах дата-центров по всему миру, Google тратит миллиарды долларов на строительство крупных объектов в Прайоре, Оклахома; Каунсил-Блафс, Айова; Ленуаре, Северная Каролина; и Гуз-Крике, Южная Каролина.

В прошлом году компания открыла сервис Google App Engine – «облачная» платформа, которую физические и юридические лица могут использовать для работы приложений. Microsoft, чей дата-центр в Квинси будет базой для первых версий «облачной» операционной системы Windows Azure, строит дополнительные объекты в Чикаго, Сан-Антонио и Дублине стоимостью приблизительно 500 миллионов долларов каждый. Также ходят слухи, что компания ищет место для строительства в Сибири.

Проектирование более крупных и совершенных дата-центров требует инноваций не только в системах питания и охлаждения, но и в компьютерной архитектуре, структуре сети, операционных системах и т.д. Некоторые инженеры заинтересованы самой возможностью проектировать компьютерные системы такого масштаба — или, как их иногда называют в самой Google, «компьютеры со склад».

Крупные дата-центры, созданные во время бума доткомов в конце 1990-х и начале 2000-х, состояли из тысяч и даже десятков тысяч серверов. Тогда их управляющие могли почти неограниченно увеличивать вычислительные мощности. Сервера, системы хранения данных, сетевое оборудование как в те дни, так и сегодня относительно дешевы в соответствии с Законом Мура. Для получения необходимых вычислительных мощностей надо было всего лишь установить или усовершенствовать оборудование и включить кондиционирование воздуха.

Однако в последние годы данный подход перестал быть удачным. Управление, питание и охлаждение огромного количества серверов, используемых компаниями, стало слишком затратным. Сегодня крупнейшие дата-центры состоят из десятков тысяч серверов, а некоторые уже перешли через отметку в 100 000. Дата-центры эпохи доткомов потребляли 1-2 МВт электроэнергии. Сегодня дата-центр, требующий 20 МВт – обычное явление, а потребление некоторых объектов вскоре превысит это значение в 10 раз.

Настройка столь большого количества серверов – их установка в стойки, подсоединение кабелей, установка программного обеспечения – требует массу времени. Что еще более важно, при росте цен на электроэнергию расходы на питание и охлаждение такого количества оборудования становятся попросту огромными. Исследование рынка, проведенное компанией IDC, показывает, что в течение следующих шести лет компании-владельцы дата-центров будут тратить больше денег в год на электроэнергию, чем на оборудование.

Дата-центры эпохи доткомов потребляли 1 или 2 МВт электроэнергии. Сегодня дата-центр, требующий 20 МВт – обычное явление, а потребление некоторых объектов вскоре превысит это значение в 10 раз. Более того, сегодня внимание регулирующих органов и заинтересованных экологией акционеров обращается на влияние дата-центров на окружающую среду. Согласно исследованиям консалтинговой компании McKinsey & Co., на 44 миллиона серверов во всем мире приходится 0,5% мирового потребления электроэнергии и 0,2% выбросов углекислого газа, что составляет 80 мегатонн в год и почти равно выбросам таких стран, как Аргентина или Нидерланды.

Проектировщики дата-центров понимают, что они должны сделать многое для повышения эффективности каждой системы на их объектах. Но что именно?

И снова компании не намерены сдавать свои позиции. При этом в попытках продемонстрировать растущую экологичность своей работы, Google, Microsoft и другие компании обнаружили некоторые интересные детали. Разумеется, некоторые инновации следует отнести на счет разработчиков оборудования, готовых обсудить свои идеи.

В первую очередь, рассмотрим серверную инфраструктуру дата-центра. Традиционно сервера устанавливаются в стойки. Каждый сервер – это отдельный компьютер с одним или более процессором, оперативной памятью, жестким диском, сетевым интерфейсом, блоком питания и кулером – все это заключено в металлическую оболочку размером с коробку для пиццы. Обычный двухпроцессорный сервер потребляет 200 Вт при максимальной загрузке, причем на долю процессора (CPU) приходится около 60% этого значения. Заполненная стойка, содержащая до 40 серверов размером с коробку для пиццы, потребляет 8 кВт. Если в стойке размещены блейд-сервера (компактные компьютеры, устанавливаемые вертикально на специальной подставке, наподобие книг на полке), то общее потребление стойки может быть в два раза больше.

Как правило, новые крупные дата-центры продолжают использование конфигурации в виде серверных стоек. Однако и здесь есть место для усовершенствований. Так, Microsoft заявила о возможности увеличить количество серверов в своих дата-центрах просто за счет более рационального управления их энергопотреблением. Смысл в том, что большое количество серверов крайне редко выходят на пиковый уровень загрузки одновременно, соответственно их энергопотребление следует рассчитывать исходя не из общей пиковой мощности, а из их среднего потребления. Согласно данным Microsoft, такой подход позволит разместить в некоторых дата-центрах на 30-50% больше серверов. Тем не менее, компания отмечает, что такая стратегия подразумевает тщательный контроль серверов и использование методов управления питанием во избежание перегрузки системы питания в экстренных ситуациях.

Способ организации серверов в дата-центрах Google – тайна. Однако известно следующее – компания полагается на дешевые компьютеры с традиционными многоядерными процессорами. Для снижения энергопотребления Google оснащает машины эффективными блоками питания и регуляторами напряжения, кулерами с изменяемой скоростью вращения, материнскими платами без каких-либо лишних компонентов вроде видеокарт. Google также проводил эксперименты с такой функцией CPU, как динамическое масштабирование напряжения/частоты. Она снижает напряжение или частоту процессора в определенные периоды (например, при отсутствии потребности в расчетах в данный момент). Сервер работает более медленно, снижая тем самым энергопотребление. В некоторых тестах инженеры Google добились 20-процентной экономии энергии.

Однако дата-центр состоит не только из серверов. Рассмотрим системы питания и охлаждения – именно в этой области на некоторых объектах добились максимальных усовершенствований. В обычном дата-центре электроэнергия проходит через множество трансформаторов и распределительных сетей, понижающих высокое напряжение переменного тока до стандартных 120 или 208 вольт, используемых в серверных стойках. В итоге к моменту подачи электроэнергии на сервера ее потери могут достигать 8-9%. Кроме того, в процессорах, оперативной и долговременной памяти, сетевых интерфейсах сервера используется исключительно постоянный ток, поэтому для каждого сервера необходимо выполнять AC/DC преобразование, что приводит к дополнительным потерям. В связи с этим в некоторых дата-центрах для снижения энергопотребления применяются высокоэффективные трансформаторы и распределительные сети, а некоторые эксперты предлагают использовать распределение постоянного тока высокого напряжения, что, по их словам, приведет к снижению потерь на 5 – 20%.

Еще более важной является экономия электроэнергии за счет использования современных технологий охлаждения. Как правило, в дата-центрах используются фальшполы над зоной холодного воздуха (так называемая пазуха) и системы вытяжки горячего воздуха в верхней части помещения. Основным недостатком такой схемы является возможность упущения перегревшегося устройства (например, загруженного сервера или коммутатора) и, как следствие, его сбоя. Во избежание этого в некоторых дата-центрах применяется охлаждение всей серверной до стабильно низкой температуры (обычно около 13°C). Сегодня в дата-центрах начинают использовать новые системы охлаждения, допускающие нагрев помещений до 27°C. Компания American Power Conversion Corp. (штаб-квартира в Вест-Кингстоне, Род-Айленд) предлагает специальную серверную стойку с кондиционером, направляющим холодный воздух непосредственно на сервера. Технологии «умного охлаждения» компании Hewlett-Packard предполагают использование датчиков внутри серверной для позиционирования вентиляционных решеток в полу и направления холодного воздуха непосредственно на нагретые машины, что повышает допустимую среднюю температуру дата-центра и снижает затраты на охлаждение на 25-40%.

Традиционные системы воздушного кондиционирования постепенно сменяются более эффективными системами водного охлаждения. Сегодня в крупных дата-центрах вместо энергоемких традиционных охладителей используются охлаждающие башни, удаляющие тепло из хладагента за счет испарения. Несколько производителей оборудования предлагают устройства для охлаждения на водной основе. Устройство Rear

Door Heat eXchanger от IBM устанавливается на задней стенке стойки и по сути представляет собой водную оболочку, удаляющую до 15 кВт тепла. Возвращаемся в эпоху мэйнфреймов!

Также ведутся работы по использованию холодного воздуха извне – метод, известный как воздушная экономизация. Согласно заявлениям Yahoo, в своем дата-центре в Квинси вместо традиционного круглогодичного кондиционирования компания применяет высокоэффективные воздушные кондиционеры на основе водяных охладителей и холодного воздуха извне для охлаждения серверов в течение трех кварталов из четырех.

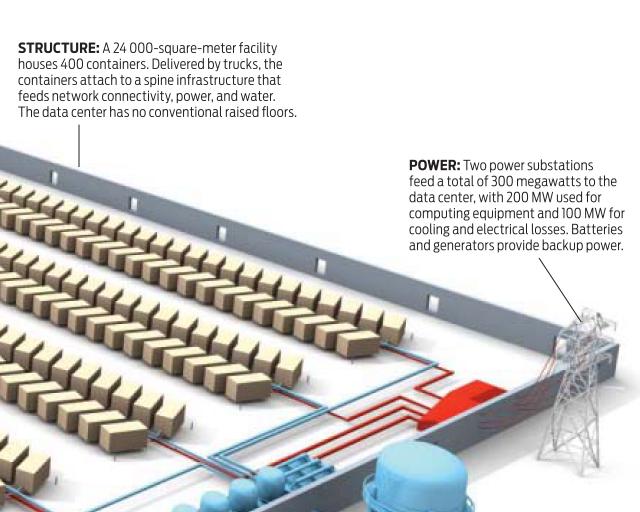

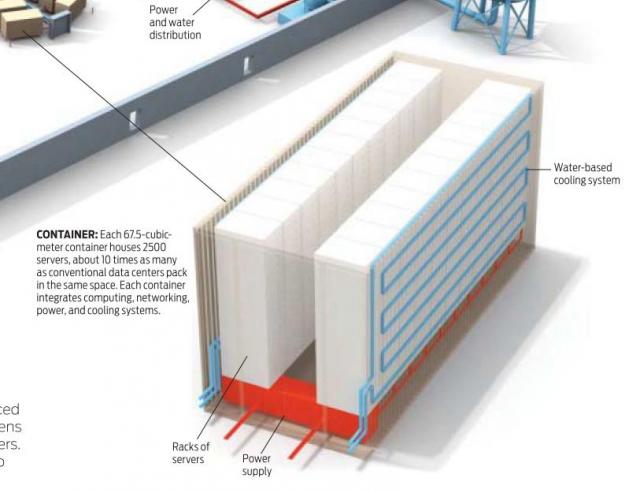

Наконец, наиболее радикальным изменением, внедряющимся сегодня в некоторых крупнейших дата-центрах, является использование контейнеров для разворачивания серверов. Представьте себе расширение дата-центра с помощью простого добавления модулей, сочетающих вычислительные мощности, системы питания и охлаждения, вместо сооружения помещений с фальшполами, установки систем воздушного кондиционирования и постоянной сборки стоек.

Именно этот подход начинает использоваться такими компаниями, как IBM, HP, Sun Microsystems, Rackable Systems и Verari Systems. Модули представляют собой стандартные грузовые контейнеры, вмещающие около 3000 серверов, что в 10 раз больше, нежели можно разместить в традиционном дата-центре аналогичного размера. Их основным преимуществом является быстрота развертывания. Необходимо всего лишь ввезти модули в здание, опустить их на пол и подключить к сети питания. Кроме того, контейнерная конфигурация позволяет с легкостью обновлять оборудование – просто отвезите контейнер поставщику и дождитесь прибытия новой версии. Компания Sun первой выпустила контейнерный модуль. Модель MD S20 содержит 280 двуядерных серверов размером с коробку для пиццы, а также оборудование Sun для мониторинга и контроля. В целом модуль потребляет 187,5 кВт, или 12,6 кВт/м2. Потребление традиционных дата-центров с фальшполами является куда более скромным – в районе 0,5 кВт/м2. Контейнер от Verari Systems состоит из 1400 блейд-серверов, при этом можно использовать как встроенное, так и внешнее водное охлаждение. Потребление — 400 кВт, или 12,9 кВт/м2. Контейнер ICE Cube от Rackable Systems снабжен встроенной системой охлаждения и системой питания постоянного тока, потребляя при этом 16 кВт/м2.

В Чикагском дата-центре Microsoft, нацеленном на реализацию облачных проектов компании, применяется гибридный дизайн, сочетающий традиционные серверные с фальшполами и контейнерный модуль примерно на 200 серверов. Помещение, где размещены контейнеры, больше напоминает склад, нежели обычную охлаждаемую серверную. С потолка свешиваются трубы, готовые для подключения к контейнерам и подведения холодной воды и питания. По словам одного инженера Microsoft, все это похоже на «индустриализацию мира IT».

Так чего же добились Google и Microsoft? Чтобы интерпретировать некоторые опубликованные ими значения, сначала необходимо сказать пару слов про показатель энергоэффективности, ставший весьма распространенным в данной отрасли. Речь идет об эффективности использования энергии (power usage effectiveness, PUE), рассчитываемой как общее потребление электроэнергии объекта, разделенное на мощность, потребляемую только серверами, системами хранения и сетевым оборудованием. Если PUE близок к единице, то дата-центр использует большую часть электроэнергии на компьютерную инфраструктуру, а на системы охлаждения и потери в распределительной сети приходится лишь малая часть. PUE не является универсальным показателем, так как он не показывает эффективность самого вычислительного оборудования, но, тем не менее, это весьма удобный критерий.

Исследование, проведенное Агентством по защите окружающей среды США (EPA) в 2007 году, показывает, что PUE среднестатистического дата-центра составляет 2,0 или более. Это означает, что на каждый ватт, потребляемый серверами, системами хранения и сетевым оборудованием, приходится один ватт на системы охлаждения и распределения энергии. В исследовании предполагается, что к 2011 году большинство дата-центров благодаря улучшениям в оборудовании достигнет PUE, равного 1,7, кроме того, с использованием дополнительных технологий некоторые объекты достигнут показателя в 1,3, и небольшое количество новейших дата-центровс жидкостным охлаждением добьется значения в 1,2.

Интересно, что именно о таких достижениях уже сегодня отчитывается Google. Компания сообщает о среднем значении PUE в 1,21 в шести «крупных дата-центрах по собственному проекту», причем в одном из них PUE достигает 1,15 (по заявлениям компании, усовершенствования обеспечивают ежегодную экономию в 500 киловатт-часов, 300 кг выбросов углекислого газа и 3785 литров воды на один сервер). Как именно Google добился таких результатов – тщательно охраняемый секрет. Некоторые обозреватели считают, что случай Google является исключительным в силу того, что размеры компании позволяют ей приобретать исключительно эффективное оборудование, что слишком затратно для других компаний. Другие сомневаются в том, что достигнуть PUE в 1,15 возможно с учетом современного уровня технологий водного охлаждения, и делают предположения о нестандартной конфигурации объекта – например, об использовании контейнерной конструкции. В Google говорят только то, что на объектах используется различная архитектура питания и охлаждения. Так или иначе, очевидно, что инженеры Google мыслят нестандартно – компания запатентовала «водный дата-центр», контейнерные серверные модули которого помещаются на барже, а электроэнергия генерируется за счет волнения моря.

В свою очередь, недавно Microsoft сообщила о показателях PUE контейнерной части своего Чикагского дата-центра. Модули оказались весьма экономными, показав среднегодовое значение PUE в 1,22. Результат убедил компанию в том, что полностью контейнерные дата-центры – весьма разумное решение, несмотря на свою новизну. По сути, Microsoft выступает за контейнерную конфигурацию в своих дата-центрах следующего поколения, намереваясь использовать готовые модули, содержащие не только сервера, но и системы охлаждения и питания. При этом компания намеревается создать объект без крыши – дата-центр, который легко можно спутать с контейнерной площадкой.

Однако у контейнерной конфигурации есть и свои противники. Они считают, что заявляемое простое подключение контейнеров может быть невозможным – сначала потребуется подключение дополнительных регуляторов мощности, а для ремонта серверов потребуется отправка всего контейнера обратно к поставщику, что приводит к огромным трудозатратам. Так или иначе, сегодня Агентство по защите окружающей среды США следит за PUE множества дата-центров как контейнерной, так и традиционной конфигурации, и в ближайшие годы следует ожидать появления новых показателей и рекомендаций.

ОЧЕВИДНО, что по сравнению с сегодняшним днем дата-центры будущего будут представлять собой результат куда более глубоких усовершенствований. Прежде всего необходимо оборудование с намного более совершенным управлением питанием. Инженеры Google призывают системных архитекторов разрабатывать серверы, потребляющие энергию пропорционально объему производимых вычислений. Конструкция мобильных телефонов и портативных устройств обеспечивает экономию энергии с помощью режима ожидания, при котором устройство потребляет 1/10 или менее энергии по сравнению с пиковой мощностью. Сервера, в свою очередь, в незагруженном режиме потребляют до 60% от пиковой мощности. По сведениям Google, моделирование энергопотребления для серверов, способных изменять свое потребление в зависимости от загрузки, показало возможное снижение общего энергопотребления дата-центра в два раза.

Проектировщикам также необходимо найти иной способ доставки электричества к дата-центрам. Сегодня электроэнергия становится все более дорогой, и использование единственного источника (например, ближайшей электростанции) весьма рискованно. Для снижения зависимости от электросетей компании-операторы дата-центров должны изучить иные технологии получения энергии – солнечная энергия, ТВЭЛ, энергия ветра. То же самое относится и к воде и иным энергоемким материалам вроде бетона или меди. В крайнем случае, для повышения производительности и эффективности конструкция крупных вычислительных центров должна быть полностью пересмотрена.

Наконец, остается программное обеспечение. Сегодня все более популярными становятся инструменты виртуализации – что-то вроде операционных систем для операционных систем. Благодаря им один сервер может работать как несколько независимых машин. Некоторые исследования показывают, что средняя загрузка серверов в дата-центрах составляет 15% от их максимальной производительности. Это неплохой показатель, однако необходимы иные инструменты для автоматизации управления серверами, регулирования их энергопотребления, обмена распределенными данными, обработки сбоев оборудования. Программное обеспечение обеспечит развитие дата-центров, состоящих из недорогих серверов.

И они вырастут – но что потом? Станут ли дата-центры просто еще более обширными зданиями, забитыми серверами? Сегодняшние объекты создаются на основе существующего оборудования и традиционных методов строительства и эксплуатации. Как правило, дата-центры выполняют роль пристанища кучи компьютеров, вокруг которых снует технический персонал, налаживая работу или устраняя неполадки. Контейнеры являются более интересным вариантом, однако они также состоят из существующих серверов, стоек, блоков питания и т.д. Некоторые эксперты предполагают, что необходимо разрабатывать системы исключительно для дата-центров. В этом есть смысл, однако остается только догадываться, что будут представлять собой подобные объекты.

статейка то февраля 2009 🙂

Не первой свежести, но, учитывая отставания России в данном вопросе на несколько лет, думаю самое то!

видюшка прикольная по строительству таких гигантов 🙂 только качество слабое

«Кирпичное» строительство ЦОД с самом разгаре……….

Это м.б. и правильно. Все строить на заводах и привозить к местам с энергетикой.