Дайджест сбоев ЦОД за март-апрель 2025 года: аварии у Яндекса и других крупных компаний

Даже дата-центры с самой продвинутой инфраструктурой не застрахованы от сбоев. Справедливость этого утверждения доказывают многочисленные новости об авариях за март-апрель 2025 года. Дайджест охватывает как инциденты в ЦОД крупных корпораций вроде Amazon, Google и Яндекса, так и локальные аварии на старых мэйнфреймах. Все эти события затруднили работу критически важных сервисов и показали важность непрерывной работы для обеспечения бесперебойного функционирования IT-систем.

Сбой сетевой инфраструктуры в ЦОД AWS привёл к уходу в офлайн популярных криптобирж

15 апреля 2025 года в одном из дата-центров Amazon Web Services (AWS) произошла серьёзная авария, вызвавшая перебои в работе ряда популярных криптовалютных платформ, включая Binance и KuCoin. Инцидент произошёл в зоне доступности apne1-as4 региона AP-Northeast-1, расположенного в Токио. По информации с панели состояния AWS Health Dashboard, проблему вызвало одновременное отключение основного и резервного электропитания. Пользователи столкнулись с ростом задержек и учащением ошибок при обращении к сервисам, размещённым в пострадавшей зоне.

Администрация Binance оперативно сообщила в X (ранее Twitter) о временном «сбое сетевой инфраструктуры» и заверила, что инженеры работают над устранением проблемы. Уже через пять минут после первого сообщения биржа возобновила операции по выводу средств, однако в течение некоторого времени часть ее сервисов продолжала работать с задержками.

Хотя AWS быстро восстановила доступность, инцидент вызвал обеспокоенность среди клиентов в свете высокой чувствительности финансовых сервисов к подобным инцидентам. Событие стало очередным напоминанием, что даже крупнейшие облачные платформы не застрахованы от сбоев.

Регион AP-Northeast-1 играет ключевую роль в инфраструктуре AWS в Азии. Компания присутствует в Японии с 2009 года, а первая облачная зона в Токио была запущена в 2011 году. Спустя десятилетие AWS открыла регион в Осаке, а в январе 2024 года анонсировала масштабные инвестиции ($15+ млрд на трехлетний период) в развитие дата-центров в стране. Несмотря на высокий уровень зрелости японской инфраструктуры AWS, инциденты всё ещё случаются. Так, в 2021 году регион уже переживал шестичасовую аварию из-за неполадок с Direct Connect.

В AWS подчеркнули, что апрельский сбой 2025 года не должен повториться, и описали реакцию команды ЦОД как мгновенную: инженеры начали работу над устранением проблемы в течение нескольких минут.

Крупная утечка газа зафиксирована на кампусе ЦОД компании QTS в американской Вирджинии

9 апреля 2025 года на кампусе дата-центров компании QTS вблизи города Манассас (штат Вирджиния, США) произошёл инцидент, вызванный крупной утечкой газа. В 14:10 по местному времени на кампус прибыли пожарные и спасатели.

Авария затронула газопровод диаметром восемь дюймов. Устранение утечек такого масштаба требует времени и высокой технической точности – особенно на объектах с высокой плотностью инженерной инфраструктуры, в число которых входит кампус QTS.

К счастью, пострадавших не было. Эвакуация персонала не проводилась. Однако инцидент повлиял на дорожное движение: на трассе и улицах, прилегающих к объекту, образовались пробки.

Площадка, где случился инцидент, — один из крупнейших проектов QTS. На кампусе в Манассасе уже работают три дата-центра. Ещё три находятся на стадии проектирования. Ожидается, что в будущем общая мощность кампуса превысит 190 мегаватт.

Характер и причины повреждения газопровода пока не уточняются. Компания QTS и представители служб экстренного реагирования не предоставили дополнительных комментариев. Учитывая масштабы инфраструктуры кампуса и предполагаемый рост его мощности, даже краткосрочные перебои могут повлиять на работу сервисов ЦОД.

Примечательно, что незадолго до инцидента, в конце марта 2025 года, гендиректор и сооснователь QTS Чад Уильямс объявил об уходе с поста, завершив двадцатилетнюю карьеру в компании. Сама QTS была основана в 2003 году в Канзас-Сити, где по-прежнему функционирует её первый дата-центр мощностью 200 кВт. С момента покупки QTS инвестиционной группой Blackstone в 2021 году за $10 млрд компания значительно масштабировала деятельность и стала одним из крупнейших игроков на рынке коммерческих ЦОД в США.

Авария в Вирджинии подчёркивает важность физической устойчивости инженерных систем ЦОД и необходимости взаимодействия с городскими службами в режиме реального времени. Даже в отсутствие пожара или отключения электроэнергии аварии на внешней инфраструктуре (в данном случае на газопроводе) могут выступать источником рисков для эксплуатации дата-центров и безопасности окружающей среды.

Сбой в хьюстонском дата‑центре привел к задержкам экологических проверок автомобилей

6 апреля 2025 года в Хьюстоне (штат Техас, США) произошёл сбой в работе дата-центра, используемого Департаментом общественной безопасности Техаса (Texas Department of Public Safety, DPS). Инцидент нарушил процессы проверки автомобилей на выбросы. Это напрямую повлияло на водителей, пытавшихся пройти обязательный техосмотр.

Сбой произошёл на фоне сильного шторма, повредившего административную и IT-инфраструктуру департамента. В частности, дата-центр, обслуживающий критически важные сервисы, оказался полностью недоступен. Из-за этого инспекционные пункты на территории Хьюстона и прилегающих округов не смогли проводить стандартные экологические проверки.

В DPS подтвердили проблему и сообщили о работе над устранением последствий. Однако о сроках завершения восстановительных работ не сообщалось, а водителям было рекомендовано следить за обновлениями на сайте ведомства и планировать инспекцию с учётом возможных задержек.

Хотя конкретные технические детали сбоя не раскрываются, из контекста понятно, что инфраструктура дата-центра была неподготовлена к сложным погодным условиям. Учитывая, что штат Техас периодически сталкивается с экстремальными метеоусловиями, этот инцидент вновь ставит вопрос о необходимости повышения устойчивости государственных дата-центров и подготовке сценариев быстрого восстановления после катастроф.

Сбой мэйнфрейма AKDB затормозил регистрацию транспортных средств по всей Баварии

31 марта 2025 года в Баварии произошёл сбой, парализовавший работу почти всех регистрационных служб региона. Причиной стала техническая неисправность центрального вычислительного узла, расположенного в одном из дата-центров Баварского института муниципальной обработки данных (AKDB). Последний выступает ключевым IT-подрядчиком для государственных и муниципальных структур федеральной земли.

Сбой затронул порядка 80% местных регистрационных офисов, включая районы Берхтесгаденер-Ланд, Альтэттинг, Штраубинг-Боген, а также город и округ Пассау. По словам чиновников, проблема заключалась в отказе центрального мэйнфрейма, обслуживающего все запросы, связанные с регистрацией транспортных средств. Это привело к полной остановке процессов регистрации, продления и снятия автомобилей с учёта.

Мэйнфреймы традиционно позиционировались как высоконадёжные решения, но сложное техобслуживание и устаревание компонентов делают их уязвимыми. Сбои подобного рода редко происходят в дата-центрах, обслуживающих государственные структуры. Это делает данный случай особенно заметным.

Инцидент произошёл на фоне активной цифровизации административных процедур в Германии с привлечением экспертов AKDB. Организация участвует в модернизации IT-систем местных властей, обеспечивая цифровизацию административных механизмов, проведение электронных выборов и защиту персональных данных.

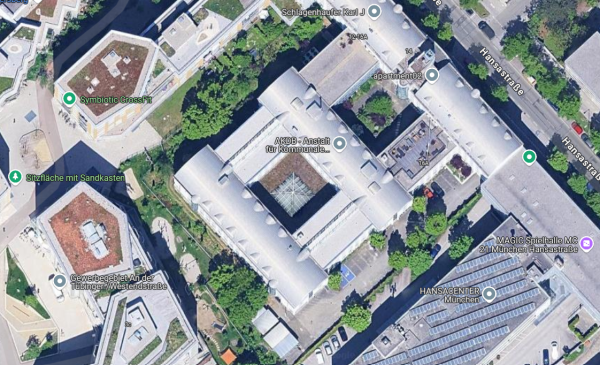

Негосударственная организация AKDB, основанная в 1971 году, предоставляет IT-решения, консалтинг и услуги в сфере информационной безопасности органам местного самоуправления в Германии. В ее распоряжении имеются три дата-центра, расположенные в Байройте и Мюнхене. Все три ЦОД сертифицированы Федеральным ведомством по информационной безопасности Германии (BSI). Конкретный дата-центр, на котором произошёл инцидент, не был указан в пресс-релизах. Однако масштабы сбоя позволяют предположить, что пострадал один из основных узлов в Мюнхене.

В дата‑центре Equinix SP4 в Сан‑Паулу произошел пожар

30 марта 2025 года в одном из крупнейших латиноамериканских коммерческих дата-центров Equinix SP4, расположенном в районе Тамборе города Баруэри (пригород Сан-Паулу, Бразилия), произошёл пожар. Инцидент случился в 12:34 по местному времени. Как подтвердили представители компании, огонь был локализован в стойке одного из клиентов — неназванного провайдера незанятого канала связи / «тёмного оптоволокна» (dark fiber).

По первоначальной информации, загорелось силовое оборудование клиента. В соответствии с протоколами безопасности, в ЦОД незамедлительно сработала противопожарная система с водяным тушением, а персонал и посетители были эвакуированы.

Сам инцидент был классифицирован как «локализованное происшествие», однако его последствия оказались достаточно серьёзными. Пожар прервал работу волоконно-оптических линий связи, что отразилось на состоянии облачных сервисов Oracle Cloud Infrastructure (OCI) и Google Cloud Platform (GCP), использующих Equinix Fabric и виртуальные соединения (VC). Частичное восстановление сервиса было произведено путём переадресации трафика на резервные каналы в тот же день к 20:56 по местному времени.

Дополнительное сообщение от 31 марта указывало, что линии связи между местными дата-центрами SP1 и SP4 были восстановлены, однако восстановление линий между ЦОД SP2 и SP4 к тому моменту не завершилось. Это подтверждает, что сбой затронул не только непосредственно пострадавшую стойку, но и связанные с ней оптоволоконные маршруты, включая критически важные магистрали.

По данным Equinix, только один машзал был частично выведен из строя на длительный период. При этом остальная часть оборудования была повторно введена в эксплуатацию в кратчайшие сроки. Клиентам, столкнувшимся с наиболее серьёзным воздействием, было выделено новое пространство для переноса инфраструктуры. Технические команды Equinix продолжали работать над устранением последствий, сотрудничая с местными властями и клиентами. Расследование причин пожара было запущено незамедлительно.

Независимые эксперты предположили, что причиной пожара могли стать остатки упаковки на работающем оборудовании. В Equinix не подтвердили эту версию. По данным местных СМИ, на место инцидента выезжали пожарные.

Дата-центр SP4 был построен в 2004 году компанией Terremark. Впоследствии он перешёл под управление Verizon, а с 2017 года принадлежит Equinix. В ЦОД два этажа, а общая площадь его машзалов составляет 2 725 м². Там же расположен один из крупнейших узлов обмена трафиком в Южной Америке.

В дата‑центре Яндекса случился крупный сбой из‑за аварии на питающей подстанции

30 марта 2025 года в одном из дата-центров Яндекса произошёл крупный сбой. Авария признана самой масштабной за 15 лет. Причиной стала неисправность на питающей подстанции на 220 кВ, обеспечивающей энергоснабжение через две независимые линии по 110 кВ каждая. В результате сбоя обе линии оказались отключены. Это вызвало полный переход ЦОД на дизельные генераторы и вывело из строя одну из трёх зон доступности Yandex Cloud, известную как ru-central1-b.

С 12:25 до 15:30 по московскому времени дата-центр работал в аварийном режиме. Несмотря на то, что основные элементы критически важной инфраструктуры (центры управления сетью и службы безопасности) продолжали функционировать, облачные сервисы оказались недоступны. Пострадали тысячи пользователей, включая как частных лиц, так и бизнес-клиентов. Особенно сильно сбой затронул тех, чьи приложения и рабочие процессы были развёрнуты исключительно в пострадавшей зоне ru-central1-b.

Согласно официальному блогу Яндекса, инцидент носил беспрецедентный характер: за всё время существования этого дата-центра подобного масштабного отказа не происходило. Более того, аварии такого рода на самой подстанции не случалось с момента её ввода в эксплуатацию в 1960 году.

Возобновление электроснабжения началось в 15:30. К 22:22 большая часть сервисов была восстановлена, а к полуночи зона ru-central1-b полностью вернулась к работе. Однако последствия наблюдались гораздо дольше: пользователи сообщали о сбоях в работе «Яндекс Музыки», «Кинопоиска», «Яндекс Еды», «Циана», «Аптеки.ру», а также ряда банковских и платёжных сервисов, включая «Яндекс.Пэй» и платформы, использующие инфраструктуру Yandex Cloud.

По данным Роскомнадзора, пик жалоб пришёлся на интервал с 12:45 до 14:20 по Москве. Платформа Brand Analytics зафиксировала более 8 500 обращений только по «Яндекс Музыке». Сервисы мониторинга, включая DownDetector и «сбой.рф», отмечали устойчивый рост жалоб на протяжении нескольких часов.

Опасения вызвало сообщение специалистов по информационной безопасности о временной недоступности сервисов защиты, включая Identity and Access Management, Key Management Service, DDoS Protection, Certificate Manager и другие. Это ставит под вопрос устойчивость защитного контура в случае аварий ЦОД.

В условиях кризиса команда Yandex Cloud рекомендовала клиентам переносить рабочие нагрузки в соседние зоны доступности. Техническая поддержка была оперативно мобилизована для помощи при переносе нагрузок и восстановления инфраструктуры.

Этот инцидент стал третьим за две недели сбоем в сервисах Яндекса. В середине и конце марта фиксировались проблемы с «Яндекс.Директом», «Яндекс.Go» и «Яндекс.Про». Все три случая объяснялись нарушениями в инфраструктуре компании, но апрельская авария выделяется масштабом и длительностью восстановления.

В Яндексе заявили о намерении расширить сценарии тренировок для персонала, включая отработку двойных отказов инфраструктуры, и оптимизировать систему холодного старта оборудования. Рассматриваются новые меры резервирования, позволяющие минимизировать последствия подобных инцидентов.

Облачная платформа Google Cloud начала сбоить из‑за отказа системы ИБП в дата-центре

29 марта 2025 года пользователи облачной платформы Google Cloud столкнулись с масштабным сбоем в регионе us-east5-c, который расположен в Колумбусе (штат Огайо, США). Инцидент длился более шести часов и затронул более двадцати сервисов Google, включая виртуальные машины, хранилища данных и сетевую инфраструктуру. Причиной стал отказ системы ИБП в дата-центре, которому предшествовала потеря внешнего электропитания.

Согласно официальному отчёту компании, опубликованному 11 апреля, сбой начался с отключения основного источника электроэнергии, после чего система ИБП должна была автоматически обеспечить временное электропитание до включения дизельных генераторов. Однако батареи, обеспечивающие буфер между центральной сетью и генераторами, не справились с задачей из-за критических повреждений.

Сбой вызвал цепную реакцию: помимо отключения серверов в ЦОД, в пределах зоны us-east5-c фиксировались проблемы с сетевой инфраструктурой, включая потерю пакетов и снижение производительности, а также сбои в работе подсистем хранения данных. Некоторые виртуальные машины оказались недоступны, часть хранилищ — нестабильна.

Для восстановления инфраструктуры инженерам Google пришлось обойти отказавшую систему ИБП и вручную перевести нагрузку на генераторное электропитание. Это удалось сделать менее чем за два часа с момента начала сбоя, что позволило оперативно восстановить большую часть сервисов.

В Google заявили, что в ответ на инцидент разрабатывают новую стратегию повышения отказоустойчивости, включая оптимизацию процедур восстановления при каскадных отказах электропитания, пересмотр архитектуры кластеров и углубление взаимодействия с поставщиком ИБП. При этом название вендора, поставившего неработоспособные батареи, не разглашается.

Клиенты Google уже сталкивались с подобными сбоями ранее. Например, в конце 2024 года из-за перебоев в электроснабжении начали сбоить сервисы в регионе europe-west3-c (Франкфурт, Германия). Тогда восстановление заняло 12+ часов. Это подчёркивает необходимость не только развёртывания новых мощностей, но и постоянного совершенствования резервных систем электроснабжения, включая ИБП и генераторные установки.

Пожар обесточил аэропорт Хитроу, но соседний дата‑центр продолжил работу

26 марта 2025 года пожар на электроподстанции возле лондонского аэропорта Хитроу привёл к масштабному отключению электроэнергии, фактически парализовав крупнейший воздушный узел Великобритании на многие часы. Несмотря на то, что в результате инцидента без электричества остались терминалы, взлётно-посадочные полосы и вспомогательные системы, расположенный всего в нескольких сотнях метров дата-центр продолжил работу в штатном режиме.

Пожар вспыхнул на подстанции Hyde North, обслуживаемой компанией National Grid Electricity Transmission. Два трансформатора вышли из строя, отключив аэропорт Хитроу от основной электросети. На возобновление подачи электроснабжения ушло почти 18 часов, в течение которых персонал аэропорта вручную переключался на резервные линии, идущие от других подстанций, одновременно восстанавливая критические системы.

Инцидент стал наглядной демонстрацией различий в уровнях энергетической устойчивости между традиционной инфраструктурой и современными коммерческими дата-центрами. Новый дата-центр компании Ark Data Centres, расположенный менее чем в полукилометре от эпицентра аварии, также временно остался без внешнего электропитания, однако в течение нескольких секунд автоматические датчики зафиксировали отключение и перевели ЦОД на батарейное питание, обеспечив плавный переход к работе на генераторах.

Несмотря на высокую стоимость, компания Ark Data Centres сознательно инвестировала в отказоустойчивость, развернув систему ИБП, резервные генераторы и активный мониторинг. На контрасте администрация аэропорта Хитроу, несмотря на наличие резервных систем для критически важных элементов (освещения ВПП и систем управления воздушным движением), не предусмотрела подобный сценарий и не смогла запитать остальную часть инфраструктуры, включая терминалы, эскалаторы, багажные ленты, розетки и торговые площади. Это продемонстрировало, насколько даже стратегически важные объекты уязвимы без полного резервирования силовых систем.

По словам экспертов, аэропорты зачастую отказываются от полноценных резервных решений из-за высокой стоимости. Для Хитроу установка полноценной системы резервного электропитания мощностью 40 мегаватт могла бы обойтись в $100 млн и занять несколько лет.

Инцидент вызвал широкий резонанс в Великобритании. Премьер-министр Кир Стармер заявил в интервью BBC: «Я не хочу, чтобы столь важный аэропорт, как Хитроу, вновь оказался в подобной ситуации». Руководство аэропорта пообещало рассмотреть модернизацию энергетических систем.

Губернатор Луизианы объявил чрезвычайное положение из‑за сбоя мэйнфрейма

20 марта 2025 года губернатор американской Луизианы объявил чрезвычайное положение в связи с массовыми сбоями в системе регистрации автомобилей, вызванными неисправностью старого мэйнфрейма в Офисе транспортных средств (OMV). Мэйнфрейм с легаси-софтом на языке программирования COBOL оказался не в состоянии справиться с возрастающим объёмом транзакций и запросов. Это привело к системным сбоям и задержкам в обработке заявок на предоставление / продление водительских удостоверений и регистрацию автомобилей.

Проблемы с мэйнфреймом начались ещё в феврале 2025 года, однако их последствия стали особенно заметны в марте. Неспособность системы обрабатывать запросы привела к закрытию ряда офисов OMV, что нарушило планы сотен тысяч жителей Луизианы.

Мэйнфрейм, использующий более 400 программ на языке COBOL, был в эксплуатации более 50 лет. Несмотря на несколько попыток модернизации, включая переход на новую платформу от IBM, процесс обновления не был завершён, и перегрузка системы стала неизбежной. Отсутствие надёжных резервных решений в случае отказа мэйнфрейма сделало его крайне уязвимым для сбоев. Сейчас рассматривается полная замена старой системы на более современную платформу.

Заключение

Март и апрель 2025 года стали временем серьёзных испытаний для операторов многих дата-центров. Пожары, сбои в электропитании и проблемные обновления старых систем — все эти инциденты выявили значительные риски, с которыми сталкиваются как крупные корпорации, так и сравнительно небольшие государственные учреждения. Они в очередной раз подчеркнули важность непрерывной работы для обеспечения надёжности и отказоустойчивости в условиях всё более сложных технологических экосистем.

Всего комментариев: 0