Intel, Yahoo и Google поделились инновациями для менеджеров ЦОД

Решения, принимаемые в ЦОД, никогда не бывают легкими, независимо от размера Вашей компании. Когда дело доходит до того, чтобы по максимуму использовать свой дата-центр, почему бы не пойти тем же путем, которым пошли крупные игроки?

Решения, принимаемые в ЦОД, никогда не бывают легкими, независимо от размера Вашей компании. Когда дело доходит до того, чтобы по максимуму использовать свой дата-центр, почему бы не пойти тем же путем, которым пошли крупные игроки?

Мы пообщались с руководителями некоторых крупнейших компаний ИТ — индустрии, чтобы узнать, каким образом они вводят инновации в свои новые ЦОД, включая построенный в Бельгии дата-центр Google, новый современный объект Cisco, в штате Техас. Intel и Yahoo также представили свои лучшие наработки.

Google: все об эффективности

Google управляет «десятками» ЦОД во всем мире. Основное внимание компании сосредоточено на том, чтобы создавать такие дата-центры, эффективность которых превышает средние показатели в индустрии, утверждает Билл Вейл, «царь» зеленых энергоэффективных технологий Google. Согласно оценкам EPA, большинство ЦОД работают с коэффициентом энергоэффективности (PUE) 2.0, что говорит о том, что они используют вдвое больше энергии, чем им необходимо на самом деле. PUE — суммарная энергия, потребляемая ЦОД деленная на энергию потребляемую ИТ-оборудованием.

Google, в свою очередь, работает с PUE около 1,18 во всех своих центрах обработки данных, утверждает Вейл. Одним из способов, который позволяет компании Google добиваться большей энергоэффективности является использование технологии «фрикулинга» для своих серверов.

«Мы управляем воздушным потоком в наших ЦОД для того, чтобы избежать возможного смешивания горячего и холодного воздуха. Мы снизили общие расходы на охлаждение типичного центра обработки данных на 85%,» утверждает Вейл, добавив, что сокращение расходов происходит за счет комбинированного использования новых технологий охлаждения и методов резервного питания, описанных ниже. Средняя температура холодного коридора в ЦОД Google составляет около 27 градусов вместо обычных 22 или ниже. Температура горячего коридора изменяется в зависимости от используемого оборудования. Google не дает подробной информации ни о температуре горячего коридора, ни о точном названии оборудования.

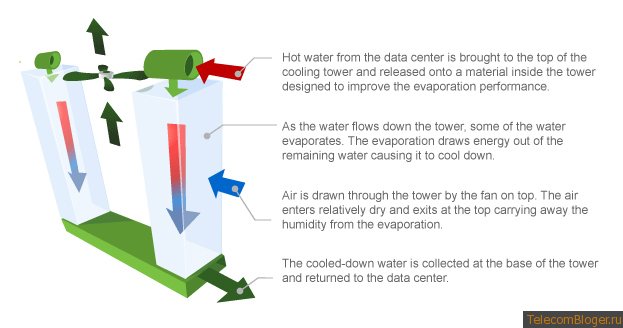

Со слов Вейл, Google использует испарительные градирни в каждом центре обработки данных, включая свой новый дата-центр в Бельгии. Горячая вода подается к вершине градирни и спускается вниз через материал, который вызывает быстрое испарение. В течение периода охлаждения испарением, чиллеры для охлаждения ЦОД не используются, или используются не так часто.

«Наши дата-центры расположены по всему миру, в штате Орегон, где климат холодный и сухой, и на юго-западе, и в средней части Запада США. Климатические условия везде разные, некоторые более теплые, некоторые более влажные, но практически всегда мы полагаемся на охлаждение испарением, «утверждает он.

Вейл рассказал, что объект в Бельгии, который открылся в начале 2010 года, даже не имеет резервных чиллеров, полностью полагаясь на охлаждение испарением. Он считает, что это будет «событием 100 летия», когда центры обработки данных перестанут нуждаться в испарительном охлаждении, поэтому Google решил отказаться от резервных чиллеров для того, чтобы уменьшить электрическую нагрузку на дата-центры.

Все Дата-центры работают на максимальной нагрузке большую часть времени, утверждает он. На редко встречающиеся «горячие» дни администраторы переводят некоторые серверы в режим ожидания или выключают их вовсе.

Он советует компаниям серьезно взглянуть на технологии фрикулинга и, в частности, на испарительные градирни , которые описаны выше. Еще одна возможность в использовании градирни заключатся в том, что с ее помощью можно перенаправить внешний воздух к серверам, а затем позволить температуре сервера повысится в пределах допустимого диапазона и таким образом использовать меньше прямого охлаждения в стойках.

С точки зрения управления питанием, Google использует методы преобразования напряжения, постепенно приводя переменное напряжение к постоянному. Google также использует местное резервное питание, которое фактически представляет собой батарею для каждого сервера, вместо традиционных ИБП, что стало возможным за счет преобразования переменного тока в постоянный.

Google использует трансформатор для преобразования энергии на линиях электропитания, прежде чем мощность поступает к серверам. Традиционно, отдельные источники питания конвертировали напряжения переменного тока в постоянное, но по мнению экспертов отрасли, этот метод оказался неэффективным.

Дэвид Капучио, аналитик Gartner, утверждает: «Google, Facebook и многие другие компании начали сокращение числа конверторов переменного напряжения с того момента, когда мощность попадает в здание, до того, когда она поступает к серверам». Это может принять форму системы распределения энергии, работающей на постоянном напряжении, начиная от отдельных серверов и заканчивая отдельной стойкой. Как правило, это сберегает некоторый процент использования энергии, объясняет он.

Google также использует источники питания для серверов и регуляторы напряжения, которые являются эффективными на 93%, утверждает он. Использование более эффективных регуляторов будет непомерно дорогим.

«Мы используем один внешний источник питания для 12-ти вольтовой шины, которая практически не потребляет мощность, когда она под напряжением. Резервная часть составляет менее 1% по сравнению с типичными 15% и более », объясняет Вейл, цитируя EPA оценки для среднестатистического ЦОД.

Еще одна интересная технология Google включает в себя пользовательские программные средства для управления системой данных. Вейл рассказал, что большая часть управления автоматизирована с помощью инструментов, которые помогут выяснить, почему сервер потребляет слишком много энергии и какие параметры заданы неверно.

Компания использует собственную систему, которая называется Big Table, хранящую табличные данные и позволяющую ИТ-менеджерам найти подробную информацию о производительности сервера.

Google утверждает, что его ЦОД по общей эффективности имеют превосходство на 19%, по сравнению с оценкой EPA в 96% для большинства центров обработки данных. Превышающий процент показывает, сколько энергии используется для отопления и охлаждения IT-устройств, а не для запуска серверов.

Cisco и «сокращенние модернизаций»

Подобно другим компаниям, Cisco внедрила концепцию «сокращенния модернизаций», которая достигается за счет виртуализации и консолидации. Процесс включает в себя сокращение общего размера ЦОД и размещение оборудования в шасси меньших размеров, для экономии энергии, что в то же время увеличивает производительность дата-центров.

К примеру, в новом ЦОД Cisco в Техасе, компания наметила достаточно места для размещения огромного серверного кластера, который можно масштабировать быстрыми темпами. Основная концепция: «Натолкать» столько энергии в небольшое пространство, сколько это возможно, и в то же время получить высокую производительность.

Фактически, по определению, кластер Cisco, представляет собой стойку с пятью Cisco UCS шасси. В каждом шасси размещаются восемь лезвий. В целом, в дата-центре есть возможность установить 14 400 лезвий. Каждое лезвие имеет два разъема, которые поддерживают восьми ядерные процессоры. Каждое ядро поддерживает множество виртуализированных операционных систем. На сегодняшний день Cisco установила 10 кластеров, которые содержат 400 лезвий.

С другой стороны, Cisco улучшила менеджмент кабельных систем. Джон Манвиль, вице-президент Cisco по ИТ, утверждает, что Cisco сэкономила 1 млн. долларов за счет сокращения количества кабелей в центрах обработки данных.

«Большинство людей не осознают, что стоимость кабеля составляет от 10% до 15% от общей стоимости», поясняет Манвиль. «Такое сокращение количества кабелей помогает поддерживать потоки воздуха в оптимальном состоянии, и совместно с новой технологией охлаждения, которую мы установили, мы планируем, экономить 600 000 долларов в год на расходах, связанных с охлаждением».

Кроме этого вопроса, Cisco также рассчитала как снизить расходы на оборудование и управление каждой операционной системы для каждого сервера. Манвиль утверждает, что сегодня один сервер обходится около 3700 долларов в квартал. Благодаря виртуализации, ожидается снижение расходов до 1600 долларов на один сервер в квартал и, в конце концов, есть надежда снизить эту цифру вплоть до 1200 долларов за сервер в квартал.

Техасский дата-центр на самом деле представляет собой два отдельно расположенных ЦОД, которые работают как один, такая концепция называется метро виртуальных центров обработки данных (MVDC), которую Cisco разработала внутри компании, и не продает ее публично. Компания планирует открыть еще два MVDC ЦОД в Нидерландах к концу 2012 года, он в общей сложности будет состоять из 4-х ЦОД, работающих как единое целое.

Подход MVDC не основан на экономии средств или сохранении энергии за счет того, что дата-центры запускают одни и те же приложения в одно время. Вместо этого, Cisco использует технику дублирования. Если стихийное бедствие выводит из строя один из центров обработки данных, все операции продолжают выполняться с прежней мощностью в реальном времени.

Как и Google, Cisco сосредоточена на эффективности работы. Мавиль утверждает, что дата-центр в Техасе ушел на несколько шагов вперед большинства других ЦОД. Например, мощность распределена на 415 V для экономии около 10% энергии, по сравнению с типичными низко вольтовыми системами, используемыми в других дата-центрах. Эта система также использует светодиодные лампы, которые экономят около 40% потребления энергии по сравнению с лампами накаливания, утверждает он.

Когда впервые появились светодиодные лампы, они были значительно дороже, чем компактные люминесцентные лампы, рассказал Чарльз Кинг, аналитик компании Pund-IT. «Курс на снижение затрат делал использование светодиодных лампы бессмысленным, поэтому, Cisco заслуживает похвалы за это внедрение».

Yahoo строит удаленные ЦОД

Традиционный подход заключается в том, чтобы разместить хотя бы один из основных ЦОД в городе, или, по крайней мере, в месте с большой плотностью населения, чтобы быть ближе к ИТ-администраторам, получая таким образом свободный доступ к серверам. Со слов Скотта Ноутбума, старшего директора инжиниринга и операций центра обработки данных Yahoo, в последние годы концепция резко изменилась.

Yahoo управляет крупными дата-центрами в удаленных местах. Компания строит пять новых ЦОД в Северной Америке, Европе и Азии. Эта новая стратегия удаленного месторасположения была бы невозможна без улучшенного программного обеспечения, используемого для управления, которое продвинулось настолько, что ИТ-персонал может из офиса Yahoo удаленно управлять всеми тонкостями виртуальных машин и дисковых хранилищ. Ноутбум отказался рассказывать подробности того, как им удается это делать.

Размещение ЦОД в удаленных местах позволяет Yahoo снизить расходы на коммунальные услуги, например, в Вашингтоне или Орегоне. Ноутбум утверждает, что на строительство ЦОД в удаленных местах требуется значительно меньше времени, в некоторых случаях это занимает 6 месяцев, по сравнению с периодом строительства традиционного ЦОД, на который отводится от 18 до 24 месяцев, что также снижает затраты.

Основное преимущество более быстрого строительства заключается в том, что образуется возможность более точно определить какая мощность потребуется Yahoo после завершения строительства, так как значительно проще распланировать необходимую емкость в течение полугода, чем делать это через 2 года.

Кроме того, Нуотбум утверждает, что компания Yahoo начала использовать новый подход, при котором услуги можно резко масштабировать как в сторону увеличения, так и в сторону уменьшения в зависимости от изменения потребностей. В прошлом, центры обработки данных были рассчитаны на конкретное время безотказной работы и конкретные емкости. Но теперь эти параметры могут быть более детальными.

Используя программное обеспечение компании, называемое Yahoo Flex Data Center уровня QOS Дизайн, ИТ-специалисты могут предоставить такой объем электроэнергии, который должен быть использован и такие ДГУ и ИБП, которые обеспечат требуемый уровень резервирования.

Ноутбум приводит следующий пример: электронная почта или поиск может потребовать высокой доступности, в то время как новому бета-сервису для проверке котировок акций она может вовсе не понадобиться.

Yahoo может устанавливать различные уровни QoS для этих приложений. В прошлом, приложения были бы на одном уровне QoS.

Программное обеспечение также позволяет Yahoo перемещать приложения и услуги на сервера с высокой степенью резервирования или использовать кластер, если это возможно, когда один или два узла отключают на короткое время.

Еще один способ масштабирования Yahoo — это приобретение связей с местными коммунальными компаниями. Новые ЦОД запускают с 1 или 2 МВт электроэнергии, но он может быть масштабирован до 20 МВт. До начала строительства, Yahoo заключает контракты на использование нескольких коммунальных услуг в одном центре обработки данных, или заключает гибкие контракты на электроэнергию и даже организовывает различные льготы для каждого уровня обслуживания.

«С точки зрения расходов, это обеспечивает нам большую отдачу от вложенных средств, взамен избыточных инвестиций» — утверждает Ноутбум.

Пока новый гибкий подход QoS работает исправно. Только что построенный дата-центр в северной части штата Нью-Йорк имеет коэффициент эффективности использования энергии 1,08, что достигается главным образов за счет способности адаптировать услуги под требования клиентов. Не каждый ИБП и не каждый сервер работает под управлением в течение всего дня. Очевидно, что ИТ-персонал адаптируется под текущие приложения QoS.

Pund-IT считает, что Yahoo — это что-то необычное. «Это интересный подход, особенно привлекателен к адаптированную QoS приложений. Это может быть существенным для поставщиков облачных слуг, что позволит им лучше структурировать свои предложения для конечных потребителей.

Тем не менее, эффективность ЦОД во многом зависит от месторасположения. Есть не так много мест, где компании могут выбрать коммунальные услуги. Но эта ситуация может измениться точно также, как и то, что альтернативные источники энергии смогут заработать.

Вытяжная труба Intel

Инженеры компании Intel разработали уникальную систему вытяжных труб, которые работают подобно пластиковому занавесу, для удаления горячего воздуха от серверных стоек. В настоящее время Intel сертифицирует технологию вытяжных труб. «Это экономически эффективный способ для сохранения холодного воздуха в холодном коридоре и экономия электричества», утверждает Ким Стивенсон, вице-президент по ИТ компании Intel.

Стивенсон утверждает, что вытяжные трубы, установленные над каждой стойкой, были необходимы, так как многие ЦОД компании Intel расположены в пределах производственных объектов. Некоторые здания не совсем новые, поэтому технология позволила эффективно решать вопросы, связанные с перегревом. Альтернативным выходом для решения проблемы, связанной с выделением тепла в холодном коридоре, могло стать размещение по замене серверов на более энергоэффектиные, стоимость которых была бы гораздо выше.

Кроме того, компания Intel «погрузилась» в эту стратегию для того, чтобы изучить «весь ЦОД, программное обеспечение, серверы, системы хранения, сети и объекты как системы, которые оптимизированы для конкретных потребностей бизнеса», согласно последнему ежегодному IT отчету.

Например, команде дизайнеров из силиконовой долины требуется запускать миллионы рабочих мест в неделю с высокой вычислительной мощностью. Компания Intel IT «приняла эти уникальные требования к высокой вычислительной производительности».

В общем, компания анализирует производительность своих центров обработки данных на основе четырех ключевых показателей: эффективность, качество, емкость и скорость. В этом году, как упомянуто в докладе, Intel планирует «внедрить интеллектуальные иструменты бизнес-аналитики, которые позволят применить концепции цепочек снабжения для наших личных облаков, помогая нам лучше понять спрос для улучшенного планирования емкости».

Еще одно новшество касается того, как Intel управляет удаленным доступом, связанным с изменением бизнес-модели Intel. Традиционно, компания разрабатывала только высокотехнологичную продукцию, в том числе материнские платы и процессоры, а ее дата-центры были закрыты и охраняемы. Теперь Intel расширяет свой бизнес для того, чтобы предоставлять продукты и услуги, которые являются более открытыми.

Например, Intel продает приложения для нетбуков, и компания должна поддерживать пользователей, которые покупают программное обеспечение. Intel использует свой собственный продукт SOA ExpressWay для поддержке всех входящих учетных записей пользователей.

Intel Expressway помог создать безупречную архитектуру политик безопасности, что упрощает и сокращает ненужную аутентификацию, утверждает Стивенсон.

Стивенсон объясняет, что единственной альтернативой было бы инвестирование в дорогое оборудование для символической аутентификацией, связанной с внешними операциям.

По материалам: computerworlduk.com

Всего комментариев: 0