Два дата-центра — две эпохи: фотоэкскурсия по SV1 и SV11 на кампусе Equinix Silicon Valley

Кампус ЦОД колокейшн-провайдера Equinix в Кремниевой долине, США, представляет собой редкий для отрасли наглядный пример эволюции инфраструктуры – от регионального интернет-хаба до «ИИ-фабрики». В пределах одной площадки можно физически проследить развитие подходов к проектированию и строительству дата-центров более чем за четверть века.

ЦОД, спроектированные в конце «девяностых» под задачи, связанные с организацией многочисленных межсоединений и классическими колокейшн-услугами, соседствуют там с современными зданиями, рассчитанными на экстремально высокую плотность мощности IT-оборудования в стойке, жидкостное охлаждение и размещение ИИ-кластеров.

Экскурсия по кампусу Equinix Silicon Valley позволяет увидеть, как менялись инженерные приоритеты: от квадратных метров и количества операторов связи, к которым может подключиться арендатор, — к максимально эффективному управлению тепловыми потоками для нужд масштабируемых GPU-вычислений.

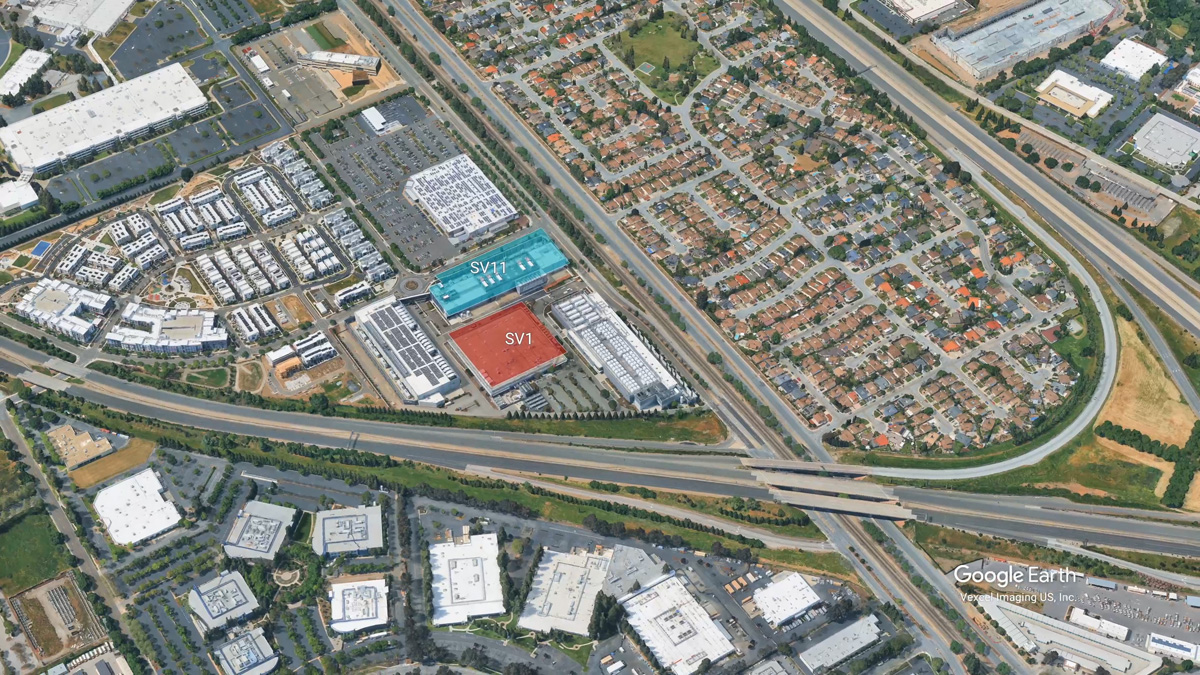

Кампус Equinix Silicon Valley: рост и консолидация

Первый дата-центр Equinix в Кремниевой долине, известный как SV1, был введён в эксплуатацию в 2000 году. В дальнейшем компания последовательно расширяла присутствие на площадке, выкупая прилегающие территории и возводя новые здания. В результате сформировался полноценный кампус, включающий несколько дата-центров. Эти ЦОД связаны общей инфраструктурой, инженерными системами и волоконной сетью.

Последним крупным этапом развития стало строительство SV11 — нового объекта, ориентированного прежде всего на размещение ИИ-нагрузок и высокопроизводительных вычислительных кластеров. В отличие от SV1, SV11 изначально проектировался с учётом высоких требований к мощности, охлаждению и плотности оборудования.

SV1 — «центр интернета» западного побережья США

SV1 получил репутацию «центра интернета» не из-за вычислительных мощностей, но и благодаря беспрецедентной концентрации операторов связи. Более 2 сотен поставщиков телекоммуникационных услуг могут похвастать физическим присутствием своей инфраструктуры в здании.

На начало «нулевых» акцент на подобный ассортимент считался принципиально новым подходом: вместо подключения к одному-двум магистральным операторам клиенты получали доступ к десяткам маршрутов прямо внутри одного ЦОД.

Такой подход резко упростил организацию межсоединений между облачными провайдерами, контент-платформами, телеком-операторами и корпоративными клиентами. Физическая близость позволяла снижать задержки, упрощать маршрутизацию и ускорять запуск сервисов. Даже сегодня SV1 остаётся ключевой точкой обмена трафиком на западном побережье США.

Кабельные колодцы и внутренняя волоконная экосистема

Обеспечить доступность инфраструктуры сотен операторов связи невозможно без вдумчивого проектирования и кропотливой прокладки многоуровневой волоконной инфраструктуры. На территории кампуса используется сложная система кабельных колодцев и для ввода оптоволокна (Fiber Pits). В этих подземных узлах сходятся внешние оптоволоконные линии до входа в здания ЦОД.

После попадания в здание кабели поступают в защищенные центральные волоконные узлы зданий ЦОД (Fiber Vaults), где происходит первичное распределение линий. Далее кабели направляются через промежуточные распределительные рамы (Intermediate Distribution Frame; IDF) к клиентским зонам отдельных арендаторов. Отдельно реализованы межкорпусные соединения, позволяющие клиентам и операторам быстро организовывать связи между разными зданиями кампуса без выхода за его пределы.

Фактически, волоконная инфраструктура кампуса представляет собой самостоятельную экосистему, рассчитанную на непрерывное расширение и перестройку без остановки сервисов.

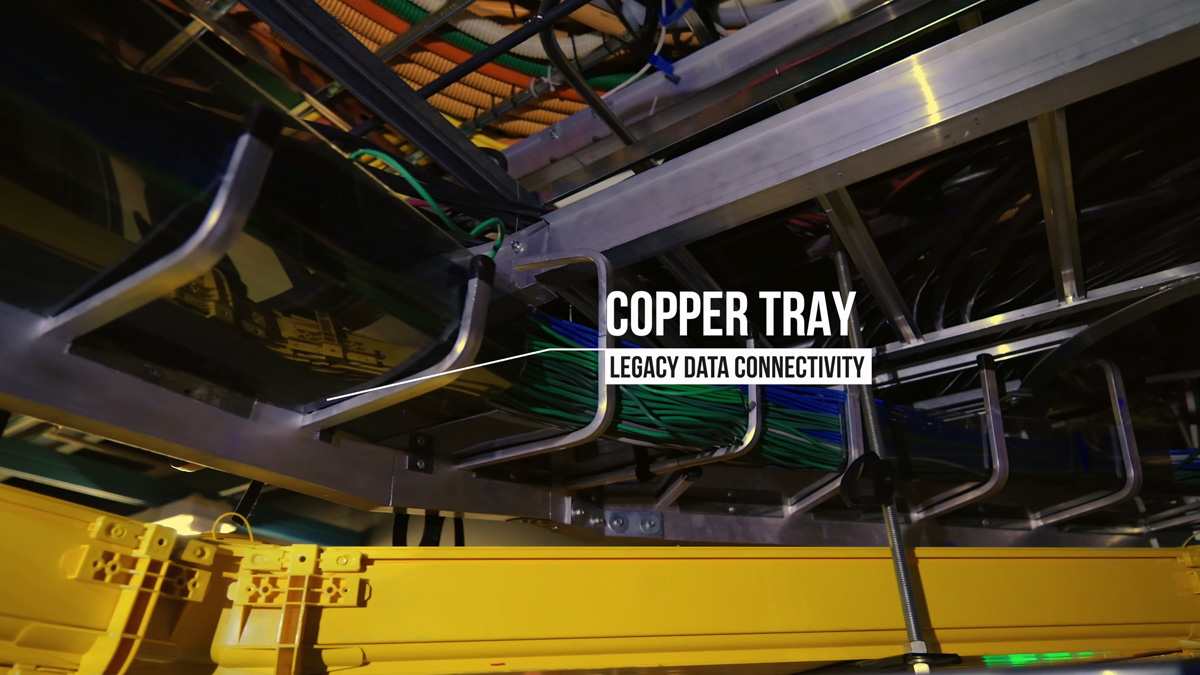

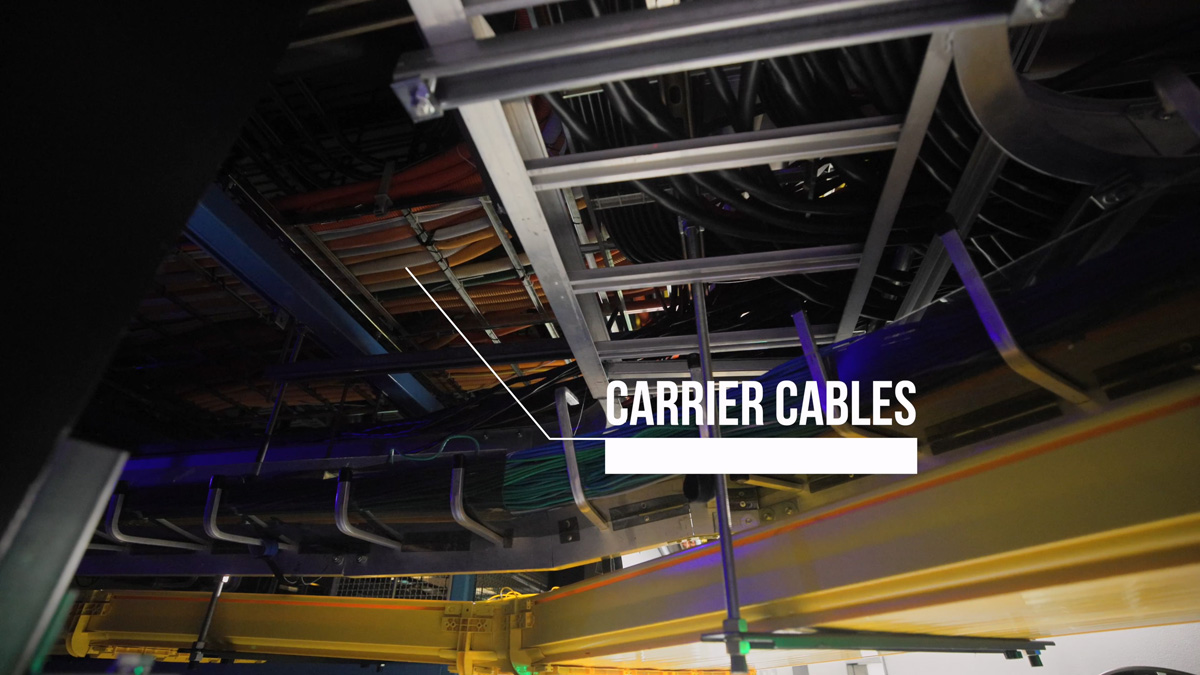

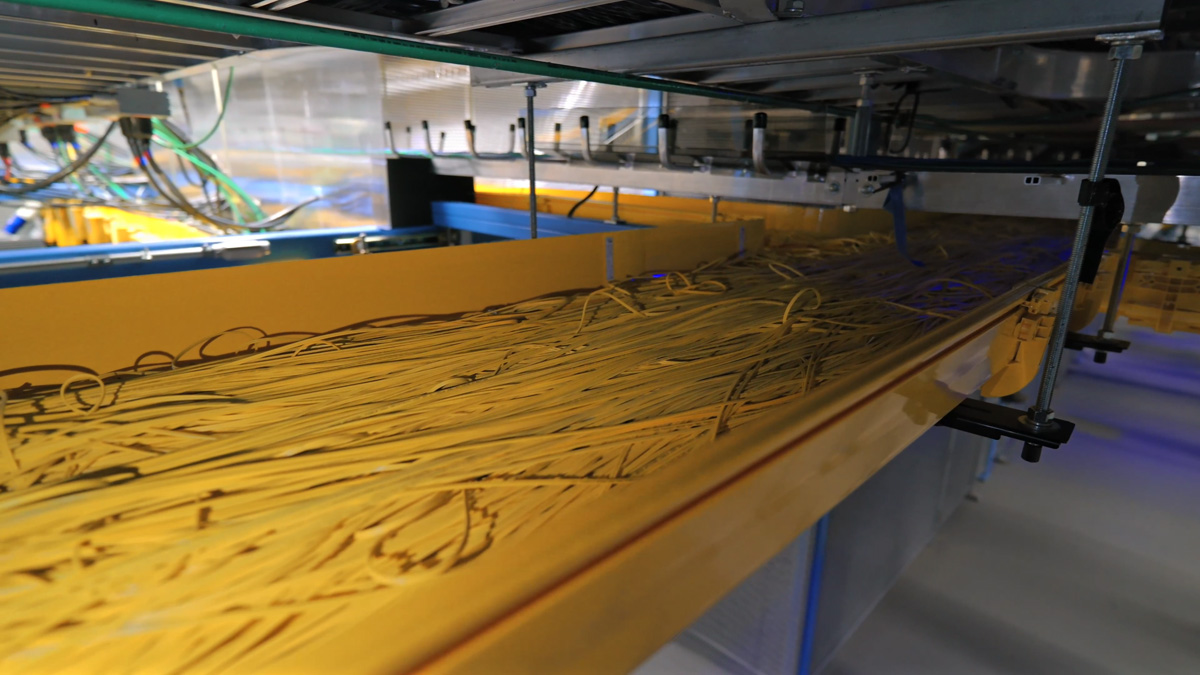

Кабельная архитектура и наследие 25 лет эксплуатации

SV1 строился в эпоху, когда доминировали медные соединения, и лишь часть инфраструктуры рассчитывалась на оптоволокно. За прошедшие десятилетия здание неоднократно модернизировалось, но все апгрейды выполнялись в условиях непрерывной работы.

Кабельное хозяйство организовано по слоям:

- нижний уровень — оптические трассы;

- выше — медные линии;

- затем — силовые кабели переменного тока;

- верхний уровень — магистрали операторов связи.

Такое разделение необходимо для обслуживания тысяч кабелей разных поколений. При этом SV1 продолжает поддерживать устаревшие сервисы, включая T1 и ISDN-линии, которые через медиаконвертеры интегрированы в современную сеть. Это подчёркивает ключевую особенность архитектуры межсоединений местных ЦОД: они обязаны обеспечивать совместимость между оборудованием из разных технологических эпох.

Показательна и эволюция кабельных лотков: изначально использовались 6-дюймовые трассы, затем появились 12-дюймовые, а позже — 24-дюймовые. В некоторых местах даже последних оказалось недостаточно. В результате инженеры начали прокладывать по несколько трасс параллельно. Это непросто, поскольку установка новых лотков в работающем дата-центре требует ресурсоемких процедур и точного планирования.

Архитектура SV1 и логика раннего колокейшн

При проектировании SV1 ключевым показателем была не мощность, а площадь. В начале «нулевых» колокейшн-провайдеры сдавали свою инфраструктуру в аренду, выполняя расчет стоимости по квадратным метрам, а не по киловаттам. Это объясняет компактные проходы, плотное размещение отдельных клиентских зон и минимальные расстояния между стойками.

В то время сервера потребляли значительно меньше электроэнергии и выделяли меньше тепла. Современные требования к плотности мощности просто не закладывались в проект. Тем не менее, SV1 продолжает функционировать, демонстрируя, насколько сложной становится модернизация инфраструктуры, созданной под иные экономические и технические реалии.

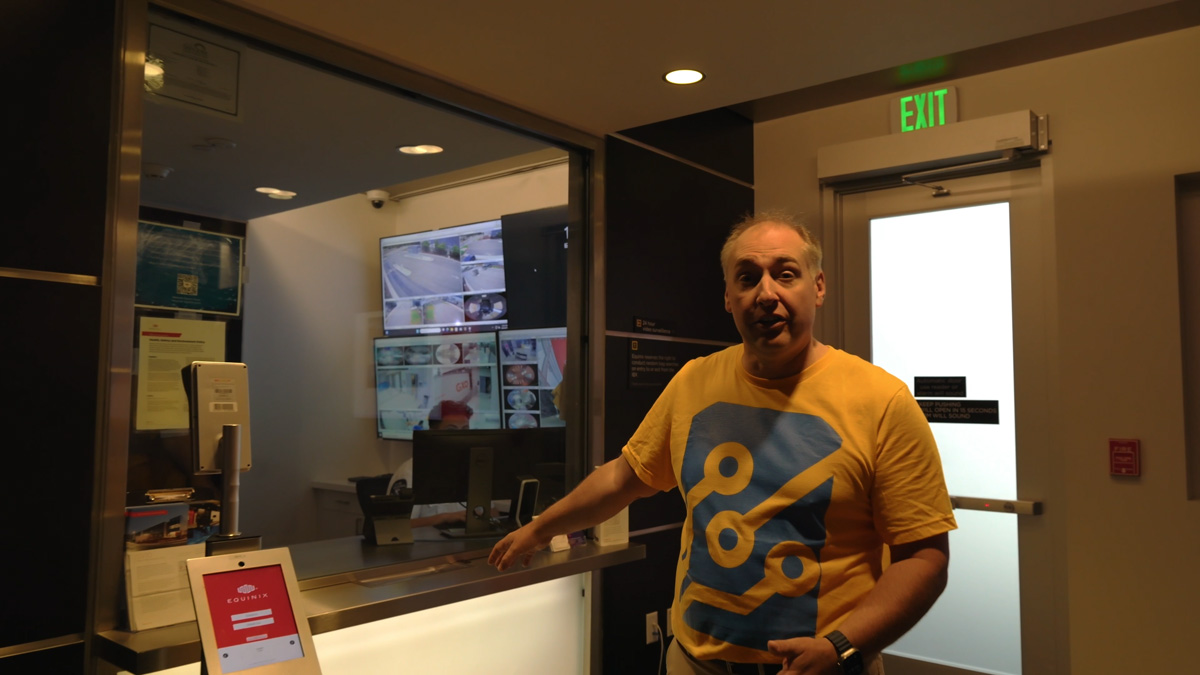

Физическая безопасность кампуса

Equinix использует многоуровневую систему обеспечения физической безопасности. Периметр защищён высокими ограждениями, сложной системой видеонаблюдения и охраной. Для доступа внутрь зданий требуются идентификационные ключ-карты и прохождение биометрической аутентификации. Далее используются шлюзы (Mantrap), где одновременно может быть открыта только одна дверь.

Интересной особенностью кампуса является распределение функций: SV10 используется как основной вход и зона обслуживания, а SV11 соединен с ним переходом. Это позволяет сократить инфраструктуру для персонала в самом SV11 и максимально оптимизировать его под серверное оборудование.

SV11: дата-центр, спроектированный под искусственный интеллект

Здание SV11 отражает современный подход к проектированию дата-центров. Здесь приоритетом стали энергоснабжение, охлаждение и масштабируемость. Здание изначально проектировалось под обслуживание ИИ-нагрузок с помощью высокоплотного IT-оборудования, что заметно отличает его от SV1. Минимизация пространств для людей, упрощённая логистика и концентрация инженерных систем — всё это имеет целью упростить размещение вычислительных кластеров нового поколения.

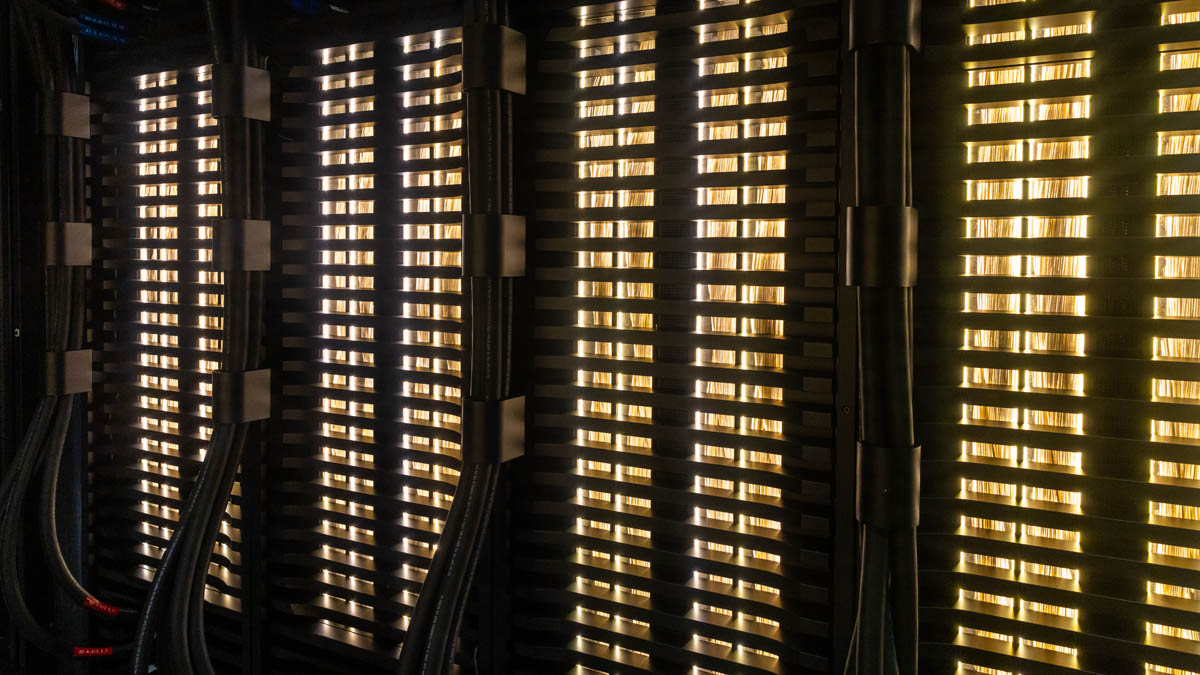

NVIDIA DGX B200 SuperPOD как ядро SV11

В SV11 размещён кластер NVIDIA DGX B200 SuperPOD, состоящий из восьми стоек NVL72. Это ключевой уровень масштабирования в ИИ-экосистеме NVIDIA и платформа, используемая для демонстраций, тестирования и работы с партнёрами.

Кластер расположен именно в кампусе Equinix Silicon Valley не случайно. Наличие сотен операторов связи и большого числа компаний-арендаторов на одной площадке позволяет использовать SuperPOD для пилотных проектов / проверок концепции (proof-of-concept) с минимальными задержками и высокой пропускной способностью.

Equinix выступает глобальным партнёром NVIDIA по развёртыванию SuperPOD, а этот кластер используется как эталон для последующего «тиражирования».

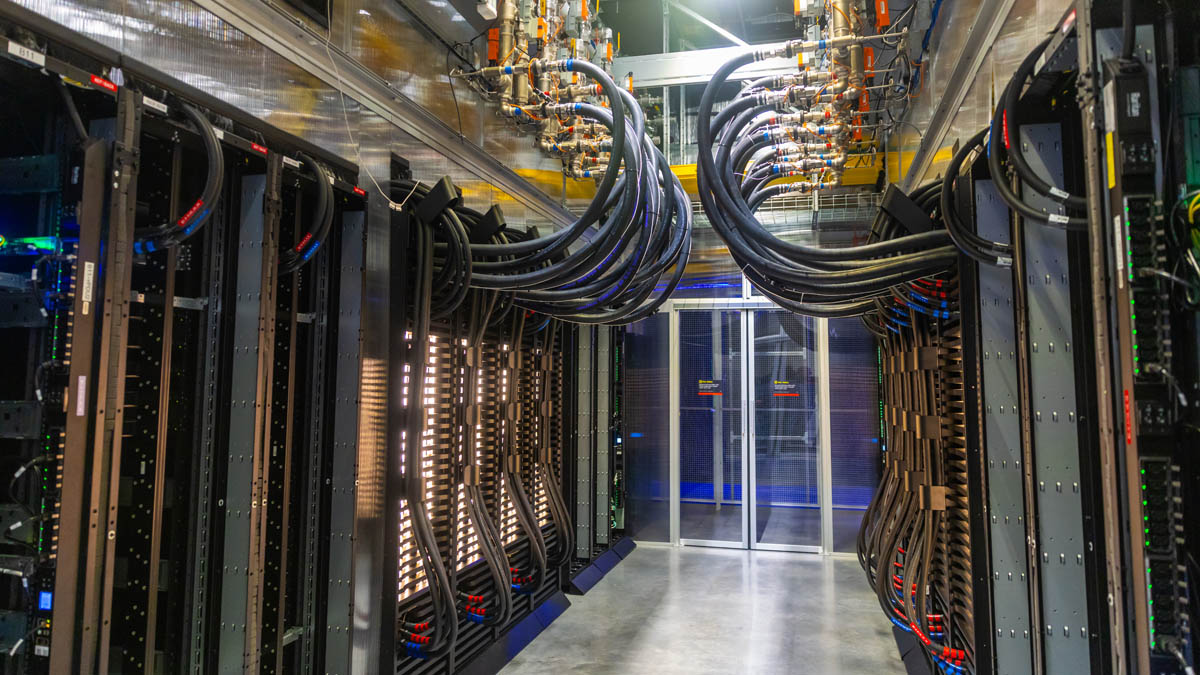

Высокая плотность мощности и жидкостное охлаждение

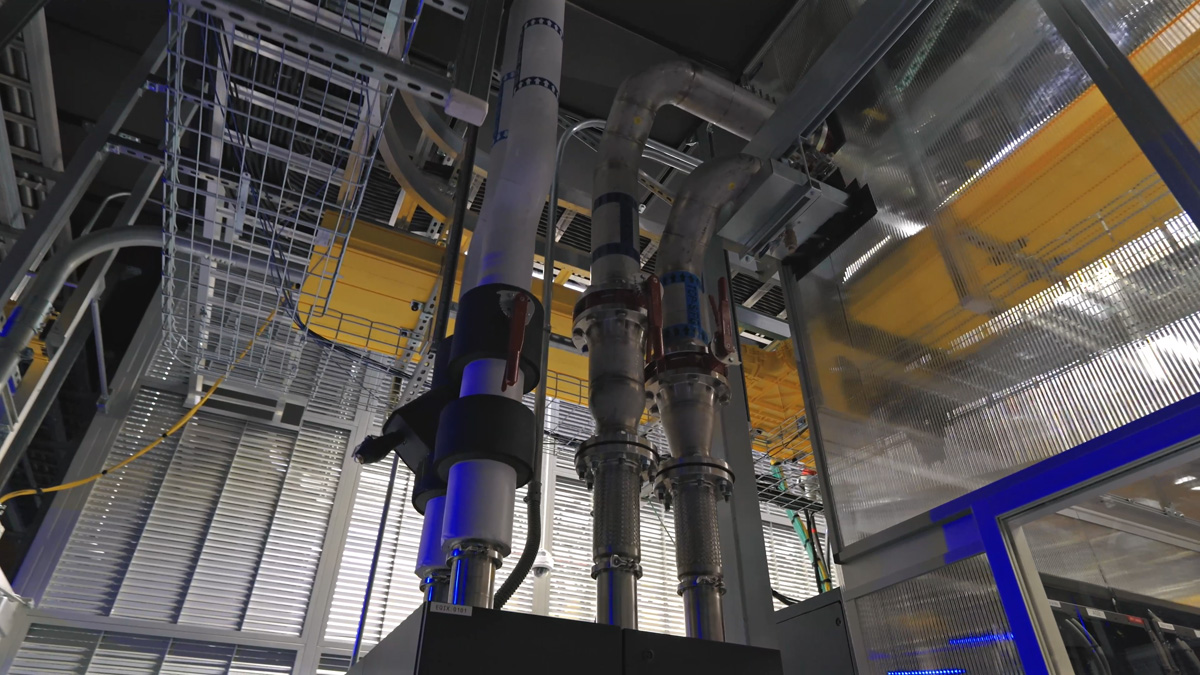

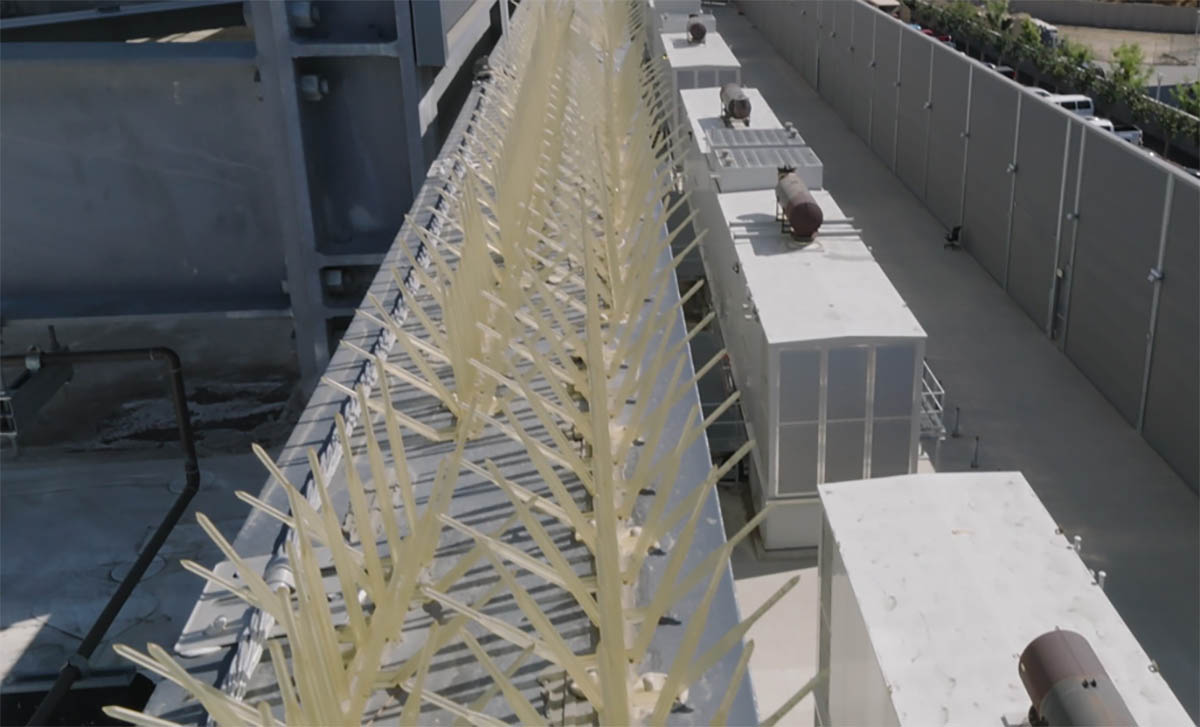

Каждая стойка SuperPOD может потреблять сотни киловатт, а несколько стоек приближаются к мегаваттному уровню. При таких значениях воздушное охлаждение становится неэффективным, поэтому используется жидкостная система.

Архитектура охлаждения построена на разделении контуров: внутри стоек циркулирует собственная жидкость, которая через теплообменники передаёт тепло внешнему контуру всего дата-центра. Далее тепло удаляется к чиллерам на крыше.

Инженеры решили использовать гибкие шланги вместо сварных трубопроводов. Это упрощает масштабирование и повышает повторяемость при серийном развертывании крупных ИИ-кластеров.

Воздушное охлаждение и тепловые потоки

Даже с учетом применения жидкостного охлаждения значительную часть оборудования все еще приходится охлаждать воздухом. В SV11 используется система изоляции воздуховодов: холодный воздух заполняет общий объём машзала, а «горячие» коридоры герметично изолированы и подключены к системам удаления тепла.

Тепло удаляется через теплообменники и передаётся чиллерам, расположенным на крыше здания. Такая схема позволяет эффективно управлять тепловыми потоками даже при высокой плотности оборудования.

Электропитание и генерация электроэнергии

Электроснабжение кампуса организовано через многоуровневую схему. Электричество поступает на площадку извне по сети с напряжением на уровне 21,6 кВ, затем понижается до 480 В и далее — до значений, используемых на уровне стоек (415 В или 240 В). Локальные преобразования в стойках обеспечивают оборудование постоянным током.

Для резервирования используются ИБП и дизель-генераторы. Дополнительно на площадке установлены солнечные панели и топливные элементы Bloom Energy на природном газе. Общая установленная мощность генерирующего оборудования составляет 6,4 МВт, при этом ведётся строительство дополнительных мощностей.

Две эпохи — одна площадка

Дата-центры SV1 и SV11 демонстрируют два принципиально разных подхода к проектированию инфраструктуры серверных ферм. Первый — это многослойная инфраструктура межсоединений, развивавшаяся эволюционно и поддерживающая сервисы разных поколений. Второй — оптимизированная машина для ИИ-вычислений, где каждый метр и киловатт подчинены конкретной задаче.

Их сосуществование в одном кампусе подчёркивает ключевую особенность отрасли: дата-центры проектируются с расчётом на десятилетия, а каждое поколение решений неизбежно становится частью следующего – целиком или частично.

Всего комментариев: 0