Форум Мир ЦОД 2011. Часть 1

Пленарное заседание форума «Мир ЦОД 2011», проводимого «Агенством корпоративных коммуникаций» совместно с издательством «Открытые системы» открыл своим выступлением директор издательства «Открытые системы». Он отметил рост числа участников форума, повышение интереса к мероприятию различных компаний и пожелал успехов форуму, как перспективной площадки для встреч и обменов мнениями ведущих представителей ИТ-рынка.

Векторы рынка ЦОД

Руслан Заединов, заместитель генерального директора, руководитель направления ЦОД компании «КРОК», заметил, что Мир ЦОД – это единственная конференция, которая запомнилась ему из прошлого 2010 года.

Его выступление было посвящено основным трендам развития рынка ЦОД в 2011 году. Так, ЦОД ассоциируется с космическими затратами – на покупку электроэнергии, строительство здания, инженерные системы, ИТ-инфраструктуру, а также эксплуатацию. Поэтому оптимизация этих затрат, разумная экономия – это главный тренд сегодняшнего дня. Здесь можно выделить 3 направления: энергоэффективность, снижение длительности простоев и получение ИТ-мощностей как услуг (т.е. переход в облака).

В качестве примера представлен западный опыт построения энергоэффективных ЦОД: дата-центр Facebook Prineville характеризуется 100% использованием фрикулинга и отказом от inline-ИБП. Из более мелких особенностей можно выделить питание светодиодов по Ethernet. Итог – PUE=1,07.

Фото-экскурсия по новому Дата-Центру Facebook в Прайнвилль, штат Орегон

Второй пример – ЦОД Yahoo LockPort с дизайном здания, подобным курятнику. В Yahoo уверены, что именно такой конструктив позволяет улучшить воздушные потоки (здесь также используется свободное охлаждение, для чего и предусмотрен узкий второй этаж с решетками по бокам). В жаркие дни применяется испарительное охлаждение. Кстати, слова «курятник» в Yahoo совершенно не стесняются и сами именуют ЦОД именно так.

Yahoo построил Дата-Центр по принципу курятника.

Собственный наработки КРОК в части энергосбережения внедрены в ЦОД «Волочаевская-2», завершение работ на котором планируется в этом месяце. Мощность ЦОД составляет 2МВт. Применено 100% электропитание через динамические дизельные ИБП. Энергия в подобных ИБП накапливается на вращающемся роторе. Это не требует создания системы поддержания климата для ИБП и увеличивает их срок службы.

Кроме того, Руслан Заединов более подробно остановился на облачных сервисах. Облака – превращение ИТ-мощностей в услугу – подобны потреблению электричеству из розетки. Сегодня в нашу жизнь вошла новая аббревиатура – DRaaS – Disaster Recovery as a Service – резервный ЦОД как услуга. Любой компании, предъявляющей жесткие требования к бизнес-процессам необходим резервный ЦОД, персонал для восстановления работоспособности, резервные рабочие места и каналы связи. Один из современных вариантов получения резервного ЦОД – это его размещение в облаках.

ЦОД для файлохранилища

Опытом создания собственного ЦОД для контента поделился Сергей Молчанов, заместитель технического директора Mail.ru. Построение ЦОД для контент-провайдеров необходимо, т.к. объемы контента растут, а арендовать большое число стоек дорого.

Опытом создания собственного ЦОД для контента поделился Сергей Молчанов, заместитель технического директора Mail.ru. Построение ЦОД для контент-провайдеров необходимо, т.к. объемы контента растут, а арендовать большое число стоек дорого.

При этом возникают следующие сложности построения ЦОД: его окупаемость составляет 5-7лет, дорогое электричество (87 000 руб. в год за 1кВт, а 1МВт в год обходится в 3млн.долл.), трудности с недвижимостью из-за её дороговизны при покупке или малого числа предложений на долгосрочную аренду.

В то же время для контент-дата-центров харакерны следующие плюсы: возможность использования однотипных серверов и стоек, энергопотребление которых относительно невысоко: около 5кВт/стойка. Также рост объемов контента прогнозируем с высокой точностью, что позволяет правильно спланировать расширение ЦОД.

Оптимальный размер контент-ЦОД, по мнению Сергея Молчанов, определяется с запасом на 2 года роста и составляет 400-450 стоек. Покупка самого мощного оборудования (оно дешевле на единицу мощности) позволяет сэкономить на капитальных сложениях. Ещё одна хитрость, позволяющая добиться разумной экономии, на этот раз на системе пожаротушения, заключается в разделении дата-центра на несколько зон, так как одно большое помещение тушить дороже, чем одно небольшое, на которые поделено большое.

Сергей Молчанов выразился против контейнерных решений. Во-первых, цена стойки в них в 1.5-2 раза выше, чем в стационарных ЦОД, а во-вторых, в любом случае необходим поиск энергии, резервирование источника, подготовка площадки и т.д. Наконец, «сегодня в России нет примеров успешного внедрения в России» — закончил Сергей.

Весьма ценные советы Сергей дал по способам снижения капитальных затрат. В частности, наличие собственного проектного офиса позволит сэкономить 7-12% на проектировании ЦОД, плюс собственный персонал будет гораздо более мотивирован выполнить проект качественно и экономно. Далее, при покупке дорого оборудования можно ориентироваться на б/у-агрегаты. Так, дизельная станция, завезенная из Европы и отработавшая там 20% своего ресурса, стоит на 40% дешевле. Наконец, в погоне за дешевизной следует дублировать только жизненно важные системы. Ведь Tier III на 50% дешевле Tier IV, так зачем строить Tier IV?!

С точки зрения эксплуатации, один из самых действенных способов снижения энергозатрат – повышение температуры в ЦОД.

Таким образом, Mail.ru построил ЦОД 3.5МВт на 428 стоек, сбалансировав качество, стоимость и скорость строительства.

Всеобщая сервисоизация

Олег Наскидаев, руководитель департамента развития и маркетинга DEAC, развил тему облачных вычислений в свете энергосбережения и безопасности.

Европейские тенденции в части облачных сервисов заключаются создание облачно-ориентированных ЦОД, их распределенной сети. Однако нет четких планов по внедрению облаков, виртуализации, стандартизации и автоматизации.

Кроме того, сегодня стала популярной модель Everything as a service. Вместо того, чтобы покупать что-либо своё, совершать капитальные затраты, компании движутся в сторону получения всего в качестве услуги (сервиса). Вместо того, чтобы заниматься непрофильной деятельностью, проще купить услугу у профессионалов. Другими словами, переход от CAPEX к OPEX. В идеале – к низкому и прогнозируемому OPEX.

Важный вопрос – безопасность в облаках. Необходимо проводить регулярный мониторинг систем безопасности. Зато инфраструктура облачных ЦОД способна обеспечить потребности рынка: рост трафика, рост контента, рост требований к скорости.

Компания DEAC имеет два ЦОД, наиболее крупный их которых – дата-центр «Рига» (1400кв.м., 500стоек, Tier IV). Два ЦОД позволяют обслуживать клиентов и более чем 20 стран мира. Основным преимуществом является размещение ЦОД – в Прибалтике – на стыке Скандинавии, России и Европы. В ближайшие 4 года планируется открытие новых дата-центров (до 7шт (Дания, Голландия, Латвия)), а также офисов в Киеве, Франкфурте, Лондоне.

Дата-центр DEAC в командном бункере Советской Армии

Флагманский ЦОД «Рига» компании DEAC

Первый в России Tier IV

Алексей Романов, директор ГУ «Росинформ» и Сергей Сапронов, главный инженер проектов, поведали о строительстве первого в России ЦОД с уровнем надежности Tier IV. Это информационно-вычислительный комплекс Технопарка «Мордовия».

В Мордовии планируют построить ЦОД, стандарта TIER 4

ДАТА-центр будет запущен в январе

Цель – создание многофункционального комплекса, позволяющего обеспечить корпоративный информационный обмен, взаимодействие с населением, предоставить резидентам Технопарка площади для реализации собственных ИТ-проектов с минимальными затратами.

Сегодня закончены общестроительные работы, идет процесс установки оборудования.

В ЦОД организованы три зоны: зеленая зона — свободный допуск для пользователей и демонстрационного зала; синяя зона — зона для резидентов Технопарка, выполняющих свои собственные ИТ-проекты; наконец, красная зона — зона для спецперсонала.

Здание представляет собой многоэтажное строение. Инженерное оборудование (насосная станция, аккумуляторы, баки) занимают цокольный этаж. Первый этаж отдан непосредственно под серверное оборудование. Здесь в трех помещениях сконцентрированы вычислительные ресурсы так, что ИТ-оборудование разного типа (основное вычислительное, телекоммуникационное и системы хранения данных) размещено в разных помещениях. Второй этаж отдан под административный персонал и call-центр.

Одно из достижений, о котором было сказано отдельно, явилась реализация решения, при котором единый дисковый массив одновременно доступен и для открытой, и для закрытой зон. При этом информация, принадлежащая закрытой зоне, предварительно шифруется.

Мощность ИТ-оборудования ЦОД 860кВт, 110 стоек, максимальная мощность стойки – 30кВт.

Электроснабжение – классическая симметричная схема: две подстанции, два генератора, системы ИБП (3хUPS Eaton), обеспечивающее бесперебойное электропитания активного и технологического оборудования. Модульные ИБП позволяют достичь КПД 94% на каждом источнике притом, что они работают при нагрузке ниже 50% (из-за резервирования).

Система холодоснабжения также симметрична: отказ одной половины всю нагрузку на себя принимает вторая половина. Система двухконтурная: наружный гликолевый и внутренний водяной контуры. Бак-аккумулятор вмещает 30м3 воды и обеспечивает 10 минут охлаждения – время, достаточное для запуска дизель-генераторов при пропадании питания от основного источника. Режим фрикулинга полностью обеспечивает холодом ЦОД при наружных температурах ниже -4С, и используется частично при температурах от -4С до +5С.

К ЦОД Технопарк «Мордовия» подведены три независимые волоконно-оптические линии связи пропускной способностью 10 Гбит/с каждая, электропитание (первая категория, особая группа) организовано от четырех независимых источников мощностью около 2,5 МВт

Данный проект будет сертифицирован организацией Uptime Institute на Tier IV. К слову, подобный заказ оценивается в 100 000 долл.

Вполне ожидаем, учитывая, что стоиомость строительства ЦОД Tier III в 2-2.5 раза дешевле ЦОД Tier IV, оказался вопрос о причинах выбора самого высокого уровня надежности.

Сергей Сапронов назвал несколько веских доводов: во-первых, на данный ЦОД планируется возложить систему электронного правительства. Очевидно, что проблемы, например, с интернетом в масштабах компании или с сервисами онлайн-карт и т.д. хоть и не приятны, но не катастрофичны. В то же время проблема медицинского страхования в масштабах региона страны – проблема на порядок более серьезного уровня.

Во-вторых, за данным ЦОД будет закреплена роль централизации районных дата-центров и здесь также надежность стоит на первом месте.

Наконец, в-третьих, заметил Сергей, районные ЦОД, будучи под защитой центрального ЦОД, могут быть построены по уровню Tier II, что является прямой экономией капитальных затрат.

К слову, хотелось бы добавить, что данный ЦОД Tier IV по своей архитектуре является «классикой жанра». Здесь выбраны наиболее безопасные и проверенные технологии. Нет безоглядного завышения температуры ради расширения зоны использования фрикулинга, нет «зелёного» режима ИБП, когда те подают грязное питание напрямую в стойки, нет и других «фокусов» современного рынка инженерии ЦОД.

Облака EMC2

Мукеш Шарма, директор подразделения Virtualization&Private Cloud, EMEA, EMC2, продолжил тему облаков. Так, согласно данным компании EMC2 внедрение облачных технологий позволяет сократить время запуска новой услуги с 6 месяцев буквально до двух часов, что является большим плюсом для компании в условиях современных темпов ведения бизнеса.

Ещё один яркий пример – сама фирма EMC2, в состав которой входят более 3000 пользователей виртуальных машин. При этом, благодаря облачным сервисам появляется возможность быстрой установки патчей и нового ПО на виртуальные машины, что, очевидно, особенно ценят системные администраторы компании.

Бабочка от HP

Подход компании Hewlett Packard к построению ЦОД нового поколения объяснил Александр Зайцев, менеджер по развитию ЦОД в российском подразделении HP. Процесс построения ЦОД в HP можно разделить на 4 этапа: предварительное общение к клиентом (консалтинг), проектирование выбранной архитектуры дата-центра, разработка программ и их внедрение.

При этом, как правило, возникают следующие проблемы: традиционно — недостаток мощности, и проблема срока службы ЦОД. Вторая проблема должна пониматься в следующем аспекте. Дело в том, что ЦОД строится на 5-10 лет, в то время как часть ИТ-оборудования может быть заменена на более современное раньше. При этом изначально спроектированная инженерная инфраструктура должна обеспечить требуемый уровень доступности для этих новых устройств.

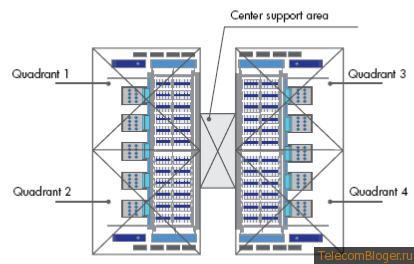

В качестве стандартизированного решения HP предлагает FlexDC («ЦОД-бабочка») – объект из пяти совмещенных зданий. Центральное из них (тело бабочки) – административное, а по периферии 4 технологических строения по 600м2, образующие крылья бабочки.

HP представляет модульный ЦОД в виде “Бабочки”

В случае необходимости строительства действительно большого ЦОД предполагается возведение нескольких таких бабочек. А при малых объемах можно лишь необходимое число технологических строений – одно, два, три или четыре.

Тем самым достигается ступенчатая оптимизация стандартизированного решения под конкретные нужны заказчика.

Автор: Хомутский Юрий

Ребята, нет такой «одна группа, особая категория». Есть ПЕРВАЯ группа. Ну, и не измеряется номинальная мощность в МВт В ЧАС. Что за бред о том, что стоимость Тир-4 в 2.5 раза выше Тир-3? Просто удивительно, до чего некомпетентно рассказано.

И еще очень понравилось про «безоглядное завышение температуры». Отчего безоглядное? Так сказано оттого, что спроектировать оптимум по температуре не смогли? 🙂

Мне кажется, нужно как-то рецензировать статьи, прежде чем бросать их на такой ресурс, как telecombloger, чтобы не дискредитировать. Ведь грамотный человек прочтет, и больше не появится на сайте…

И еще добавлю: здесь — http://telecombloger.ru/844 — почти 2 года назад — говорилось о двух вводах, теперь 4, но самое главное — это такие темпы проектирования сейчас в России???? 2 года??

grey72, как-то вы совсем погорячились с критикой.

МВт/ч — опечатка — признаю

Про группы вы не правы. Есть первая категория, в ней выделена особая группа. см. ПУЭ7 1.2.17.

Безоглядное повышение температуры — это тема наших дней. Все на рынке говорят, что если повысить на 1С, то сэкономить столько-то, а на 2С — ещё больше. В США проводили соотв.эксперименты и тд.

Наконец, 4 ввода не противоречит ведь двум? Больше — не меньше. А там… ну, может, не было двух мощных вводов, пришлось использовать 4.

Юрий,

ПЕРВАЯ группа есть, но вот ОДНОЙ группы — нет. В оригинале было «одна группа, особая категория». Сейчас посмотрел — исправили.

Далее, если 4 ввода, то должно быть 4 системы. А тут их две, стало быть и ввода 2. А четыре — это КАБЕЛЯ четыре. Понимаете разницу?

Насчет температуры — я не согласен с выражением «безоглядное». Проектировщики что, идиоты? Повышение ОЧЕНЬ даже «оглядное» 🙂

grey72, поднял оригиналы, с категориями было напутано. Спасибо за правку!

С 4 вводами всё верно: выше указано — 2 подстанции, 2 генератора.

А про температуру – это рекламщики скорее идиоты, т.к. они пиарят повышенные холодильные коэффициенты, и тд и тп

Правильно, что не пошел. Очередное пылепускание в глаза, с откровенным враньем. Вот проекты по реализации ЦОД у нас шли через ж..у и мы экономили кучу денег и упрощали технические решения донельзя… трансформируется на конференции — КАКИЕ МЫ ГЕРОИ

to:grey72

Спасибо за критику и комментарии. Будем еще более тщательно осматривать и рецензировать публикуемые материалы!